Archiv für die Kategorie „Künstliche Intelligenz“

Bitte stör mich jetzt nicht, ich lese junk content/

das KI-Bild hier hat 15 Arme, geiler junk content/

warum scrollt hier diese Seite nicht, junk content/

der QR-Code zeigt die Preise nicht, junk content/

fünf Sekunden Video plus Idiotenpose, junk content/

gestern neues Smartphone für megageilen junk content/

Wieso soll ich mich noch anstrengen, wenn es draußen keiner mehr tut/

Technologie ist doch was Gutes, wenn es Milliardäre tun/

lasst uns Raketen stationieren auf einsamen Inseln/

mein Grafikprozessor hier malt nur mit ganz groben Pinseln/

Bitte stör mich jetzt nicht, produziere junk content/

warum sieht alles aus wie Scheiße, war wohl junk content/

heute wird alles nur noch ge-liked, war früher junk content/

selbst Politik ist heute Sinnbild für junk content/

jedes Abo 80€, ganz sicher kein junk content/

jedes Update 40€, weil war nie junk content/

Wieso soll ich mich noch anstrengen, wenn es draußen keiner mehr tut/

Technologie ist doch was Gutes, wenn es Milliardäre tun/

lasst uns Raketen stationieren auf einsamen Inseln/

mein Grafikprozessor hier malt nur mit ganz groben Pinseln/

100€ für ein Bluescreen, Code war junk content/

Aktie schießt trotzdem steil nach oben, alles junk content/

der CEO geht heute nicht mehr scheißen, er geht junk content/

früher hieß das alles Scam, heute nur noch junk content/

endlich fliegen wieder Raketen, geiler junk content/

sie erreichen nur leider nie ihr Ziel, junk content/

Wieso soll ich mich noch anstrengen, wenn es draußen keiner mehr tut/

Technologie ist doch was Gutes, wenn es Milliardäre tun/

lasst uns Raketen stationieren auf einsamen Inseln/

mein Grafikprozessor hier malt nur mit ganz groben Pinseln/

Bitte stör mich jetzt nicht, es geht um junk content/

heute ist niemand mehr d’accord, sind alle junk content/

beim Dating wird nicht mehr commited, ist jetzt junk content/

gehen wir Malle oder Bali, Hauptsache junk content/

deine Freundin sagt, sie ist enttäuscht, junk content/

jetzt bist du wieder alleine, egal, gibt doch junk content/

Wieso soll ich mich noch anstrengen, wenn es draußen keiner mehr tut/

Technologie ist doch was Gutes, wenn es Milliardäre tun/

lasst uns Raketen stationieren auf einsamen Inseln/

mein Grafikprozessor hier… STFU verfickte GPU/

Wir schreiben die Nullerjahre und wir fangen gerade an dank einer revolutionären Technik von Aaron Swartz, RSS, uns unsere eigenen digitalen Zeitungen mit RSS-Feeds aufzubauen. Eine meiner frühesten Quellen hier war digg.com, eine Art News-Aggregator der Tech-Welt; man könnte die Website als eine Mischung aus dem heutigen reddit und dem verlorenengegangenen Linksammler del.icio.us beschreiben – inklusive Uservoting. Alles kurz und knackig. Eigentlich für Tech-Nerds immer interessant, immer up2date.

Die Seite verschwand irgendwann. Nicht ohne (Tech-)Skandale. Wurde verkauft, wieder hochgezogen, wieder plattgemacht. Selbst heute habe ich den Feed noch im RSS-Reader, bekomme aber lediglich einen 404er – nicht gefunden.

Nicht mehr lange!

Das Projekt kehrt zurück und das ist für mich persönlich jetzt schon eine der besten Tech-News des Jahres.

Aktuell bekommt man für 5$ Zugang zum Vorschaubereich https://reboot.digg.com/, man wird auf dem Laufenden gehalten zu den aktuellen Entwicklungen. Laut meinen vorliegenden Informationen gibt es noch kein Veröffentlichungsdatum der Live-Version der Website. Natürlich wird KI zum Zug kommen (Moderation), natürlich wird alles eine Nummer kleiner (wohl kein Millionenpublikum mehr). Wenn allerdings die Dinge nicht ganz so beschissen laufen, hat die Seite Potenzial reddit ein wenig ernste Konkurrenz aus der Nische machen zu können.

Ich freue mich darauf! In einer Zeit in der nach und nach gefühlt jedes Indie-Projekt schließt, haben wir hier mit digg eines, das einfach mal aus der Versenkung zurückkehrt. Schöne Web-Zukunft, finde ich. Wenn es richtig und konsequent gemacht wird.

Der ganze KI-Kram da draußen ist alles noch BETA und von künstlicher Intelligenz rein technisch keine Spur weit und breit. Und doch gibt es bereits fünf Typen von Büroangestellten zum Thema „KI bei der Arbeit“:

„Der Maximalist“: benutzt Tools wie ChatGPT und Google Gemini regelmäßig bereits bei der Arbeit

„Der Untergrund“: benutzt die Tools, aber geheim

„Der Rebel“: verabscheut die Tools

„Der Superfan“: freut sich riesig über die Tools, aber hat bis heute keins davon je benutzt

„Der Beobachter“: wartet erst einmal ab und wird man dann sehen

Man kann die Studie als durchaus repräsentativ beurteilen, denn immerhin wurden 5000 Menschen dafür befragt. Kleiner Schmerzpunkt: war halt von Salesforce. Könnte also based sein. Oder ist es ziemlich sicher. Wird jedoch nicht die letzte ihrer Art sein und man darf gespannt sein, wie sich das entwickelt.

Der Link oben liefert auch einen Test, zum selber herausfinden. Der hat bei mir allerdings nicht funktioniert – vielleicht ja bei euch.

„Daten, Daten, schöne fremde Daten!“ – Ed, Cowboy Bebop

Ich habe ChatGPT jüngst gefragt, was aufgrund seiner Datenlage das frühstmögliche Jahr ist, in dem alle natürlichen Ressourcen aufgebraucht sein werden. Der Bot meinte dazu, wohl um 2050 herum.

Öl: beim aktuellen weltweiten Konsum 2050. Quelle: IEA World Energy Outlook und BP Statistical Review of World Energy

Gas: ca. 2070. Quelle: https://www.eia.gov/

Kohle: Ende 21. Jahrhundert. Quelle: https://www.worldcoal.org/

Kupfer: 2070. https://www.usgs.gov/

Phosphor: wenn sich die Praktiken in der Landwirtschaft nicht ändern ca. 2050. Quelle: https://phosphorusfutures.net/

Seltene Erden: 2040. https://www.energy.gov/

Gold: 2044-2054. Quelle: https://usgs.gov/

Silber: 2040-2050. Quelle: https://silverinstitute.org/

Lithium: 2044-2054. Quelle: https://iea.org/

Helium: ca. 2044. Quelle: https://nationalacademies.org/

Uran: Ende 21. Jahrhundert. Quelle: https://world-nuclear.org/

Müssen wir uns jetzt Sorgen machen, dass es nach 2040 keine iPhones mehr gibt? Ach was, NASA regelt:

Och nö, ne: gerade, als wir anfingen KI in Gadgets irgendwie „cool“ und „nützlich“ zu finden, und unsere Zukunftshoffnungen darauf setzten, kommt wohl heraus, dass es nichts weiter als ein Scam ist.

Echt traurig!

Naja egal, Zeitgeist, machen wir einen weiteren OF auf, um an Geld zu kommen!11

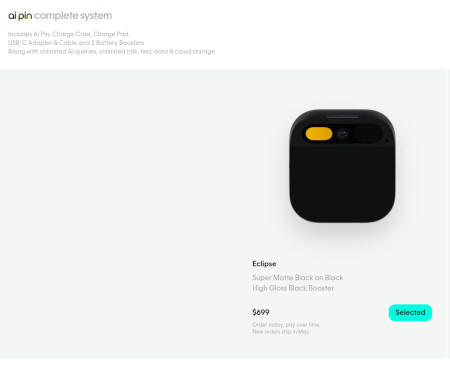

Nee, ernsthaft, zum Beispiel der Humane AI Pin:

„…reagiert sehr träge“

„…antwortet in etlichen Fällen auch mit falschen Informationen“

„…eingebaute Kamera liefert in nicht optimalen Lichtverhältnissen keine guten Videos“

„…Gerät heizt sich oft auf“

„…besonders negative Kritiken bekommt der Projektor“

Boing! Ende vom Lied, die wollen ihr tolles Startup bereits nach wenigen Wochen verkaufen. Und wir warten weiter auf die „Smartphoneablösung“. Au weia… [via] [via]

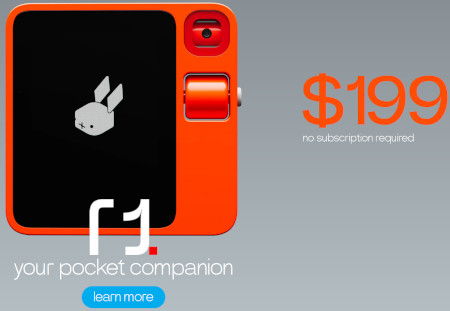

Weiteres Beispiel, der Rabbit R1, „rabbit r1 it’s a SCAM“:

„…a mishmash of poorly executed features and a good dose of scams“

„…from a company previously involved with NFTs and „pay-to-win“ games (which use NFTs)“

„…instructions are hardcoded into the device, meaning that most actions are predefined“

„…what Rabbit R1 does is similar to automation we perform when using Selenium IDE to input passwords“

Tjop. [via]

Den dritten Tipp, den ich damals vorgestellt habe, habe ich mittlerweile vergessen; habe aber auch keine Lust mehr das zu recherchieren, weil die Ergebnisse der zwei vielversprechendsten „KI-Gadgets“ reichten mir schon völlig. Sry.

Irgendwie sind die Zeiten gerade echt beschissen. Man könnte das Gefühl haben, nichts funktioniert (mehr). Ich geh wieder zurück ins Kinderzimmer, zocke GameBoy aus 1990, der läuft sogar heute noch. Bye!

Ja, alles geht den Bach runter…

But behold: nicht für Gadgets! Harhar!

Wer zum Beispiel ein aktuelles Smartphone mit KI-Funktionen sucht, der ist mit dem Pixel 8 oder dem Samsung S24 bestens bedient. Zwar weiß noch keiner, was das alles soll und überhaupt. Doch wer Angst vor der Zukunft hat, in KI mal reinschnuppern will und auf sein Telefon eben nicht verzichten möchte – hier kann man bereits heute ein bisschen Teil an der Zukunft haben. Mit all seinen Einschränkungen und Macken. Und auch nur durch die Brille von Google und Samsung versteht sich.

Ich. Will. Mehr!

Mich interessiert immer „der neue heiße Scheiß“ mehr als das ganze andere Zeug. Also lasst uns gleich einsteigen mit: dem Humane AI Pin.

Das ist ein KI-Roboter zum Anstecken an die Kleidung aus San Francisco, USA. Ab 699$/644€ bekommt man das Gerät inklusive Ladebox, USB-C-Adapter und 2 Ersatzbatterien. Persönlich muss man selbst die eigenen Datenwälle öffnen für die „KI-Cloud“, die noch einmal mit 24$/22€ pro Monat zu Buche schlägt. Ich stelle mir das wie „ChatGPT für die Jacke“ vor. Das Ding sammelt alles, um euer Lieschen-Müller-Leben zu verstehen, denn es will ja euer nützliches Roboterhelferlein sein. Man kann seine Zweifel haben, ob da alles so gut läuft (Alexa, ehemmm…). Die Idee ist aber ziemlich genial, vergisst man einen Moment die Datenschutzbedenken und den monatlichen finanziellen Aufwand.

Weiter geht’s mit dem 01 light:

Ganz ehrlich: I have no f***ing clue what this sh*t is. Aber immerhin gab es eine „erste Vorschau“ „irgendwo im Internet“. Und: wenn jemand reinschreit, das sei als das „Linux der KI-Hardware“ zu verstehen werde ich leicht hellhörig. Mein Unterbewusstsein sagt dann „ja, mach doch!“ Mein Bewusstsein meint dazu „ja, träum weiter“. Lasst es sie versuchen, was auch immer dabei herauskommt. Für 109$/100€ hat man eigentlich nicht viel zu verlieren. Zumal wir ITler all die Problematiken alltäglich kennen, immer die selben Tasks ausführen zu müssen. Vielleicht kann das Ding hier ja helfen, kommt aus Seattle(?), USA(?). Wobei der Code liegt ja bei GitHub herum. Man kann sich eines selbst bauen, wenn man will.

Zum Abschluss kommen wir zum Star der CES 2024: dem Rabbit R1.

Kein Artikel zu einer neuen „Ära der Gadgets“ darf aktuell ohne dieses kleine Pokédex enden. Die ersten Geräte sollten eigentlich schon bei den Endkunden sein (Ende März). Es funktioniert ähnlich wie der Pin oben. Allerdings ohne monatliches Abomodell und kostet 199$/183€. Der Hardwareentwickler Teenage Engineering hofft damit „die Ära der Smartphones beenden“ zu können. Was ein hehres Ziel ist. Und gleichzeitig gnadenlos überambitioniert. Es ist das Gadget mit dem größtem Überhype. Wobei, der Star einer gesamten Elektronikmesse zu sein, noch dazu der CES, das wirst du nicht, wenn du dauernd nur Blödsinn brabbelst. Vielleicht ist ja was dran, die ersten Reviews dazu sollten ja in den einschlägigen Techmagazinen in den nächsten Wochen nachzulesen sein.

Was sagt uns das alles? KI-Gadgets sind „the next big thing“. Wobei, das hieß es bei Krypto auch und dem Metaverse. Und VR seit 30 Jahren. Solange die aktuell erhältlichen KI-Tools nur Schachfiguren in schwarzer Farbe produzieren habe ich eigentlich kaum Hoffnung, dass sich das bewahrheitet. Schlechtreden will ich das alles aber auch nicht, denn: wir werden nicht oft selbst Zeuge solcher Wellen sich komplett verändernder Technologielandschaften. Cool ist es allemal und höchst interessant. Weshalb solche Medien wie hier, gizmeo, sich freuen können wieder eine Daseinsberechtigung zurück zu haben. Ich bin gespannt.

One more thing: was macht eigentlich Apple? Die haben gerade ihre Apple-Auto-Träume eingestampft. Das alte Team soll sich 100% auf KI-Themen konzentrieren. Was dabei herauskommt, niemand weiß es aktuell. Die Taktik hier ist mindestens defensiv – das muss bei dem Quatsch, der aktuell bei den Endkunden ankommt aber nicht schlecht sein. Genügend neue Spieler am Markt gibt es allemal, ich hoffe der Artikel hier erwähnte sie alle. :p

Zwei Minuten aus diesem Vortrag von Tristan Harris und Aza Raskin machen gerade ein bisschen die Runde im Internet:

Der Titel dieser Stunde lautet „Das KI-Dilemma“ und wurde vor vier Tagen im Rahmen des Events summit.co hochgeladen.

In dem Beitrag beschreiben die beiden Gründer vom Center for Humane Technology eine durch machine learning trainierte Traumentschlüsselung. Also eine Person bekommt einen kurzen Animationsfilm zu sehen, der Computer dechiffriert hinterher in Textform ziemlich genau, was die Person sah. Oder auch eine ebenso trainierte Software für WLAN-Geräte, die Personen durch Funkwellen in Räumen erkennen soll.

Der Vortrag ist sehenswert und sollte aktuell bei der hysterischen KI-Diskussion nicht vergessen werden. Er ist richtig und wichtig. Nicht ganz nachvollziehen kann ich, weshalb er nur 3700 Aufrufe bisher hat. Das ist ein YouTube-Video einer Konferenz zu einem IT-Thema der Stunde und schon mehr als seltsam.

Algorithms are „cool“ and run anything these days: from your smartwatch to the chatbot you are asking about stock trading options online.

From time to time we find useful algorithms for usage in a specific field; if you do what I do here, measurements about your key performance indicators (KPIs) is all around your texts. So of course this cool text iq calculator (or estimator, as it’s officially called) was of utmost interest to me:

Basically what it does: you input your (preferably English written) text with at least 50 words into the text field and hit the button „Estimate IQ of text author“. The result should be pretty self-explanatory.

For the light-package travelers, here is what to make up of the results by the author of the webapp:

„As accurate as one would expect such an algorithm to be. As „proof“ I have run the algorithm on a few examples, and you can see that the results aren’t surprising (nor should they be).

* Stephen Hawking, using his last paper as the sample, achieves an IQ of 151.

* Alexander Hamilton, using Federalist paper number 6 as the written sample, achieves an IQ of 166.

* Testing different CNN reporters using their articles, I got IQs ranging from 102 to 127.

* Testing different 5G-coronavirus conspiracy theorists using posts from one of their Facebook groups, I got IQs ranging from 75 to 89.“

Let’s run it and see how I’m doing there, shall we? My last five English language contributions here:

https://gizmeo.eu/banksy-in-lisbon/ – Estimated IQ: 102 (above average)

https://gizmeo.eu/armageddon-sounds/ – Estimated IQ: 110 (above average)

https://gizmeo.eu/review-stray/ – Estimated IQ: 107 (above average)

https://gizmeo.eu/neuromancer-vs-my-gpu/ – Estimated IQ: 135 (genius) (hint: I had quotes in here from Cyberpunk mastermind himself in my text, William Gibson…)

https://gizmeo.eu/cpu-dreams/ – Estimated IQ: 101 (above average)

Not bad for a gadget weblog! And English isn’t even my primary language. Take that, CNN, harhar!

Final verdict: if you want to have a quick check if what you are reading in English is not done by a full retard, https://writingtoiq.com/ could be very useful. I didn’t find a source code reference and could do a quick check of the algorithm but the app does what it promises. I can recommend it.

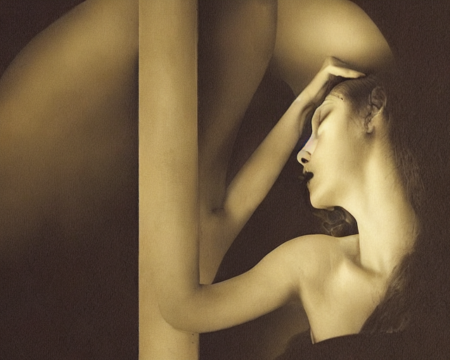

Wie meine Grafikkarte sich Femdom im Weltall vorstellt – dank Stable Diffusion

Sollte es irgendwann mal darum gehen ernsthaft fremde Planeten und Sternsysteme zu besiedeln, ist die Frau die bessere Wahl für Crews im Weltall, fand die ESA heraus: sie verbrauchen weniger Kalorien. Weniger Sauerstoff. Und weniger Wasser als Männer. Außerdem setzen sie weniger Kohlendioxid und Wärme frei. Körpergröße spielt darüberhinaus keine Rolle, selbst bei identischen Körpermaßen hat die Frau den effizienteren Stoffwechsel.

Quantifizieren lässt sich das alles auch: eine Weltraummission über drei Jahre mit vier Astronautinnen spart alleine 1,7t an Nahrung. Man hätte 2,3 Kubikmeter mehr Platz. Und spart 158 Millionen US-Dollar bzw. 141,5 Millionen Euro bei der Mission. Zu hart, das!

Wer hätte das gedacht: Ellen Ripley ist doch realistischer als man(n) denkt! EZ!

Wenn du weißt, dass du als Unternehmen gerade gefickt wirst, holst die Gründer zurück:

„ChatGPT hat den Suchmaschinenriesen auf dem falschen Fuß erwischt: Google holt die Gründer zurück, um eigene KI-Projekte voranzubringen.“ [via]

Was wir aktuell gerade bei ChatGPT an Hype erleben ist die Wiederholung des Hypes um Eliza aus den 60ern des vergangenen kaputten Jahrhunderts (wir erinnern uns: der allererste Chatbot) und auch die Phänomene des menschlichen Erstaunens sind genau die selben. Sie entstammen der menschlichen Neugier, Inkompetenz, Fantasie, der Sucht nach der ultimativen Unterhaltung und dem Verlangen des eigenen Untergangs.

Dabei haben wir dringendere akute Probleme derzeit, wie die Stellung der Doomsday Clock auf 90 Sekunden vor Mitternacht; ein desolater Zustand, Premiere überhaupt seit es diese Uhr gibt und eine traurige Einschätzung vieler Wissenschaftlerinnen und Wissenschaftler weltweit für unsere menschliche Zukunft. Ein Eliza 2.0 wird dazu wenig beigetragen haben.

Es sei wie es sei, Page und Brin tun gut daran nicht M$ zu folgen und alles in die ChatGPT-Waagschale zu legen, was sie haben. Das werden sie auch nicht tun, dafür sehe ich beide immer noch als zu visionär, zu ausgebufft, zu kompetent in Sachen IT. Es wird was Gutes haben, dass die beiden darauf antworten werden. Und wieder wird es ein Wettrennen der Zukunftstechnologie nur innerhalb der USA geben, weshalb man Europa erneut wieder nicht leiden können wird. Wir verkacken hier immer noch unsere (IT-)Zukunft, wo sind eigentlich unsere EU-Brins und -Pages, wenn man sie braucht?

There’s something romantic and beautiful if you can get it right from a cyberpunk perspective when even AAA titles fail completely in our current times. I’m glad about the gaming experience we are able to have in „Stray“! Read here in short why.

Above: launch trailer for „Stray“, available since 09/20

You play as a cat!

I can’t remember this was tried often in the past but being able to perceive the world from a cat perspective is a rather unique experience. You realise during the game that there were other thoughts put into this piece of software as in „Blade Runner“ (1997) or „Cyberpunk 2077“ (2020), for example, which is nice. In 95% of the cases this works like a charm. In the other 5% you ask yourself why you can’t proceed or the developers won’t let you proceed. Because as a cat, you would have tried it the cat way there.

The cat wears a backpack!

The funny part is, you don’t get it from the beginning of the game which is fresh: of course we all need to learn how to be a cat, there’s no time for gimmicks at first. But when you get it, you learn that it even has space for your personal drone. Which acts as your companion throughout the game, can give you hints about the world and characters, as well as be the tech or hack aspect we love to have in any cyberpunk game. There are surprises too here with this drone but these I won’t spoil. Just play it. Just this: if you’re lucky you can even customise it in game, be it the skin or you get buttons to wear for done robot tasks.

There’s a button to meow!

In the beginning you think this is another gimmick in this specific game. But while you progress throughout the game you realise this is your only way of communication (of course, you are a cat!), so you fastly start to love it. It’s one of those fine small features we love from indie games. And „Stray“ surely delivers with this. Up to the point that if you own a cat and press this button, be sure your real cat is responding in a way or the other.

The soundtrack!

Sounds and music, all original. Gamers couldn’t be more satisfied here!

The world is believable!

Of course there were real life examples for the unique city you experience in „Stray“ and its story. However, the way it is built here (for the cat) as well as the cyberpunk elements all over the place just hit the nerve. You possibly won’t believe what’s it all about until the very end, when the secrets are lifted in a very great finale. I’m 40 and I was impressed, hit back really. If you think throughout the game you already saw the saddest elements, you will be surprised. Again, I won’t spoil it. Let’s just say it sent shivers down my spine.

Of course there are some negative elements too which you could mention but these are not critical for the overall game experience: it’s a bit short (10 hours if you collect all the memories), as well as technologically a bit behind with version four of the Unreal engine. But it’s an Indie game, so I didn’t care much and you shouldn’t either. If you are interested in cyberpunk topics, you’ll love it and it’s a must-have!

9/10

.: recommended! :.

:: Introduction

I think of Neuromancer as a pretty complicated novel. Written in 1984 by William Gibson it is one of the earliest pieces of literature of cyberpunk genre, part of its Kanon today, so to speak. Anyone interested in cyberpunk will encounter it sooner or later. And anyone could read something different in it. Part of it, it’s written from the future and not only covers artificial intelligence, hacking, virtual worlds/cyberspace, drugs, ROMs; you could go on and still not grasp the vastness here. After reading, I was not really sure if even Gibson understood what he published here. But we are cool with it, as this is another factor for one’s sympathy for this 271-pager.

Today, there are websites which aggregate the most popular quotes like the one from Goodreads here. I’m pretty sure with some of the text snippets alone, you will have problems not only from semantics perspective but also from the vocabulary alone. This is innovative and futuristic but hinders a reader from truly enjoying it. Nevertheless, the cryptic groundwork was taken often as the basis for some nice artwork pieces, like the 48-page graphic novel released in 1989 by Tom de Haven and Bruce Jensen. Heck, I even think, as I own the graphic novel too and read the novel first, that you might be better off with the graphic novel and leaving the book all alone. Although I won’t recommend it, as you know, we are all cyberpunks ourselves here.

:: My proof of concept

No matter how complicated and exotic the text, I thought this would be a perfect basis for some of my further experiments with machine learning artwork generation. I thought maybe it’s better just to leave my hardware alone: should my GPU make sense of these lines now! We are 2022, with engines like Stable Diffusion and a recent laptop, this sounds like a piece of cake! So I took the most popular quotes from the novel, the ones which made sense in creating something which a reader’s mind could have difficulties with, and let it run through my (laptop) GPU. I picked the best one from three which were created simultanously per quote in approx. three minutes. Without further ado, let’s check the results here! You can click on the pictures to see the original size. Enjoy!

:: Neuromancer vs. my GPU

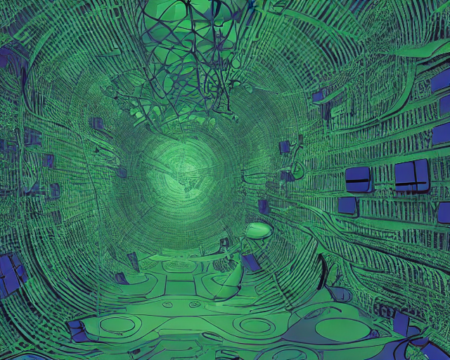

„Cyberspace. A consensual hallucination experienced daily by billions of legitimate operators, in every nation“

„His eyes were eggs of unstable crystal, vibrating with a frequency whose name was rain and the sound of trains, suddenly sprouting a humming forest of hair-fine glass spines“

„We have sealed ourselves away behind our money, growing inward, generating a seamless universe of self“

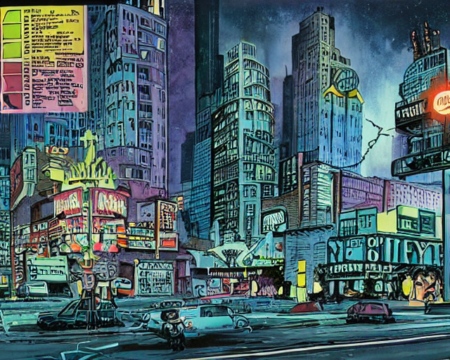

„Night City was like a deranged experiment in social Darwinism, designed by a bored researcher who kept one thumb permanently on the fast-forward button“

„Don’t let the little fuckers generation gap you“

„Lost, so small amid that dark, hands grown cold, body image fading down corridors of television sky“

„We monitor many frequencies. We listen always. Came a voice, out of the babel of tongues, speaking to us. It played us a mighty dub“

„And in the bloodlit dark behind his eyes, silver phosphenes boiled in from the edge of space, hypnagogic images jerking past like a film compiled of random frames“

„Case shuffled into the nearest door and watched the other passengers as he rode. A pair of predatory-looking Christian Scientists were edging toward a trio of young office techs who wore idealized holographic vaginas on their wrists, wet pink glittering under the harsh lighting“

„His vision crawled with ghost hieroglyphs, translucent lines of symbols arranging themselves against the neutral backdrop of the bunker wall. He looked at the backs of his hands, saw faint neon molecules crawling beneath the skin, ordered by the unknowable code“

„The Matrix has its roots in primitive arcade games,‘ said the voice-over, ‚in early graphics programs and military experimentation with cranial jacks.'“

„INTO HER DARKNESS, a churning synaesthesia, where her pain was the taste of old iron, scent of melon, wings of a moth brushing her cheek. She was unconscious, and he was barred from her dreams“

„Rain woke him, a slow drizzle, his feet tangled in coils of discarded fiberoptics. The arcade’s sea of sound washed over him, receded, returned. Rolling over, he sat up and held his head“

„To call up a demon you must learn its name. Men dreamed that, once, but now it is real in another way. You know that, Case. Your business is to learn the names of programs, the long formal names, names the owners seek to conceal“

„It was a vast thing, beyond knowing, a sea of information coded in spiral and pheromone, infinite intricacy that only the body, in its strong blind way, could ever read“

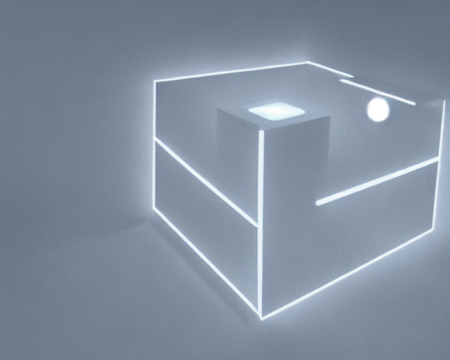

„Wintermute was a simple cube of white light, that very simplicity suggesting extreme complexity“

:: Outro

I was happy that my POC was a success, of course. And I was also pretty convinced by what my graphics processor could make of those rather difficult novel lines from the 80s in our current times. However, I also see some difficulties when StableDiffusion tries to render certain things: like human appearance, as oftentimes it outputs strange limbs and also faces, especially around eyes. Same goes for text, as seen in some of those (rather grotesque) examples. Both problems could be shared with other tools like DALL-E 2 or Imagen though, I never tried those before. It’s a very young brand new technology of course, this is common. From artwork perspective, I also am not sure if this is really a problem. Furthermore, I think this is a perfect example for what we do from read-write culture. Which can’t be emphasised enough nowadays, because what we originally intended back then, generate reciprocal relationship between the producer and the consumer, wasn’t taken up by people as we intended. Like ever. Stupid, unreasonable consumerism won, unfortunately. As such, this might be not the last project of its kind I did by myself, as I got enough books in my private library which could need clarification visually. But in the history of the web, probably very much so. Let me know what you think in the comments, hope you had a great time exploring this!