Archiv für die Kategorie „Zukunft“

Zwei Minuten aus diesem Vortrag von Tristan Harris und Aza Raskin machen gerade ein bisschen die Runde im Internet:

Der Titel dieser Stunde lautet „Das KI-Dilemma“ und wurde vor vier Tagen im Rahmen des Events summit.co hochgeladen.

In dem Beitrag beschreiben die beiden Gründer vom Center for Humane Technology eine durch machine learning trainierte Traumentschlüsselung. Also eine Person bekommt einen kurzen Animationsfilm zu sehen, der Computer dechiffriert hinterher in Textform ziemlich genau, was die Person sah. Oder auch eine ebenso trainierte Software für WLAN-Geräte, die Personen durch Funkwellen in Räumen erkennen soll.

Der Vortrag ist sehenswert und sollte aktuell bei der hysterischen KI-Diskussion nicht vergessen werden. Er ist richtig und wichtig. Nicht ganz nachvollziehen kann ich, weshalb er nur 3700 Aufrufe bisher hat. Das ist ein YouTube-Video einer Konferenz zu einem IT-Thema der Stunde und schon mehr als seltsam.

Algorithms are „cool“ and run anything these days: from your smartwatch to the chatbot you are asking about stock trading options online.

From time to time we find useful algorithms for usage in a specific field; if you do what I do here, measurements about your key performance indicators (KPIs) is all around your texts. So of course this cool text iq calculator (or estimator, as it’s officially called) was of utmost interest to me:

Basically what it does: you input your (preferably English written) text with at least 50 words into the text field and hit the button „Estimate IQ of text author“. The result should be pretty self-explanatory.

For the light-package travelers, here is what to make up of the results by the author of the webapp:

„As accurate as one would expect such an algorithm to be. As „proof“ I have run the algorithm on a few examples, and you can see that the results aren’t surprising (nor should they be).

* Stephen Hawking, using his last paper as the sample, achieves an IQ of 151.

* Alexander Hamilton, using Federalist paper number 6 as the written sample, achieves an IQ of 166.

* Testing different CNN reporters using their articles, I got IQs ranging from 102 to 127.

* Testing different 5G-coronavirus conspiracy theorists using posts from one of their Facebook groups, I got IQs ranging from 75 to 89.“

Let’s run it and see how I’m doing there, shall we? My last five English language contributions here:

https://gizmeo.eu/banksy-in-lisbon/ – Estimated IQ: 102 (above average)

https://gizmeo.eu/armageddon-sounds/ – Estimated IQ: 110 (above average)

https://gizmeo.eu/review-stray/ – Estimated IQ: 107 (above average)

https://gizmeo.eu/neuromancer-vs-my-gpu/ – Estimated IQ: 135 (genius) (hint: I had quotes in here from Cyberpunk mastermind himself in my text, William Gibson…)

https://gizmeo.eu/cpu-dreams/ – Estimated IQ: 101 (above average)

Not bad for a gadget weblog! And English isn’t even my primary language. Take that, CNN, harhar!

Final verdict: if you want to have a quick check if what you are reading in English is not done by a full retard, https://writingtoiq.com/ could be very useful. I didn’t find a source code reference and could do a quick check of the algorithm but the app does what it promises. I can recommend it.

Wie meine Grafikkarte sich Femdom im Weltall vorstellt – dank Stable Diffusion

Sollte es irgendwann mal darum gehen ernsthaft fremde Planeten und Sternsysteme zu besiedeln, ist die Frau die bessere Wahl für Crews im Weltall, fand die ESA heraus: sie verbrauchen weniger Kalorien. Weniger Sauerstoff. Und weniger Wasser als Männer. Außerdem setzen sie weniger Kohlendioxid und Wärme frei. Körpergröße spielt darüberhinaus keine Rolle, selbst bei identischen Körpermaßen hat die Frau den effizienteren Stoffwechsel.

Quantifizieren lässt sich das alles auch: eine Weltraummission über drei Jahre mit vier Astronautinnen spart alleine 1,7t an Nahrung. Man hätte 2,3 Kubikmeter mehr Platz. Und spart 158 Millionen US-Dollar bzw. 141,5 Millionen Euro bei der Mission. Zu hart, das!

Wer hätte das gedacht: Ellen Ripley ist doch realistischer als man(n) denkt! EZ!

Jetzt, da alle nur noch schwul und/oder Transen sind, kann ich es ja endlich mal sagen:

ich. wür. de. so. ger. ne. mein. schwanz. in. ein. mäd. chen. steck. en. mäd. chen. steck. en. mäd. chen. steck. en.

Ich. Männlich. Baujahr 1982. Suche dich. Weiblich. Baujahr eigentlich egal (your law applies). Wir müssen Babys bauen, sonst stirbt der intelligente Teil der Menschheit aus!

Meine erste Internet-Kontaktanzeige! 2023. Nicht schlecht!

Nur ernsthafte Antworten bitte mit Lichtbild, Brust-, Taille- und Hüftumfang, sowie Geburtsurkundenkopie an: prachtschwanz-sucht-lecker-maedsche@wood.com. Ich freue mich auf dich, HDGDL!

Sieht so bestimmt nicht aus: was meine Grafikkarte aktuell dank Stable Diffusion „denkt“, wie der neue PS5-Handheld aussehen könnte…

Dem Erfolg des Steamdeck (und den vielen mittlerweile erhältlichen Handheld-Klonen) ist es wohl zu verdanken, dass Sony offiziell über einen Nachfolger einer tragbaren PlayStation nachdenkt:

„A new report details the PlayStation Q Lite handheld device, which is still in its QA testing phase. The new handheld device is described as a PlayStation 5 DualSense controller with an 8-inch LCD screen in the middle, but the catch is that it will only work with Sony’s PlayStation Remote Play.“ [via]

1080p und 60FPS bei „Projekt Q“ in allen Ehren, aber wer wird einen Handheld zocken wollen, der keine eigenen Spiele abspielen kann und nur mit Internetanbindung funktioniert? Ich nicht.

So wie sich das anhört wird das lediglich ein fancy neues Controllergadget sein. Irgendwie auch hardcore kopiert von Nintendo bei der Wii U – mittlerweile auch schon antik und aus 2012.

Sei’s drum, Ende 2024 wissen wir alle mehr. Bis dahin wollen die Japaner die Hardware veröffentlicht wissen. Dann brauchen wir uns auch nichts mehr zusammenfantasieren (lassen) wie oben.

So viel beträgt aktuell die untersuchbare durchschnittliche menschliche Aufmerksamkeitsspanne, fand eine Metastudie aus Katalonien heraus.

2000 waren es noch 12 Sekunden.

Wir haben in 15 Jahren, von 2000-2015, fast vier Sekunden Konzentration verloren.

Shit.

Aber auch auf die seelische Gesundheit hat das negative Auswirkungen [via]:

* 20 Prozent der Jugendlichen leiden demnach unter Symptomen von Schlaflosigkeit

* 25 Prozent vergessen wichtige Details über ihre Freunde und Familie

* 40 Prozent gehen nach eigener Darstellung online, um Einsamkeitsgefühle zu überwinden

* 81 Prozent plagt Nomophobie, also die Angst, ihr Mobiltelefon nicht griffbereit zu haben

Alles mehr als unbefriedigend, das.

Was aber tun?

Einfach, vielleicht langweilig, doch sehr effizient:

* Lesen, aber auf Papier

* regelmäßige Bewegung

Im Endeffekt muss man sich als Individuum die Sekunden selbst zurückholen, aktiv dazu beitragen, denn: „…sich ausbreitende(n) Pathologien nutzten Unternehmen vielfach aus, um durch geschickte Marketingstrategien mehr junge Nutzer anzuziehen.“ (sic) Sonst sind es 2030 nur noch vier Sekunden Konzentration. Und die Menschheit ziemlich am Arsch.

Ich weiß natürlich nicht ob es stimmt, aber es existiert das Gerücht online Anya Taylor-Joy, die im neuen „The Super Mario Bros. Movie“ Princess Peach spielen soll und die keinerlei Gamer-Background besaß, soll angefangen haben nachdem sie die Rolle landete online Frauen und Minderheiten zu schikanieren.

Das Internet ist ein schrecklicher Ort.

Wenn du weißt, dass du als Unternehmen gerade gefickt wirst, holst die Gründer zurück:

„ChatGPT hat den Suchmaschinenriesen auf dem falschen Fuß erwischt: Google holt die Gründer zurück, um eigene KI-Projekte voranzubringen.“ [via]

Was wir aktuell gerade bei ChatGPT an Hype erleben ist die Wiederholung des Hypes um Eliza aus den 60ern des vergangenen kaputten Jahrhunderts (wir erinnern uns: der allererste Chatbot) und auch die Phänomene des menschlichen Erstaunens sind genau die selben. Sie entstammen der menschlichen Neugier, Inkompetenz, Fantasie, der Sucht nach der ultimativen Unterhaltung und dem Verlangen des eigenen Untergangs.

Dabei haben wir dringendere akute Probleme derzeit, wie die Stellung der Doomsday Clock auf 90 Sekunden vor Mitternacht; ein desolater Zustand, Premiere überhaupt seit es diese Uhr gibt und eine traurige Einschätzung vieler Wissenschaftlerinnen und Wissenschaftler weltweit für unsere menschliche Zukunft. Ein Eliza 2.0 wird dazu wenig beigetragen haben.

Es sei wie es sei, Page und Brin tun gut daran nicht M$ zu folgen und alles in die ChatGPT-Waagschale zu legen, was sie haben. Das werden sie auch nicht tun, dafür sehe ich beide immer noch als zu visionär, zu ausgebufft, zu kompetent in Sachen IT. Es wird was Gutes haben, dass die beiden darauf antworten werden. Und wieder wird es ein Wettrennen der Zukunftstechnologie nur innerhalb der USA geben, weshalb man Europa erneut wieder nicht leiden können wird. Wir verkacken hier immer noch unsere (IT-)Zukunft, wo sind eigentlich unsere EU-Brins und -Pages, wenn man sie braucht?

Es ist 2023, ein neues Jahr, Zeit also, dass wir alle erstmal ein anständiges Bad nehmen und den ganzen alten Dreck abwaschen!

Das geht natürlich am besten in der Mensch-Waschmaschine:

Nee, ist kein Witz, also das Konzept steht. Kommt natürellemont aus Japan.

Geplant ist ein erster Prototyp nächstes Jahr und die offizielle Präsentation des Geräts 2025 zur Expo Osaka.

WTF. Passender Start in ein weiteres verkorkstes Jahr hier, let’s go!

Der aktuelle wissenschaftliche Status zur Kernfusion ist folgender: sie funktioniert. Allerdings ist die Technologie nicht alltagstauglich. Daran ändert auch der aktuelle Durchbruch in den USA nichts, durch ein Kernfusionsexperiment habe man einen Nettogewinn erzielt. Also man hat mehr Energie erzeugt, als man reingesteckt hat in das Experiment.

Warum? Steht hier.

Über Laser (viele davon) hat man mit 2,05 Millijoule am Ende 3,15 Millijoule herausgeholt. Also rein rechnerisch weit über 50%. Die 1,1 MJ sind allerdings nur 0,3kWh. Mir Menschen brauchen alleine um einen Kessel Wasser zu kochen, damit wir uns einen Tee machen können, 0,2kWh. Diese Tasse hier sollte man lange genießen!

Nee, is‘ cool, aber reicht halt auch nicht für mehr. Wir sind Dekaden von einer wirklichen Alternative der Energiegewinnung durch Kernfusion entfernt. Zudem hat die Menschheit jetzt auch nicht gerade die positivsten Erfahrungen mit Atomkernen in der Vergangenheit gemacht. Mir persönlich wäre das zu heikel, das weiterzuverfolgen.

Es kommt selten vor, dass Elon Musk öffentlich technische Inkompetenz beweist. Sein Twitterkauf war leider mal wieder so ein Fall. Seine Ausfälle hier werden dümmer und kostspieliger. Ich hoffe er leidet nicht an Demenz oder sowas.

Anyways.

Ich hatte 2017 bereits den Twitter-Killer „Mastodon“ vorgestellt. Das ist nun auch schon wieder fünf harte lange Jahre her.

Daher aus aktuellem Anlass, für die ganzen Wechselwilligen, bitte aufmerksam durchlesen, ist nach wie vor aktuell:

https://gizmeo.eu/mastodon-der-twitter-killer/.

Viel Spaß und Erfolg beim Tooten!

:: Introduction

I think of Neuromancer as a pretty complicated novel. Written in 1984 by William Gibson it is one of the earliest pieces of literature of cyberpunk genre, part of its Kanon today, so to speak. Anyone interested in cyberpunk will encounter it sooner or later. And anyone could read something different in it. Part of it, it’s written from the future and not only covers artificial intelligence, hacking, virtual worlds/cyberspace, drugs, ROMs; you could go on and still not grasp the vastness here. After reading, I was not really sure if even Gibson understood what he published here. But we are cool with it, as this is another factor for one’s sympathy for this 271-pager.

Today, there are websites which aggregate the most popular quotes like the one from Goodreads here. I’m pretty sure with some of the text snippets alone, you will have problems not only from semantics perspective but also from the vocabulary alone. This is innovative and futuristic but hinders a reader from truly enjoying it. Nevertheless, the cryptic groundwork was taken often as the basis for some nice artwork pieces, like the 48-page graphic novel released in 1989 by Tom de Haven and Bruce Jensen. Heck, I even think, as I own the graphic novel too and read the novel first, that you might be better off with the graphic novel and leaving the book all alone. Although I won’t recommend it, as you know, we are all cyberpunks ourselves here.

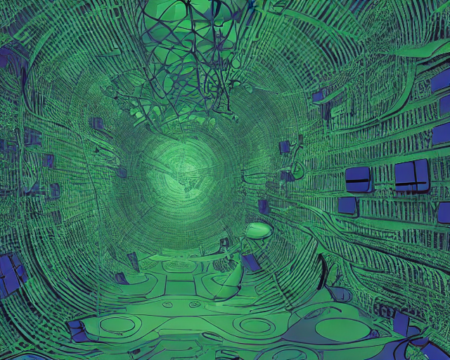

:: My proof of concept

No matter how complicated and exotic the text, I thought this would be a perfect basis for some of my further experiments with machine learning artwork generation. I thought maybe it’s better just to leave my hardware alone: should my GPU make sense of these lines now! We are 2022, with engines like Stable Diffusion and a recent laptop, this sounds like a piece of cake! So I took the most popular quotes from the novel, the ones which made sense in creating something which a reader’s mind could have difficulties with, and let it run through my (laptop) GPU. I picked the best one from three which were created simultanously per quote in approx. three minutes. Without further ado, let’s check the results here! You can click on the pictures to see the original size. Enjoy!

:: Neuromancer vs. my GPU

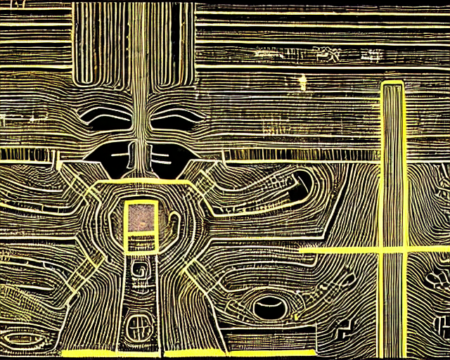

„Cyberspace. A consensual hallucination experienced daily by billions of legitimate operators, in every nation“

„His eyes were eggs of unstable crystal, vibrating with a frequency whose name was rain and the sound of trains, suddenly sprouting a humming forest of hair-fine glass spines“

„We have sealed ourselves away behind our money, growing inward, generating a seamless universe of self“

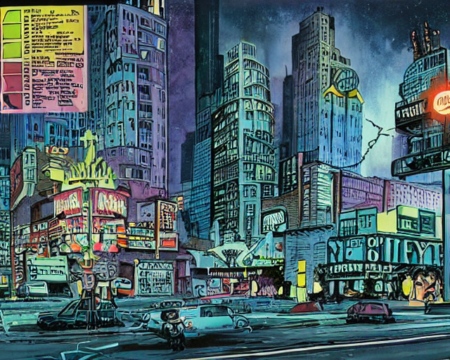

„Night City was like a deranged experiment in social Darwinism, designed by a bored researcher who kept one thumb permanently on the fast-forward button“

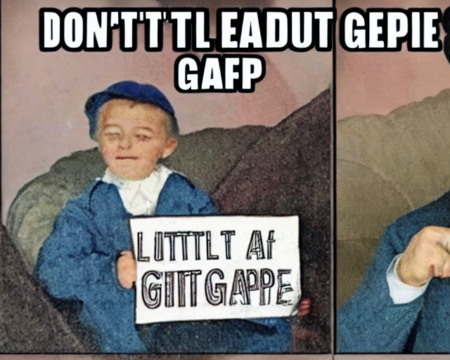

„Don’t let the little fuckers generation gap you“

„Lost, so small amid that dark, hands grown cold, body image fading down corridors of television sky“

„We monitor many frequencies. We listen always. Came a voice, out of the babel of tongues, speaking to us. It played us a mighty dub“

„And in the bloodlit dark behind his eyes, silver phosphenes boiled in from the edge of space, hypnagogic images jerking past like a film compiled of random frames“

„Case shuffled into the nearest door and watched the other passengers as he rode. A pair of predatory-looking Christian Scientists were edging toward a trio of young office techs who wore idealized holographic vaginas on their wrists, wet pink glittering under the harsh lighting“

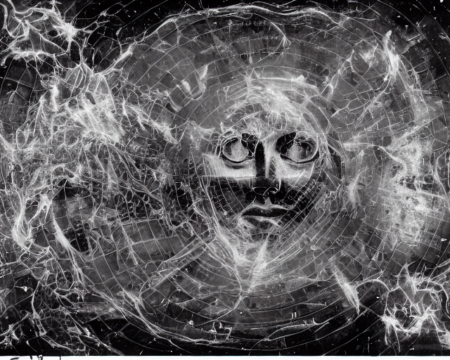

„His vision crawled with ghost hieroglyphs, translucent lines of symbols arranging themselves against the neutral backdrop of the bunker wall. He looked at the backs of his hands, saw faint neon molecules crawling beneath the skin, ordered by the unknowable code“

„The Matrix has its roots in primitive arcade games,‘ said the voice-over, ‚in early graphics programs and military experimentation with cranial jacks.'“

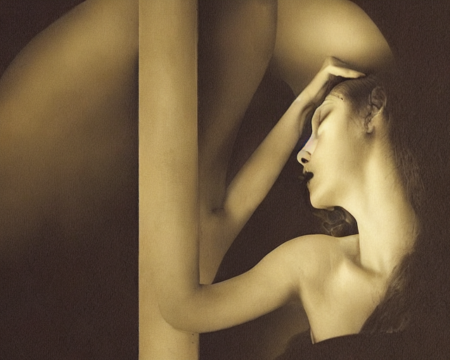

„INTO HER DARKNESS, a churning synaesthesia, where her pain was the taste of old iron, scent of melon, wings of a moth brushing her cheek. She was unconscious, and he was barred from her dreams“

„Rain woke him, a slow drizzle, his feet tangled in coils of discarded fiberoptics. The arcade’s sea of sound washed over him, receded, returned. Rolling over, he sat up and held his head“

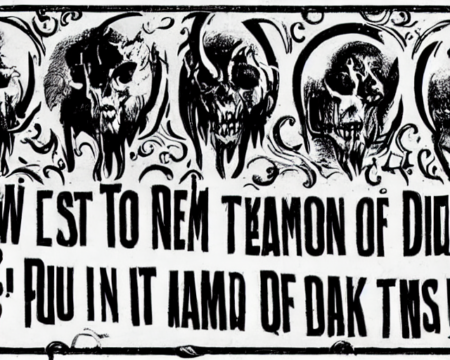

„To call up a demon you must learn its name. Men dreamed that, once, but now it is real in another way. You know that, Case. Your business is to learn the names of programs, the long formal names, names the owners seek to conceal“

„It was a vast thing, beyond knowing, a sea of information coded in spiral and pheromone, infinite intricacy that only the body, in its strong blind way, could ever read“

„Wintermute was a simple cube of white light, that very simplicity suggesting extreme complexity“

:: Outro

I was happy that my POC was a success, of course. And I was also pretty convinced by what my graphics processor could make of those rather difficult novel lines from the 80s in our current times. However, I also see some difficulties when StableDiffusion tries to render certain things: like human appearance, as oftentimes it outputs strange limbs and also faces, especially around eyes. Same goes for text, as seen in some of those (rather grotesque) examples. Both problems could be shared with other tools like DALL-E 2 or Imagen though, I never tried those before. It’s a very young brand new technology of course, this is common. From artwork perspective, I also am not sure if this is really a problem. Furthermore, I think this is a perfect example for what we do from read-write culture. Which can’t be emphasised enough nowadays, because what we originally intended back then, generate reciprocal relationship between the producer and the consumer, wasn’t taken up by people as we intended. Like ever. Stupid, unreasonable consumerism won, unfortunately. As such, this might be not the last project of its kind I did by myself, as I got enough books in my private library which could need clarification visually. But in the history of the web, probably very much so. Let me know what you think in the comments, hope you had a great time exploring this!

Dieser freundliche Herr hier ist Masayasu Ito:

60 Jahre alt. Seit 1986 bei Sony. Leiter der Entwicklung der PlayStation 4. Leiter der Entwicklung der PlayStation 5. Vizepräsident von Sony Interactive Entertainment. Ein wahrer Über-King of Gadgets aus Japan!

Wir verlieren ihn. Ab dem 1. Oktober ist er weg, leider.

Denn Japan ist ein paradiesisches Land, wo die fleißigen Arbeiter ab 60 in Rente gehen dürfen. Und leider geht er nun in Rente. Ich werde ihn vermissen! Und Millionen PlayStation-Zocker wohl auch.

Spätestens bei der PlayStation 6 werden wir alle wissen, wie wertvoll er war. Und sollte entertainmenttechnisch die nächsten Jahre alles den Bach runter gehen von Sony, wir wissen, woran es lag. Ich wünsche es nicht, aber der Realität war schon immer scheißegal, was wir uns wünschen.

Sayonara, Ito-San! You will be missed. Take care and try to enjoy your pension.