Archiv für die Kategorie „Zukunft“

Absurde Zeiten erfordern absurde Maßnahmen!

Treu diesem Motto hat das Kult-Satiremagazin „The Onion“ jüngst die Domain des nach weit rechts abgedrifteten US-amerikanischen Bloggers Alex Jones ersteigert: infowars.com.

Ich musste den Artikel zwei Mal lesen und mehrmals das Datum gegenchecken, weil ich das zu Beginn tatsächlich für einen Aprilscherz hielt. Oder eben einen genialen neuen Gag von „The Onion“ selbst. Ist aber alles wahr und tatsächlich passiert. ROFL!

Doch nein, das ergibt absolut Sinn!

Freuen können wir uns nun auf Protein-Shake-Werbung mit Trump-Konterfeis; durch den Kakao gezogenen Verschwörungstheorien zu den mittlerweile zu Internetberühmtheit gelangten „lizard people“; mit KI-Rap-Stimmen untermalte Tanzvideos katholischer Kardinäle.

Irgendwie kann die Zukunft doch auch ganz nett sein! Warum nicht häufiger so?

Der ganze KI-Kram da draußen ist alles noch BETA und von künstlicher Intelligenz rein technisch keine Spur weit und breit. Und doch gibt es bereits fünf Typen von Büroangestellten zum Thema „KI bei der Arbeit“:

„Der Maximalist“: benutzt Tools wie ChatGPT und Google Gemini regelmäßig bereits bei der Arbeit

„Der Untergrund“: benutzt die Tools, aber geheim

„Der Rebel“: verabscheut die Tools

„Der Superfan“: freut sich riesig über die Tools, aber hat bis heute keins davon je benutzt

„Der Beobachter“: wartet erst einmal ab und wird man dann sehen

Man kann die Studie als durchaus repräsentativ beurteilen, denn immerhin wurden 5000 Menschen dafür befragt. Kleiner Schmerzpunkt: war halt von Salesforce. Könnte also based sein. Oder ist es ziemlich sicher. Wird jedoch nicht die letzte ihrer Art sein und man darf gespannt sein, wie sich das entwickelt.

Der Link oben liefert auch einen Test, zum selber herausfinden. Der hat bei mir allerdings nicht funktioniert – vielleicht ja bei euch.

Above: a typical environmental element no Unreal engine powered video game must miss

„Final Fantasy VII Rebirth“ will be my last Unreal engine powered video game ever bought and here’s why.

I was born in the 80s and concerning video games, I was part of a lucky generation which has seen it all: from the weak pixelated C64/Atari consoles through the Nintendo x Sega console wars with GameBoys, Gamegears, NES/SNES, Mega Drives, Dreamcast and whatnot; the revolution introduced by the PS1–PS3 systems; followed by the console war between Microsoft and Sony until the current age of PS4/PS5 and Xbox S/X and their most similar hardware architecture to PCs ever; Nintendo suing anyone who emulates; VR and the according headsets; as well as Internet based virtual worlds like Second Life, PlayStation Home and Decentraland.

As we 80s kids are all part of the worldwide workforce now and have no time to slack around anymore, why is it that subjectively every popular game on the market uses the exact same engine – whereas we should have the most competent programmers and video game creators out there who certainly have seen the above all too, have the same valuable experience and could do so so much better?

I don’t get it. Where did it all go wrong?

First let’s start with a little bit of history where the Unreal engine came from: it was a shooter engine from somewhere between 1998 and 2014. If you need a deeper knowledge, here’s the list and all the true „Unreal“ games that where powered by it (with Unreal engine 1-4). Read it up, check the scores for each game, maybe you remember some and let me know what you think of it. Don’t get me wrong, even we as a local playgroup had a lot of fun together when playing „Unreal Tournament“ at our LAN parties in the 2000s. But there is much more to video games than shooters. What works best for shooters doesn’t need to work best for any other genre. And exactly here lies the rabbit in the pepper (German saying).

That issue went berserk to this date, 2024. It may be a good engine, maybe even excellent. But please, it’s a shooter engine. This might be the case for shooters. It never was meant to be a „general video game engine“ and to this date it certainly doesn’t live up to that. Here are some of the main problems. Depending on the hardware generation, the following applies most of the time:

* the atmosphere feels similar

* the graphics have a similar technology feel – no progress noticeable, most of the time not even visible

* the glitches are the same, e.g. low pixels until you literally run into environmental items

* heck, even the bugs are the same

* camera and camera problems: almost always the same

* gameplay: almost always the same

* rubbish and items with no purpose at all: always the same

* rendering issues: always the same

Conclusion: if you want to develop the next (hopefully revolutionary, harhar) shooter – take the Unreal engine! If you want to pitch your video game idea and need cheap developers for your MVP, choose the Unreal engine! Then go on with your own engine into your own future from there! For any other genre and if you really love video games and understand where it all came from (see above), choose something else. Or, if you feel capable and/or have the resources, develop your own engine plus do some research and support the video companies out there who still do:

CD Projekt has its own Red Engine.

Capcom has its own RE engine.

Konami had its own Fox Engine.

Sucker Punch has its own engine with an unknown name.

From Software uses a modified version of the PhyreEngine.

Guerilla Studios has its own Decima engine.

There are certainly more out there, also Indie studios, who do the same but we’ll never know their engines.

Plus, there are many other engine frameworks out there which might be capable for your project and 100% free to use like Spring, PlayCanvas, GDevelop, and so on.

We won’t bring the best out of any hardware and notice what a technology is really capable if all studios and development teams use the exact same engine. We will always have almost the exact same game with the exact same issues.

We had this problem with generation 7 and the Havok engine already, why does this come back like a boomerang? We should have worked out this issue in the industry years ago, instead we see it again now with Unreal? Whereas at least for my personal generation we should see the most sophisticated, technologically most advanced and 99% bug-free video games of all time, as all of my cohort needs to work now or else will not be allowed to even breathe in their own apartments as we all need that damn money in this incredible expensive world of today. If they have the privilege to work in the video game industry at all.

As such, „Final Fantasy VII Rebirth“ will be my last Unreal engine powered game. I think this is really what you can bring out of the engine for 99%. And heck has it issues. In the past we always knew with every new „Final Fantasy“ the developers at Squaresoft/Square Enix squeezed the last bit of optimisation out of their most recent software and we loved them exactly for that. Whereas now they are not even capable to render hair correct (e.g. Yuffie). Or let you see the ocean from above as an ocean (it looks like a low pixelated swimming pool now, with a pixelated ground of 5m depth). Or use the graphics mode without tearing. OK, it’s a remake, let’s forget about it. IMHO _this_ game especially would have deserved its own engine. So have others. But we can’t all be kids of the 80s. And of course we can’t all love video games.

Mathematik ist wunderbar und dank dem Internet beschert sie uns aktuell fantastische Texte wie diesen:

„Man kann es astronomisch nennen. Mir fehlen die Worte meterologisch das Auge des Sturms und die Intensität hier zu beschreiben. 897 Millibar Druck mit Sturmwinden von 290km/h und Sturmböen von mehr als 321km/h. Bereits jetzt ist das der bisher viertstärkste Hurrikan, der mit solch einem Druck auf dieser Seite des Planeten gemessen wurde. Das Auge des Sturms ist WINZIG mit 6,11 Kilometern. Dieser Hurrikan kratzt an der Grenze des mathematisch Machbaren, was die Atmosphäre des Planeten Erde über diesem Ozeanwasser produzieren kann.“

Fett. Dank dem Klimawandel stehen meine Chancen richtig gut noch das absolute mathematische Limit eines Hurrikans auf dem Planeten Erde live zu erleben!

Da ich letzte Woche das erste Mal Corona hatte lese ich vermehrt mal wieder quer, was es hier so Neues gibt. Vielleicht hilft ja das hier in der Zukunft: https://newatlas.com/disease/pcans-nasal-spray-traps-viruses.

Forscherinnen und Forscher von einem Harvard-nahestehenden Krankenhaus haben ein Spray entwickelt, das in der Nase eine Art Gel formt, medikamentenfrei ist und sämtliche Viren und Bakterien trapt, die man einatmet. Sie haben das Ganze Pathogen Capture and Neutralizing Spray (PCANS) getauft.

„It blocked and neutralized almost 100% of all viruses and bacteria we tested, including influenza, SARS-CoV-2, RSV, adenovirus, K Pneumonia and more,“ says Dr. John Joseph, primary author of the study.

Das funktioniert bereits bei Mäusen zu 99,99% mit H1N1, auch wenn das Virus hier auf die 25-fache tödliche Dosis hochgeschraubt wurde. Bei Menschen stehen die Tests noch aus, aber mit dem 3D-Druck einer Nase wurden offenbar bereits doppelt so viele Mikroben abgefangen. Vielleicht ist das eine gute Idee. Ob’s funktioniert?

„Daten, Daten, schöne fremde Daten!“ – Ed, Cowboy Bebop

Ich habe ChatGPT jüngst gefragt, was aufgrund seiner Datenlage das frühstmögliche Jahr ist, in dem alle natürlichen Ressourcen aufgebraucht sein werden. Der Bot meinte dazu, wohl um 2050 herum.

Öl: beim aktuellen weltweiten Konsum 2050. Quelle: IEA World Energy Outlook und BP Statistical Review of World Energy

Gas: ca. 2070. Quelle: https://www.eia.gov/

Kohle: Ende 21. Jahrhundert. Quelle: https://www.worldcoal.org/

Kupfer: 2070. https://www.usgs.gov/

Phosphor: wenn sich die Praktiken in der Landwirtschaft nicht ändern ca. 2050. Quelle: https://phosphorusfutures.net/

Seltene Erden: 2040. https://www.energy.gov/

Gold: 2044-2054. Quelle: https://usgs.gov/

Silber: 2040-2050. Quelle: https://silverinstitute.org/

Lithium: 2044-2054. Quelle: https://iea.org/

Helium: ca. 2044. Quelle: https://nationalacademies.org/

Uran: Ende 21. Jahrhundert. Quelle: https://world-nuclear.org/

Müssen wir uns jetzt Sorgen machen, dass es nach 2040 keine iPhones mehr gibt? Ach was, NASA regelt:

Der wichtigste Journalist im Westen und Gründer der Enthüllungsplattform Wikileaks ist endlich frei.

Es wird ein seltsamer Deal, aber wenn alle Seiten mit erhobenem Haupt aus der Sache hier rauskommen, ist auch schon was gewonnen:

- Assange reist zunächst auf die Nördlichen Marianen. Das ist ein Niemandsland im Pazifischen Ozean zwischen Japan im Norden und Papua Neu-Guinea im Süden

- da sich dort ein US-Bundesbezirksgericht befindet, kann er verurteilt werden für „Verschwörung zur Preisgabe von Geheimnissen über die militärische Verteidigung der Vereinigten Staaten von Amerika“. So wahrt der aktuelle US-Präsident und die USA ihr Gesicht

- der Prozess findet am 26.06.24 um 9 Uhr Ortszeit statt

- das Strafmaß wird noch am selben Tag von Richterin Ramona Manglona verkündet

- anschließend darf Julian Assange endlich, nachdem er von Großbritannien und Ecuador 2018 auch noch krass verraten wurde, in sein Heimatland Australien ausreisen

[via]

Wenn Geschichtsschreiber in hundert oder so Jahren über uns im Westen und die Presse- und Meinungsfreiheit urteilen werden, wird dieser Fall hier mit sehr hoher Wahrscheinlichkeit als krasses Negativbeispiel herhalten müssen. Für mich war das analog wie das Schweigen der „Silent Generation“ zu den Naziverbrechen zur Zeit des Zweiten Weltkriegs. Ein absolutes Nogo, ein Paradebeispiel westlicher Heuchelei und innerer Verschwörung. Ein perfekter (komplett asozialer) Politkrimi, nur leider Zeitgeist und harte Realität. Unsere „Freiheit“ ist scheinbar auch nur eine auslegbare Illusion, wie dieser Fall hier seit mittlerweile 14 langen Jahren zeigte. Beide Mittelfinger hier von mir in die Fresse der USA, Großbritannien und leider am Ende auch Ecuador.

Och nö, ne: gerade, als wir anfingen KI in Gadgets irgendwie „cool“ und „nützlich“ zu finden, und unsere Zukunftshoffnungen darauf setzten, kommt wohl heraus, dass es nichts weiter als ein Scam ist.

Echt traurig!

Naja egal, Zeitgeist, machen wir einen weiteren OF auf, um an Geld zu kommen!11

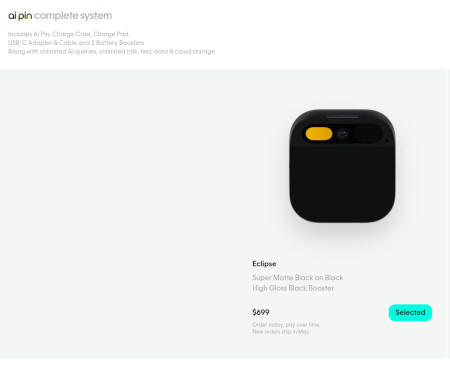

Nee, ernsthaft, zum Beispiel der Humane AI Pin:

„…reagiert sehr träge“

„…antwortet in etlichen Fällen auch mit falschen Informationen“

„…eingebaute Kamera liefert in nicht optimalen Lichtverhältnissen keine guten Videos“

„…Gerät heizt sich oft auf“

„…besonders negative Kritiken bekommt der Projektor“

Boing! Ende vom Lied, die wollen ihr tolles Startup bereits nach wenigen Wochen verkaufen. Und wir warten weiter auf die „Smartphoneablösung“. Au weia… [via] [via]

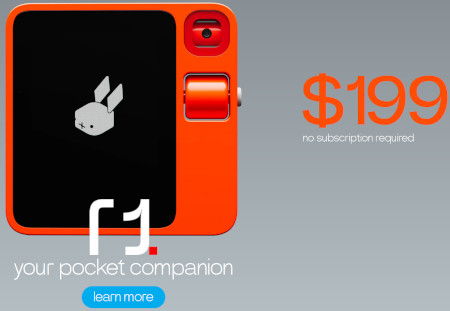

Weiteres Beispiel, der Rabbit R1, „rabbit r1 it’s a SCAM“:

„…a mishmash of poorly executed features and a good dose of scams“

„…from a company previously involved with NFTs and „pay-to-win“ games (which use NFTs)“

„…instructions are hardcoded into the device, meaning that most actions are predefined“

„…what Rabbit R1 does is similar to automation we perform when using Selenium IDE to input passwords“

Tjop. [via]

Den dritten Tipp, den ich damals vorgestellt habe, habe ich mittlerweile vergessen; habe aber auch keine Lust mehr das zu recherchieren, weil die Ergebnisse der zwei vielversprechendsten „KI-Gadgets“ reichten mir schon völlig. Sry.

Irgendwie sind die Zeiten gerade echt beschissen. Man könnte das Gefühl haben, nichts funktioniert (mehr). Ich geh wieder zurück ins Kinderzimmer, zocke GameBoy aus 1990, der läuft sogar heute noch. Bye!

Ja, alles geht den Bach runter…

But behold: nicht für Gadgets! Harhar!

Wer zum Beispiel ein aktuelles Smartphone mit KI-Funktionen sucht, der ist mit dem Pixel 8 oder dem Samsung S24 bestens bedient. Zwar weiß noch keiner, was das alles soll und überhaupt. Doch wer Angst vor der Zukunft hat, in KI mal reinschnuppern will und auf sein Telefon eben nicht verzichten möchte – hier kann man bereits heute ein bisschen Teil an der Zukunft haben. Mit all seinen Einschränkungen und Macken. Und auch nur durch die Brille von Google und Samsung versteht sich.

Ich. Will. Mehr!

Mich interessiert immer „der neue heiße Scheiß“ mehr als das ganze andere Zeug. Also lasst uns gleich einsteigen mit: dem Humane AI Pin.

Das ist ein KI-Roboter zum Anstecken an die Kleidung aus San Francisco, USA. Ab 699$/644€ bekommt man das Gerät inklusive Ladebox, USB-C-Adapter und 2 Ersatzbatterien. Persönlich muss man selbst die eigenen Datenwälle öffnen für die „KI-Cloud“, die noch einmal mit 24$/22€ pro Monat zu Buche schlägt. Ich stelle mir das wie „ChatGPT für die Jacke“ vor. Das Ding sammelt alles, um euer Lieschen-Müller-Leben zu verstehen, denn es will ja euer nützliches Roboterhelferlein sein. Man kann seine Zweifel haben, ob da alles so gut läuft (Alexa, ehemmm…). Die Idee ist aber ziemlich genial, vergisst man einen Moment die Datenschutzbedenken und den monatlichen finanziellen Aufwand.

Weiter geht’s mit dem 01 light:

Ganz ehrlich: I have no f***ing clue what this sh*t is. Aber immerhin gab es eine „erste Vorschau“ „irgendwo im Internet“. Und: wenn jemand reinschreit, das sei als das „Linux der KI-Hardware“ zu verstehen werde ich leicht hellhörig. Mein Unterbewusstsein sagt dann „ja, mach doch!“ Mein Bewusstsein meint dazu „ja, träum weiter“. Lasst es sie versuchen, was auch immer dabei herauskommt. Für 109$/100€ hat man eigentlich nicht viel zu verlieren. Zumal wir ITler all die Problematiken alltäglich kennen, immer die selben Tasks ausführen zu müssen. Vielleicht kann das Ding hier ja helfen, kommt aus Seattle(?), USA(?). Wobei der Code liegt ja bei GitHub herum. Man kann sich eines selbst bauen, wenn man will.

Zum Abschluss kommen wir zum Star der CES 2024: dem Rabbit R1.

Kein Artikel zu einer neuen „Ära der Gadgets“ darf aktuell ohne dieses kleine Pokédex enden. Die ersten Geräte sollten eigentlich schon bei den Endkunden sein (Ende März). Es funktioniert ähnlich wie der Pin oben. Allerdings ohne monatliches Abomodell und kostet 199$/183€. Der Hardwareentwickler Teenage Engineering hofft damit „die Ära der Smartphones beenden“ zu können. Was ein hehres Ziel ist. Und gleichzeitig gnadenlos überambitioniert. Es ist das Gadget mit dem größtem Überhype. Wobei, der Star einer gesamten Elektronikmesse zu sein, noch dazu der CES, das wirst du nicht, wenn du dauernd nur Blödsinn brabbelst. Vielleicht ist ja was dran, die ersten Reviews dazu sollten ja in den einschlägigen Techmagazinen in den nächsten Wochen nachzulesen sein.

Was sagt uns das alles? KI-Gadgets sind „the next big thing“. Wobei, das hieß es bei Krypto auch und dem Metaverse. Und VR seit 30 Jahren. Solange die aktuell erhältlichen KI-Tools nur Schachfiguren in schwarzer Farbe produzieren habe ich eigentlich kaum Hoffnung, dass sich das bewahrheitet. Schlechtreden will ich das alles aber auch nicht, denn: wir werden nicht oft selbst Zeuge solcher Wellen sich komplett verändernder Technologielandschaften. Cool ist es allemal und höchst interessant. Weshalb solche Medien wie hier, gizmeo, sich freuen können wieder eine Daseinsberechtigung zurück zu haben. Ich bin gespannt.

One more thing: was macht eigentlich Apple? Die haben gerade ihre Apple-Auto-Träume eingestampft. Das alte Team soll sich 100% auf KI-Themen konzentrieren. Was dabei herauskommt, niemand weiß es aktuell. Die Taktik hier ist mindestens defensiv – das muss bei dem Quatsch, der aktuell bei den Endkunden ankommt aber nicht schlecht sein. Genügend neue Spieler am Markt gibt es allemal, ich hoffe der Artikel hier erwähnte sie alle. :p

Wer viel mit der (Linux-)Shell arbeitet, der kennt das Problem: Befehle aus der Vergangenheit zu finden ist ein pain in the ass.

Doch fret no more, denn es gibt jetzt Atuin:

Atuin wird vermarketet als die „magische Shell-Historie“ und es macht genau das: es speichert und stellt auf Abruf mit Hotkeys die eigenen Shellbefehle komfortabel in der eigenen Konsole dar. Auf Wunsch auch in der Cloud, um z.B. auf dem Heimrechner und Arbeitsplatz die selbe Historie nutzen zu können.

Im animierten GIF oben sieht man, wie das Programm funktioniert. Ein Muss für alle Konsolen-Rocker (und die, die es noch werden wollen natürlich)!

Das Projekt startete als Hobby und ist mittlerweile ein Vollzeit-Startup. Die eigentliche Entwicklerin, Ellie Huxtable, hat ihren 9to5-Job an den Nagel gehängt und macht nur noch hier weiter. Hier erklärt sie in einem sehr interessanten und informativen Post, wie und warum eigentlich.

Wer sie direkt supporten will, hier noch ein paar hilfreiche Weblinks:

Website: https://atuin.sh

Forum: https://forum.atuin.sh

Email: ellie@atuin.sh

Discord: https://discord.gg/jR3tfchVvW

GitHub: https://github.com/atuinsh/atuin

Mastodon: https://hachyderm.io/@atuin

Twitter/X: https://twitter.com/atuinsh

…Supergadget!

Heute: die Aufräummaus!

[via]

Diese nur 7x2x2cm kleine Maus räumt im Handumdrehen nachts Ihren Schreibtisch auf! Die Maus ist sehr pflegeleicht: sie kommt nur nachts raus. Tagsüber verkriecht sie sich zurück in ihr Mauseloch (Plug’n’Play!). Für ihre Akkulaufzeit von ca. 2 Monaten am Stück genügt es, ab und an ein Stückchen Käse vor ihr Mauseloch zu legen. Auch ihren eigenen Kot räumt die Maus auf (eingebauter Hepafilter, speziell für Allergiker geeignet!). Eingebaute Hinderniserkennung. Hohe Lichtempfindlichkeit, kein Laser oder Infrarot nötig. Eingebaute Wuselfunktion. Im Betrieb zeitweise Piepsen hörbar (Aktionsmodus!). Ein Highlight und Hingucker für jedes Wohn- oder Bürozimmer! Veröffentlichungsdatum: wird noch bekanntgegeben, Gerüchte munkeln Q2/Q3 2024. Preis: unbezahlbar. Fazit: Kaufbefehl!

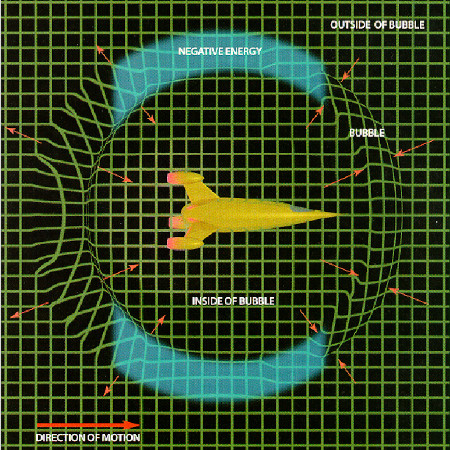

Zum Ende des Jahres noch eine traurige Meldung aus dem Bereich Technologie: für uns wird es leider nicht möglich sein, den Warp-Antrieb zu erfinden.

Oben: Warpantrieb nach Alcubierre

Wir erinnern uns: DER Weltraumantrieb der Wahl in der Space Opera „Star Trek“ – geht aber noch weiter zurück auf den Roman „Islands of Space“ von John W. Campbell aus dem Jahr 1957.

Nur warum?

Ist bisschen doof jetzt: für Antimaterie gilt Gravitation ebenso, fanden die Forscher vom CERN heraus.

Während die Meldung vom CERN dieses Jahr durchaus in den Medien war, war es der Zusammenhang mit der Warp-Technologie eher weniger. Wir bräuchten Antimaterie für den Warp, die „nach oben fällt“, statt nach unten. Tja, das Leben ist nicht fair, Schwerkraft kann ein ziemliches A****loch sein, wie hier.

Welche Optionen für interstellare Raumfahrt mit „Überlichtgeschwindigkeit“ bleiben uns dann noch? Ich weiß es nicht. Aber Warp wird es nicht.

The BestRef database contains results of assessment of 3,751,566 websites in each of 308 language versions of Wikipedia. Based on analysis of 61.81 million Wikipedia articles it was possible to extract information about 336.44 million references in October 2023. This allowed to identify the best information sources of Wikipedia using different assessment models:

Ahhh, what a bliss!

Knowledge is king, man!

Sony baut keine klassischen PlayStations mehr.

„Diablo 4“ hat jetzt seine eigene Steam-Page.

Gabe Newell hat mittlerweile die gesamte Videospielindustrie gebumsvögelt. Und dabei keinen Finger krumm gemacht. Respekt.