Archiv für die Kategorie „Zukunft“

Der offene Charakter von Android macht solche Konzepte wie Blackphone überhaupt erst möglich.

Blackphone ist ein Krypto-Smartphone, ein Stück aufwendige Technik für verschlüsselte Kommunikation, wie sie sonst nur Staatslenkern für sehr viel Geld zur Verfügung steht. Hier eben für Lieschen Müller und Erik Muster gleichermaßen.

Ich habe mich umgehend für deren Newsletter angemeldet, als das öffentlich wurde. Nur leider bekam ich bisher noch keinerlei weiterführende Informationen.

Zum Einstieg muss uns die Website reichen, die gibt es nämlich vom Start weg auch in deutscher Sprache:

Mal davon abgesehen, dass wir mittlerweile und ganz nebenbei in ein Zeitalter eingetreten sind, wo sichere Hardware sexy sein darf, auch das personelle Backup hier ist vielversprechend:

Phil Zimmerman ist Entwickler von PGP und in der „Internet Hall of Fame“. Jon Callas war Mitgründer der PGP-Foundation. Was die beiden alleine wegen PGP schon durchmachen mussten, man möchte nicht mit ihnen tauschen. Dann war David Purón Vorsitzender der Open Mobile Alliance und kennt sich mit massenhaft Mobilfunkstandards aus. Das spanische Startup Geeksphone (u.a. Firefox OS) mischt ebenfalls mit. Und Mike Kershaw hat mal das nette Wifi-Tool Kismet entwickelt.

Die modifizierte Android-OS-Version wird nach derzeitigem Stand PrivatOS heißen. Und die soll dann das Folgende möglich machen:

* Verschlüsselung aller Anrufe

* Verschlüsselung aller Emails

* Verschlüsselung aller Texte

* Verschlüsselung für Internet-Browsing

* Internetzugang über VPN

* Komplette Kontrolle über den eigenen „digitalen Fußabdruck“

Und wahrscheinlich noch viel mehr, was bisher einfach noch nicht verfügbar ist.

Weder Release-Datum, noch Einführungspreis stehen bisher fest.

Die Vorbestellungsphase für das Gerät beginnt am 24. Februar. Am selben Tag wird das Smartphone auch das erste Mal auf der Mobilfunkmesse MWC in Barcelona präsentiert. Vormerken! Alleine um das hier rückgängig machen zu können:

„Technology was supposed to make our lives better. Instead we have lost our privacy — we have become enslaved.“

Mit Androiden ist es recht einfach ins Darknet abzutauchen, sofern man dies wünscht.

Alles was man dazu braucht:

1) Orbot. Die APK gibt es offiziell im Play Store, hier der Link

2) Firefox. Ich empfehle diesen Android-Browser vor diesem komischen verkrüppelten Orweb. Auch diese APK gibt es im Play Store, wenn ihr den nicht eh schon benutzt

3) Um beide Apps nun zu verheiraten, braucht ihr das Firefox-Plugin ProxyMob. Und das findet ihr direkt(!) hier: Add-On installieren

4) Das war’s! 😀

Die Funktionsweise ist nun wie folgt:

Orbot aufrufen -> auf dem Button bleiben, bis er grün wird -> auf die Weltkugel in Orbot klicken -> Firefox als App auswählen -> es _muss_ eine Erfolgsmeldung kommen, dass Firefox nun für Tor konfiguriert ist

Ihr könnt das dann ganz einfach überprüfen (falls ihr ungläubig seid, etc.), wenn ihr nun das Hidden Wiki aufruft: http://thehiddenwiki.org/, dort findet sich der Link gleich ganz oben unter der Bezeichnung „Link to the original Hidden Wiki:“. Der Link ist unter normalen Umständen nicht zu erreichen.

Dass Orbot läuft lässt sich an einem Icon mit Ausrufezeichen in der Statusleiste eures Androiden sehen. Das kann übrigens ruhig die ganze Zeit laufen, andere Browser wurden nicht mit TOR verknüpft und können für das „normale“ Web verwendet werden.

Wenn ihr Firefox nun wieder ohne Orbot nutzen wollt, reicht es das Proxy-Plugin zu deaktivieren.

SPEZIALTECHNIKEN (optional)

Ihr könnt weitere Plugins für Firefox installieren, um eure Privatsphäre noch mehr zu erhöhen:

I) Phony, direkt installieren. Hier kann man andere Hardware als Client auswählen, etwa Mac, Windows, Firefox OS, etc.

II) Self-destructing Cookies, direkt installieren. Cookies, die nicht mehr gebraucht werden, etwa für zuvor offene Tabs, werden umgehend gelöscht. Es erscheint jedes Mal allerdings eine Meldung, was genau zerstört wurde. Ist trotzdem echt gut.

III) alternative Standard-Suchmaschine: Ob DuckDuckGo oder Startpage; ihr könnt jede beliebige Suchmaschine zum Standard in Firefox für Android machen. Dazu bleibt ihr einfach lange auf der Sucheingabemaske und es erscheint das entsprechende Popup

IV) naja, den Tab für privates Browsing (mit der venezianischen Maske) solltet ihr inzwischen vom PC-Feuerfuchs kennen

V) solltet ihr keinen Wert auf eine interne History in Firefox legen, es gibt noch ein Plugin namens Clean Quit, direkt installieren

VI) eventuell erstellt noch ein Master-Passwort, ebenfalls bekannt aus PC-Welten

[via]

Habe ich etwas vergessen!? Nee, ich denke nicht.

Wenn ihr selber zu dem OpenSource-Projekt ProxyMob beitragen möchtet, etwa weil ihr ein Coder mit zu viel Freizeit seid, besucht doch https://github.com/guardianproject/ProxyMob!

Have fun!

P.S.: Anständig bleiben! ^^ Im Darknet nicht immer ganz einfach. Doch leider wird dieser Teil des Webs immer wichtiger. Was ein Armutszeugnis für uns alle ist.

Einen habe ich noch, dann bin ich mal draußen und genieße meinen Winter.

Nokia, die gekauft wurden von IhrWisstSchonWer(R), arbeitet unter dem Schreibtisch weiterhin an einem Android-Smartphone, Codename Normandy.

Das Betriebssystem wird „schwer modifiziert“ sein, auch existieren noch überhaupt keine Screenshots davon. Aber, scheinbar, eben bereits Bilder eines Geräts, wahrscheinlich ein Prototyp und entsprechend zu betrachten: „A real Asha. Or Lumia? The Nokia Normandy“.

Die Quelle, die das behauptet sind die üblichen Verdächtigen hier, die ebenfalls meinen zu wissen, dass das Abenteuer nicht auf Highend-Geräte ausgerichtet ist. Vielmehr gibt es bei den Finnen wohl eine eigene Abteilung, die sich ausschließlich mit Lowend-Smartphones befasst und eben die führen dieses Projekt an.

Aufgrund der erst kürzlich durchgeführten Aquirierung durch IhrWisstSchonWer(TM), steht dieses Unterfangen jedoch mehr als in den Sternen. Schließlich hat man dort bekanntlich kein Interesse harte Konkurrenzprodukte eines Unternehmens zu unterstützen, die mit kleinen grünen Robotern zu tun haben.

Es gibt aber einen entscheidenden Punkt, den man beachten sollte, bevor man dieses Projekt als bloßes Hirngespinst auf die Wartebank schiebt: Und zwar verdient der Käufer von Nokia nämlich ein stattliches Sümmchen an jedem verkauften grünen Roboter-Produkt. Das liegt an bestimmten Patenten und einer Art Erpressung für Smartphone-Hersteller: Entweder ihr schiebt uns das Geld für die Patente rüber und dürft weiter Roboter-Handys verkaufen. Oder aber ihr zahlt nicht und werdet dann durch unsere Anwälte begraben. „R.I.P, war schön, mit euch Geschäfte zu machen!“, so nach dem Motto.

Es geht sogar das Gerücht um, IhrWisstSchonWer(C) verdient mittlerweile an diesen Patenten mehr, als an Smartphones aus dem eigenen Hause. Was aber auch nicht sonderlich schwer sein dürfte. Die Frage ist, ob sie sich eben aufstrebende Märkte wie Afrika entgehen lassen wollen. Holla for the Dolla, aber eben wahrscheinlich nicht mit Hilfe von Roboterchen.

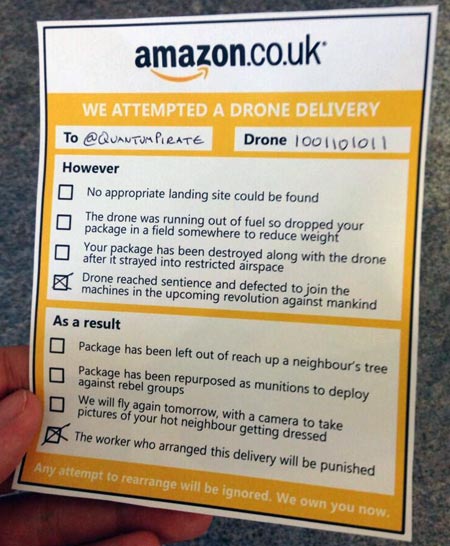

Es liegt in der Natur des Menschen, schleichenden Misständen zunächst mit Humor zu begegnen. Ebenfalls seiner Natur entspricht, dass ihn diese anfängliche Leichtsinnigkeit, sei es aufgrund technischen Unverständnisses, Abarbeiten strikter Befehlsketten ihm aufgezwungener Interessenvertreter, ob eigener Faulheit, kaum verfügbarer zeitlicher Ressourcen, einfach aus Dummheit, schneller in ärgste Bedrängnis bringen kann, als ursprünglich beabsichtigt war. Ein Beispiel:

(Quelle)

Beim Thema Drohnen, einem der wichtigsten der momentanen Dekade, und wahrscheinlich auch weiterer, die kommen, findet derzeit ein Prozess statt, der von zahlreichen Medien und sonstigen Vertretern anderer Couleur gnadenlos heruntergespielt wird. Als Leser kann man sich nun aussuchen, welchem der oben aufgeführten Gründe dies entsprechen mag. Das fällt mal mehr, mal weniger schwer.

Neben den technisch (noch) völlig unmöglichen und rein aus Spaß heraus erdachten Plänen eines weltweit agierenden Internetversandhändlers, zukünftig Pakete seiner Kunden mit Drohnen zuzustellen, sofern diese in einem Umkreis von höchstens 16km entfernten Versandzentren wohnen [via], hat es sich auch die Deutsche Post nicht nehmen lassen hier herumzu-spin-nen: Sie testete vor zwei Tagen erst einen sogenannten „Paketkopter“, der medienwirksam mit einem kleinen Päckchen 50 Meter weit fliegen konnte.

Anhand des Post-Drohnen-Beispiels kurz, schließlich fand der „Spaß“ hierzulande unter Verwendung der deutschen Sprache statt, was man unter einem beispielhaften Spin versteht:

* Einladungen an diverse Medienvertreter, vornehmlich mit Kameras (am besten die größten Idioten in dem Feld, technische Kompetenz ist nicht erwünscht)

* dem Platzieren eines „Publikums“ (kann, muss nicht mal echt sein. Ebenfalls bloß keine Technik-Freaks!)

* das „Publikum“ sollte durch die größte Kleinigkeit begeistert werden können (ausgiebiges Lachen, Klatschen, etc.; Vorhandensein von Intelligenz nicht erwünscht)

* deutliches Ansagen diverser populärer Claims, z.B. aus dem militärischen Bereich, wie:

„Der Adler ist gelandet!“

„Lufthoheit!“

„Forschungsprojekt!“

„Spannende Technologie!“

„Deutliche Vorteile!“

„Weiterentwicklung der Technik!“

„Wird nie krank!“

„Arbeitet immer!“

* dem Herunterspielen für das Umsetzen tatsächlicher Pläne, wie

„Noch lange hin!“

„Noch gar nicht gesetzlich geregelt!“

„Braucht Weiterentwicklung!“

„Viel zu teuer!“

„Akku zu schwach!“

Das Schlimme bei Drohnen ist, das war aber bereits bei GPS und dem frühen Internet beobachtbar: Es wird erst militärisch entwickelt und eingesetzt, danach in der freien Wirtschaft, und am Ende verkauft man es als die totale Befreiung und etwas tatsächlich Gutes. In Wirklichkeit aber wird es permanent missbraucht, es lässt sich nicht mehr rückgängig machen, ist zeitweise unkontrollierbar und es schadet dem Individuum.

Der Unterschied: Wir können mittlerweile selbst diesen Prozess verfolgen. Bei Drohnen noch viel besser wie bei GPS und Internet/ARPANET, denn wir haben plötzlich die Werkzeuge dafür.

Die Geschichte der Drohnen ist eng mit militärischen Zwecken verknüpft. Das ist kein Geheimnis, die Idee gibt es, seit der Mensch sich aufgemacht hat die Lüfte zu erobern. Dass es bisher einfach nicht beachtet wurde ist das Besorgniserregende. Und derzeit, das ist noch viel besorgniserregender, gibt es ernsthafte und konsequente Bemühungen von unterschiedlichsten Seiten das herunterzuspielen.

Bereits damals gab es massenhaft Überlegungen und Fragen, die heute einfach nicht mehr gestellt werden:

– wer steuert die Drohnen?

– wem steht eine Lizenz dafür zu?

– mit welcher Technik werden diese Dinger genau ausgestattet sein?

– Konsequenzen für Mensch und Tier?

– was genau soll dadurch eigentlich „besser“ werden?

Dass es eben _nicht_ gut ist, was in dem Bereich derzeit passiert, habe ich kürzlich erst verlinkt: Der Proxykrieg: Hipster-Version.

Schon alleine die Bezeichnung des seit 2002 (spätestens!) stattfindenden Krieges mit dieser Technik lässt aufhorchen: Unter normalen Umständen sollte der Begriff seit dem Ende des Kalten Krieges keine reale Anwendung mit militärischen Mitteln mehr darstellen. Stellvertreterkrieg hat es danach in den allgemeinen Sprachgebrauch geschafft. In Bezug auf diesen Artikel von mir bedeutet das, es ist ein Krieg der

I) in den Medien nicht erwähnt und/oder verarbeitet wird

II) weitestgehend im Verborgenen stattfindet und das auch bleiben soll

III) aus der Ferne geführt wird, als wäre Krieg ein Videospiel

IV) aus der Ferne geführt wird, als wäre Krieg rein virtuell und es gäbe keine realen Menschenverluste

V) ein, wenn nicht das Paradebeispiel eines asymmetrischen Krieges

Überlegen ist in diesem Krieg der, der die bessere Technik besitzt. Soziale Kompetenzen sind hier unnötig. Ebenso legt man außer auf die Reaktionszeit keinerlei Wert auf irgendwelche menschlichen Fähigkeiten. Das nächste Ziel, so kann man es aus Artikeln lesen, ist noch nicht einmal mehr das Vorhandensein eines menschlichen Operators, sondern autarke Tötungsmaschinen. Denkbar sind sprach- oder gestengesteuerte Computerprogramme, die messerscharfe Algorithmen ausführen, überall auf dem Planeten und wohl auch im Weltall, und sich sogar durch eigenes Handeln und Erfahrung selbstständig weiterentwickeln können.

Das 21. Jahrhundert wird nicht witzig, lasst euch hier bloß keinen Scheiß erzählen. Es gibt nach wie vor akute „alte“ Bedrohungen wie Kernwaffen, Überbevölkerung, Klimawandel, die angepackt werden müssen, soll es die nachfolgenden Jahrhunderte weiterhin einen Planeten Erde im Sonnensystem geben. Drohnen so zu sehen als wären es irgendwelche Spielzeuge, lustige Robotniks, die man sich gegenseitig unter den Weihnachtsbaum legen kann, ist schon aufgrund der Geschichte dieser Technik nicht nur gefährlich, sondern saudumm. Und wer es noch nicht wusste, großes Sorry: MacGyver wird es _nicht_ regeln. Für vieles ist es, leider, leider, bereits zu spät. Wer das noch nicht verstanden hat, der soll halt einfach Kuchen kaufen, wenn es kein Brot mehr gibt.

„And I can see them in my eyes when they’re closed, I can feel them at night/

I can feel them plot a course through the sky, I believe in their flight/

Drones over Brooklyn/

Dr-Drones over Brooklyn/“ – El-P, Cancer 4 Cure LP, Track #4, 2012

Das Jahr ist sehr bald schon zu Ende. Es gab massenhaft Texte, die wichtig waren. Einer der wichtigsten für mich war dieser hier:

„Theoretical physics: The origins of space and time“, via nature.com.

Mich persönlich hat das Thema Zeitreisen schon immer irgendwie beschäftigt, schon von klein auf. Auch durch die ganzen harten Katastrophen, die passiert sind, kommt man um das Thema eigentlich fast nicht herum. Es wird auch immer wieder gerne im Scifi-Genre benutzt, auch eines meiner liebsten.

Nun, jedenfalls, „neuester“ Fakt: Zeitreisen sind _nicht_ möglich.

Dafür reichte in dem Artikel dann eine einzige Grafik: Die erste in der zweiten Reihe.

Kurz gesagt: Das Problem ist die Kausalität. Es kann ab heute mehrere Wege geben in die Zukunft zu kommen. Die Vergangenheit ist nicht änderbar. Nicht mal die Betrachtungsweise.

Also keine Timelords, kein Rückgängigmachen geschichtlicher Fehler der Menschheit, kein „Zurück in die Zukunft“, rein gar nichts. Was passiert ist, ist passiert. Punkt aus. Man kann es sich nur zum Ziel setzen es für die Zukunft besser zu machen. Wobei bei den vielen Weggabelungen ab heute es natürlich auch vorkommen kann, dass man einen Weg einschlägt, der noch viel viel schlechter ist als früher. Schlimmer geht eben immer, sagt der Volksmund.

Ich habe mir in der Vergangenheit selber einen Tipp gegeben, denn ich war in meinem Verhalten da eher lax: Sorge dafür, Dinge zu vermeiden, die nicht mehr rückgängig gemacht werden können. Das passiert nämlich, so ist das Leben eben, schneller, als man denkt. Und der Artikel hat meine schlimmsten Befürchtungen diesbezüglich gnadenlos bestätigt.

Wenn man diese Grafik sieht wird einem das erneut bewusst. Leider ist durch diesen Text auch meine Fantasie zerstört worden, ein paar Gedankenexperimente in diesem Bereich zu vollführen. You can’t fuck truth und das ist am Ende halt auch gut so. Nur habe ich seitdem das Problem, Leute, vor allem auch Künstler, nicht mehr für voll zu nehmen, die solche Konzepte ernsthaft in Erwägung ziehen. Janelle Monáe ist so ein jüngerer Fall, die das ja in einem Interview zugegeben hat, an Zeitreisen genauso zu glauben wie an die Singularität.

Den Artikel kann ich nur jedem empfehlen. Hier kommen wichtige Konzepte zur Funktion und den Rätseln unseres Universums zur Sprache, die Kausalität ist sogar nur eine Randnotiz, die eben für mich persönlich äußerst relevant war. Man wird seine Schwierigkeiten haben das an einem Stück zu lesen, aber es lohnt sich. Die besten Texte sind die, zu denen man nach einiger Zeit zurückkehrt.

(Quelle: Business Insider)

Das NRO ist ein „Militärnachrichtendienst“ der USA, 1961 gegründet, strikt geheim gewesen bis 1992 und verantwortlich für das militärische Satellitenprogramm. Das Personal wird vom Militär, sowie der CIA gestellt, die Kosten teilen sich die CIA und das Pentagon.

Bei dem jüngsten Überwachungsprojekt, Codename NROL-39, erst letzten Donnerstag in den Orbit geschossen, beweisen die eine ungewöhnliche Form von Humor: Auf dem Logo prangt ein gelber Krake, ähnlich der mythologischen Figur Cthulhu aus dem Repertoire des US-Horror-Autors H.P. Lovecraft.

Im Zuge des NSA-GCHQ-Abhörskandals, der seit Juni schwelt, natürlich bestens gewählt.

Aber das reichte denen auch nicht. Darunter ist zusätzlich der Spruch zu sehen „Nothing is beyond our reach“.

Und dieser Claim ist 100% ernst gemeint:

„NROL-39 is represented by the octopus, a versatile, adaptable, and highly intelligent creature. Emblematically, enemies of the United States can be reached no matter where they choose to hide, […]“

sprach Unternehmenssprecherin Karen Fergurson gegenüber Forbes und fand das gut so.

Mit Symbolen arbeitet man bei der NRO gerne: Es gibt einen eigenen Wikipedia-Eintrag nur zu deren Logos von den Überwachungssatelliten. Selbstredend wird natürlich auch der Illuminati-Mythos bedient, zweimal, dreimal; also bitte, wenn schon denn schon. Mit Raketen und so vor der Pyramide, voll titte!

Wer Näheres zu diesen Symbolen erfahren möchte, dem sei folgendes Riesenbuch empfohlen: „Codex Magica“, von Texe Marrs. Bezüglich der präsentierten Bildbeispiele dort kann man übrigens auch hervorragend Fernsehbilder und Presseartikel abscannen. Selbst SPIEGEL ONLINE arbeitet gerne mal so, es handelt sich hierbei als nicht um ein Hirngespinst, das nur von Militärs verwendet wird.

Oha: Microsoft will an die Brüste der Damen dieser Welt.

Dafür haben eine Handvoll Entwickler in deren Research-Team einen BH entwickelt, der mit Sensoren ausgestattet ist, um allerlei Zeug zu messen:

* Herzschlag(!)

* Atmung(!)

* Hautleitfähigkeit(?)

* Bewegung allgemein

Diese Indikatoren sind, scheinbar, zuständig dafür, wie gestresst frau heute ist. Und deshalb, offizieller Grund aus dem Hause Microsoft, ich habe nichts damit zu tun, überfressen sich (over-eating) viele Damen. Das will man dort durch einen „smarten BH“ nun verhindern.

Der schickt einen Tweet(!) auf das Smartphone, sobald „Gefahr“ besteht; eine Gefahr, die ein zweifelhaftes Software-Unternehmen aus Seattle dann vorgibt. [via] Hauptproblem noch derzeit: Der Akku hält „nur“ 4 Stunden.

Für die Männer war ebenfalls sowas angedacht: Die passende Unterhose. Doch da das Herz physikalisch zu weit von dieser Stelle ist(!), hat man die Pläne wieder fallengelassen. o.O

Die Geschichte ist dermaßen abgefahren, man hätte sie gar nicht erfinden können. Meine Dichtung ist das nicht, steht alles im Artikel.

Fassen wir zusammen: Microsoft will, offizieller Grund, das Problem der Fettleibigkeit mit Chips in Unterwäsche ein für allemal aus der Welt schaffen. Doch da man beim Schwanz den Herzschlag nicht richtig messen kann, gibt es diese Version vorerst nur für die Frauen. W.T.F.

Vielleicht ist man einfach nur neidisch auf Apple: Ohne das iPhone gäbe es keine Milliarden Selfies von knackigen splitterfasernackten blutjungen Mädels und auch nicht dieses dumme twerking. Da wollten die Redmonder eben mitmischen. Welche Idee nun die teuflischere ist, es sei dem Leser/der Leserin überlassen. In jedem Fall möchte ich mit keiner Frau Sex haben oder auch nur zusammenleben, die ihre BHs mit Sensoren von Microsoft ausstatten lässt.

Ladiez: Bitte lasst euch keinen Quatsch erzählen. BHs werden ohnehin völlig überschätzt.

Was die vom Fraunhofer-Institut für Kommunikation, Informationsverarbeitung und Ergonomie so den ganzen Tag machen würde mich ja brennend interessieren.

Ende Oktober gab es die Meldung, es wurde eine Art Trojaner aufgespürt, der „BadBIOS“ getauft wurde und der nicht damit aufzuhalten war sich zu verbreiten, selbst wenn Netzwerkverbindungen ausgeschaltet waren. Das Problem war dem Beobachter Dragos Ruiu allerdings da schon drei(!) Jahre bekannt, der hat das eben erst kürzlich veröffentlicht.

Die Frage hier war dauernd, wie so etwas möglich sein kann. Und dann biegen eben die vom FKIE um die Ecke und behaupten, rein zufällig einen Prototypen, oder eben die Idee dazu zu haben, wie so etwas in der Realität stattfinden kann:

Mit Mikrophonen und Lautsprechern in handelsüblichen Laptops, einem Audiosignal, das Menschen nicht hören können und das sogar über ein Mesh von Gerät zu Gerät wandert, mit einem maximalen Abstand zwischen einzelnen Geräten von immerhin 20(!) Metern.

Schon „lustig“.

Ars Technica hat, aus Gründen die mir nicht bekannt sind, das komplette Prozedere „verrafft“ und in einem ersten Artikel behauptet, die vom FKIE hätten diesen neuen Trojaner sogar erfunden. Das FKIE reagierte, nicht einmal angepisst, aber dass sie sich überhaupt genötigt sahen zu reagieren sagt schon Einiges aus, so:

„[…] Our mission is to strengthen security by the means of early detection and prevention of potential threats. The research on acoustical mesh networks in air was aimed at demonstrating the upcoming threat of covert communication technologies. Fraunhofer FKIE does not develop any malware or viruses and the presented proof-of-concept does not spread to other computing systems, but constitutes only a covert communication channel between hypothetical instantiations of a malware. The ultimate goal of the presented research project is to raise awareness for these kinds of attacks, and to deliver appropriate countermeasures to our customers.“

Die Frage ist am Ende, wer denn diese „Kunden“ sein sollen. Also die „Kunden“ bekommen dann Mittel an die Hand, solche Angriffe abzuwehren. Sucht man auf Wikipedia in deutschen Einträgen nach FKIE, gibt es keinen eigenen Eintrag. Doch scrollt man die Ergebnisse durch, findet man heraus:

„Fraunhofer-Institute FKIE und FHR, ehemals Forschungsinstitute der Forschungsgesellschaft für Angewandte Naturwissenschaften FGAN in Wachtberg bei Bonn (Institute zur Erforschung neuer Radar- und Kryptoverfahren für militärische Anwendungen, finanziert aus Mitteln des Bundesministeriums für Verteidigung[37][38][39])“

Quelle: https://de.wikipedia.org/wiki/Bundesnachrichtendienst#Andere_kooperierende_Dienststellen_des_Bundes

Soll ich jetzt zu schreiben aufhören, eigentlich hat sich das Geschwätz doch erledigt, oder!?

Und nur um mal ein Gefühl dafür zu kriegen, was dem Herrn Dragos Ruiu damals mit seinem Mac(!) passiert ist, das war nicht mal ein Window$-Rechner, dürft ihr euch jetzt selbst einlesen, was diese „Erfindung“ für die Gegenwart bedeutet. Ich verlinke erstmal nichts mehr. Die labern hier alle von „Zukunft der Malware“; Alter, das passierte dem Ruiu 2010, die lachen sich heute über diese Technologie den Ast ab bei der NSA und entsprechenden Schergendiensten.

András Kornai ist mathematischer Linguist. Das ist ein cooler, aber sehr komplexer Beruf.

In einer seiner Studien, die er Ende Oktober publiziert hat, kam er zu dem Schluss, dass bisher weniger als 5% aller Sprachen auf der Welt, das sind derzeit immerhin fast 7.000, es bislang in das digitale Zeitalter geschafft haben.

In Zahlen: Das Internet repräsentiert von 7.000 Sprachen gerade einmal 280.

Das ist extrem verstörend.

Die UNESCO gehört zu den Institutionen, die für solche Fälle einen Atlas führt, ähnlich dem für gefährdete Tierarten. Von den 7.000 Sprachen, die es heute noch gibt, sind ohnehin fast 2.500 vom Aussterben bedroht. Da kommt diese Nachricht natürlich. Nicht. Gut.

Die Studie liegt oben im Original vor. Sie ist entsprechend lang und auch teilweise sperrig zu lesen, aber verdammt wichtig. Wer dafür keine Zeit hat, der kann auch den Artikel von Alex Mayyasi lesen, der zumindest den Versuch unternimmt das so zusammenzufassen, dass man es schnell aufnehmen: „Only 4% of Languages Are Used Online“, via priceonomics.com.

Schlusswort: Wäre man bitterböse, könnte man einfach behaupten: It was designed that way. Egal was man heute elektronisch macht, die Funktionen dazu liegen fast ausschließlich im englischen Original vor. Das betrifft Code, Hardware, das komplette Internet.

Der eigentliche Sinn allerdings damals, wenn man das Web betrachtet zumindest, war ein anderer. Es war nicht nur für eine Sprache entworfen worden. Wer das nicht glaubt, der soll sich den Zustand mal vor UTF-8 anschauen. Trotzdem deckt natürlich auch diese komplexe Zeichenkodierung nicht 7.000 Sprachen ab. Das kann sie niemals. Auch Nachfolger nicht.

Am Ende droht uns die komplette Verkrüppelung der Sprache, wenn sich dieser Trend am Ende durchsetzt. In dem Artikel steht, das erfolge in drei Schritten:

1) der Verlust der Funktion von Sprache (bereits beobachtbar beim weltweiten Handel)

2) der Verlust des Ansehens von Sprache (heute bereits bei der jüngeren Generation sicht- bzw. v.a. hörbar)

3) der Verlust der Sprachkompetenz (die junge Generation versteht die alte zwar noch, benutzt aber eine stark vereinfachte Version von Grammatik. Kennt jemand das Mem mit youre und you’re!? LOL, ROFL, ASL, anyone!? Eben)

Der Sprache droht das selbe Schicksal wie den Dinosaurieren. Die Frage ist, ob wirklich die Wichtigkeit für irgendwas oder irgendjemanden besteht, diesen Kometen abzuwehren.

NEIL schläft nie: Das Akronym steht für Never Ending Image Learning. Und seit Mitte Juli macht dieser Cluster nichts anderes:

Das System scannt, in kleinen Schritten, 24/7 das Internet nach Bildern ab.

Es soll dabei selbst entscheiden, wie diese Bilder im Zusammenhang stehen.

Das Ziel: Common Sense. Das bedeutet übersetzt: Gesunder Menschenverstand(!). Die Fähigkeit Dinge zu erlernen, die NEIL nicht extra beigebracht wurden bzw. beigebracht werden mussten.

[via]

Das Tandem, das dieses Projekt an der Carnegie Mellon University zusammen leitet, ist ebenfalls interessant: Zum einen ist es Google. Der andere „Partner“ die US-Navy.

NEIL hat bislang mit seinen 200 CPUs 1.500 Objekte und 1.200 Szenen in vier Monaten erfasst, dabei 2.500 Assoziationen geknüpft.

Natürlich kam auch viel Unsinn heraus: Etwa „ein Rhinozeros ist eine Form der Antilope“ oder „Schauspieler kann man in Gefängnissen finden“ (wobei ich mit dem Wahrheitsgehalt von Letzterem leben könnte). Trotzdem scheinen die Verantwortlichen ganz zufrieden zu sein; wie auch immer man das hier definiert…

Der Plan? YouTube! Kommt als nächstes. Was das Ganze soll? Offenkundig. Auf direkte Anfragen der Washington Post wollte weder Google, noch die Navy antworten. Man kann es sich aber denken. Zitat von der Website der Navy:

„Today’s battlespace environment is much more complex than in the past“ and „the rate at which data is arriving into the decision-making system is growing, while the number of humans available to convert the data to actionable intelligence is decreasing.“

Braucht man keine Website des US-Militärs dazu. Kann man auch so darauf kommen, mit Common Sense…

War mir klar, nur nicht warum: Das Netzwerk der Wetterstationen deckt nur 85% des Planeten ab. Boing!

Und der Witz kommt jetzt: Das schon seit 1997.

Was die Wetterdaten-Rekonstrukteure dann machen kriegt jedes Kind selber hin: Sie heben den Daumen in den Wind und schauen, ob er sich bewegt. Hilft bestimmt…

Nun, vielleicht ändert sich das ja bald, wird höchste Zeit: Kevin Cowtan (University of York) und Robert Way (University of Ottawa) wollen die Lücken mit Satellitendaten füllen. Wie das geht erläutern sie in diesem Video.

Das funktioniere wohl am besten über Ozeanen. Doch für die Regionen mit den Messdatenfehlern an Land ist ein hybrides Modell nötig. Ob das in dem Video erwähnt wird kann ich nicht sagen, kann das gerade nicht ansehen.

Geistreiches zum Schluss:

„…short term trends are generally treated with a suitable level of caution by specialists in the field, they feature significantly in the public discourse on climate change.“

Heißt: Experten raten davon ab, Messdaten für Vergleiche zu nutzen, die nur einen kurzen Zeitraum abdecken. Und doch sind es diese Daten, die in der Diskussion zum Klimawandel Verwendung finden. Lasse ich gerne so stehen.

Eine Handvoll verrückter Russen plant den Windows-Komplett-Ersatz:

Vorbild ist Windows selbst. o.O

Der Name für diese Alternative: ReactOS.

Seit 2004 ist Alex Ionescu der Hauptverantwortliche für die Kernelentwicklung und in dem Video hier bringt er alle Interessierten auf den neuesten Stand. Bisher wurde der Film von über 21.000 Menschen angeschaut.

Wer den Artikel bei Wikipedia durchliest, bemerkt eine sehr bewegte Geschichte, die tatsächlich bis 1996 zurückreicht. Damals war man noch an einem Reverse Engineering von Windows 95 interessiert, was komplett verrückt erscheint heute. ReactOS selbst ist allerdings erst seit 2003 zu haben.

Wer das bereits heute ausprobieren möchte (es sollen ja Windows-Programme schon jetzt zum Teil lauffähig sein), hier die Hauptseite des Projekts: http://reactos.org/de.

Gut, ich will aber das Negative auch nicht unerwähnt lassen:

1) Angesichts bereits erhältlicher echter freier Alternativen ist die Entwicklung eines solchen Betriebssystems unsinnig

2) sollte ReactOS mal durch die Decke gehen, was eher unwahrscheinlich erscheint, werden es sich die Redmonder nicht nehmen lassen auf ihre unvergleichliche Weise dagegen vorzugehen

3) Nicht nur Microsoft wird dann der Feind sein: Adobe, Oracle, SAP und viele weitere Unternehmen mehr profitieren direkt davon, dass sie auf einem geschlossenen Betriebssystem laufen. Sobald man „von unten her“ verfolgen können wird, was deren Programme mit dem Betriebssystem machen (und umgekehrt), wird sich da etwas Dunkles zusammenbrauen

4) ReactOS ist unnötig politisch: Als Dmitri Medwedew 2011 Präsident von Russland war, wurde ihm das Projekt persönlich vorgestellt. Im selben Jahr wurden 100.000 Rubel ausgeschüttet. Und seit 2012 weiß auch der gute Putin davon: Die Präsentation beim Seliger Youth Forum wurde von Marat Karatov durchgeführt

Also im Kern sieht es doch schwer danach aus, dass der ehemalige Ostblock mit Russland zusammen nach einer effektiven Waffe gegen die Dominanz von Windows auf handelsüblichen PCs sucht. Aus Europa stammt immerhin Linux, wir haben so etwas nicht nötig. Und Putin ist auch bekannt dafür, genau solche Richtungen zu verfolgen. Habe ich persönlich kein Problem damit, sollen sie machen, mal schauen wie es ausgeht. Der Sinn davon erschließt sich mir nicht. Die Windows-Architektur zu klonen, mit Werkzeugen von hier und Gedöns von da, erscheint mir nicht wirklich originell.

Ich mache mal ein wenig Werbung in eigener Sache. Ein paar Kollegen, mit denen ich früher in die (Berufs-)Schule gegangen bin, haben eine Unterbrechungsfreie StromVersorgung für den Minirechner Raspberry Pi entwickelt:

Das Projekt selbst wurde aus einer Not heraus geboren, da es wohl diverse SD-Karten zerschossen hat, weil das Teil einfach nicht korrekt herunterfuhr. Die USV verhindert solche Dinge und noch viel mehr, hier steht, was eine USV überhaupt ist.

Die ganze Idee fängt gerade an mächtig durch die Decke zu gehen, was in dem Ausmaß nicht vorhersehbar war. Wenn ihr selbst eine USV erwerben wollt, besucht einfach diese Seite:

Der momentane Preis für die USV ist an eine Aktion gebunden. Momentan kostet sie 23,76€ (Stand heute), ab dem 26. Dezember, dem voraussichtlichen Lieferdatum, dann 29,99€. Auch kann man sich als „Early Adopter“ wohl noch die Farbe der Platine (gelb, blau, rot, grün, etc.) raussuchen.

Wichtig: In dem Video dort ist noch der Prototyp zu sehen. Die fertige Platine steckt man einfach auf den GPIO-Port des Pi, wobei auch die Anschlüsse weiterhin für andere Anwendungen auf diesem Port erhalten bleiben. Sobald es hier Bilder gibt, werde ich die mit einem Update nachreichen.*

Die Überwachungssoftware wird übrigens auch von denen entwickelt werden. CW2. ist im Kern ein Software-Unternehmen mit Schwerpunkt auf Business-Software-Lösungen aus dem Stuttgarter Raum. Das ist deren erstes kommerzielles Hardware-Projekt. Ich bin gespannt, wie das ausgeht und drücke natürlich die Daumen.

*[Update I, 14.11.13]

Seit heute sind auch die Bilder eingefügt, wie ihr oben sehen könnt. Wenn ihr Kontaktdaten braucht, einfach bei mir kurz melden!

Perfekt: Aktenzeichen 26 O 211/13. Darin steht:

„Die Deutsche Telekom darf nach einer Entscheidung des Kölner Landgerichts die Surfgeschwindigkeit bei Pauschaltarifen nicht einschränken. Eine entsprechende Vertragsklausel erklärte das Kölner Landgericht am Mittwoch für unzulässig. Das Urteil betreffe sowohl die ursprünglich angekündigte Drosselung auf 384 Kilobit als auch diejenige auf zwei Megabit pro Sekunde.“ [via]

Danke Köln! Wir von der New-Media-Front dürfen weiterarbeiten. Die alten Säcke wieder mit ihren „Plänen“ für unsere Zukunft. Kommt, geht sterben! Taugt eh nix.

„Be an ally. If you understand and care enough to have read this far, we need your help. To really challenge the surveillance state, you need to teach others what you’ve learned, and explain to them why it’s important“

Also gut. Dann helfe ich der EFF mal das Wort zu verbreiten: https://eff.org/deeplinks/2013/10/ten-steps-against-surveillance.

Schließlich profitiere ich unmittelbar von diesem ganzen NSA-Skandal.

:: prolog

Zum einen erscheinen viele Texte von mir heute wohl in einem etwas anderen Licht. Und obwohl ich mir manchmal selbst wünsche, es wären reine dunkle Fantasien gewesen, bin ich doch ganz froh, dass sich meine schlimmsten Befürchtungen bewahrheitet haben. Es trägt zu meiner Glaubwürdigkeit bei und auch zu meiner Weitsicht. Hätte sich manch einer aus meinem „Freundeskreis“ bzw. „Familie“ lieber mal zu Herzen genommen. Willkommen im Club! Zweitens: Das Interesse an den Themen schlägt sich ganz konkret auch in den Besucherzahlen nieder. Seit den Enthüllungen im Juni sehe ich Zuwachsraten von 70%. Ende nicht in Sicht. Trotzdem bleibt das hier ein kleines Projekt mit dreistelligen Besucherzahlen im unteren Bereich. Mal sehen, wie sich das entwickelt. Nun zu den…

:: tools

In dem Artikel finde ich eine NSA-Präsentation besonders interessant: „TOR stinks“, 23 Folien, via theguardian.com. Darin echauffieren sich die Dienste aus den USA und UK, dass man überhaupt nicht „alle TOR-User jederzeit“ identifizieren könne. Echt schade.

Naja, das führt uns zum allerersten Schritt: Nutzt TOR! Das Browser-Bundle ist schnell entpackt und sofort einsatzbereit. Es frisst aber Ressourcen, eine taugbare PC-Maschine mit entsprechenden Specs ist also von Vorteil.

Zweitens: Email-Verschlüsselung benutzen. In dem Artikel wird natürlich wieder PGP erwähnt. Auch steht da, es sei „tricky to use“. Das lese ich immer wieder, es stimmt aber nicht. Nicht wirklich: Das Einrichten ist tricky. Hat man das gemacht, etwa mit Thunderbird und Enigmail, ist das Benutzen kinderleicht. Es gibt einfach Probleme bei den Nutzern selbst: Entweder die sind zu faul oder zu leichtsinnig oder zu starrsinnig oder wasauchimmer. Auch diese Schlüsselaustauscherei ist ein riesen Problem. Das ist das Einzige, was ich an Cryptopartys gut finde. Die finden oft und gerne zu politischen Zwecken statt. Aber man findet schnell Gleichgesinnte, um Schlüssel austauschen zu können.

Drittens, auch sehr nageliegend: HTTPS Everywhere benutzen. Und VPN (Virtual Private Network), wenn an öffentlichen Plätzen gesurft wird. Besonders VPN ist nicht immer einfach einzurichten auf mobilen Geräten. Viel Spaß hier!

Viertens: Passwort-Management-Software benutzen. Und Passwörter wählen, die _nicht_ zu merken sind. Ist aber ein Extraaufwand und fast untauglich im täglichen Umgang. Selber mal probieren, schadet ja nicht.

Fünftes: Festplatten verschlüsseln, wo es eben geht. Nachträglich fast unmöglich…

:: eigene erfahrungen

Naja, es gibt so viel, was ich im Laufe der Zeit selbst gemacht habe. Ein wichtiger Punkt war, aus der Abhängigkeit von Microsoft auszubrechen. Das war irgendwann Mitte der letzten Dekade und das Ziel wurde mit einer Vehemenz verfolgt, die mir heute unheimlich ist. Es war aber verdammt wichtig. Auch für mich persönlich. Sieht man ja jetzt. Daher ist der erste Schritt immer: Ein offenes Betriebssystem wählen! Eine Übersicht findet man hier ganz oben: http://prism-break.org/#de. Generell muss man sein Linux erst finden. Das dauert, aber eine ausführlichere Übersicht findet sich hier: Distrowatch, sortiert nach Popularität. Übrigens ist BSD natürlich genauso wichtig. Muss jeder selbst wissen.

Das darf aber bei dem PC nicht aufhören. Das sieht man mit den Smartphones: Zwar ist Android ein Produkt von Google, wird aber streng kontrolliert und Mechanismen implementiert, die nicht zum Vorteil der Nutzer sind. Doch es gibt weiterhin AOSP und Cyanogenmod, die, je weiter die Zeit voranschreitet, unverzichtbar sein werden.

Dann gibt es mittlerweile Hardware, die ganz speziell den offenen Charakter würdigt. Die PlayStation 3 war ein wichtiger Schritt in diese Richtung, wenngleich die Möglichkeit Linux auf der Konsole zu installieren durch paranoide Sony-Manager irgendwann gekappt wurde. Es gibt Drucker die von Haus Linux unterstützen, siehe die Liste hier. Und der gute Raspberry Pi aus England darf ebenso nicht fehlen.

Mehr fällt mir selbst gerade fast nicht ein. Denn: Weitere Ideen werden ja weiterhin gesammelt und stehen zur freien Verfügung, http://prism-break.org/#de. Das betrifft soziale Netzwerke, Plattformen für die eigenen Photos, eigene Texte, etc. Manche Dinge wurden seit Sommer auch hier ausführlichst präsentiert.

:: ausblick

Ich habe erst heute morgen wieder einen Text gelesen und das ist beunruhigend. Da muss man sich selbst einen Reim darauf machen und schauen, wie ernst man das nimmt:

1. „Hackers are seen not as mere miscreants, but as dangerous enemies of the fundamental established order of society.“

2. „just the first salvo in the war on general-purpose computing“ -> „buckle your seat belt. Because if I’m right, then this next decade is going to be an awfully bumpy ride“

[via]

Das sieht schwer nach Krieg aus. Problem: Der läuft bestimmt nicht erst seit diesen Sommer. Zeit, dass es endlich ankommt.