Archiv für die Kategorie „PC“

Wirklich cool:

Die GPU-Evolution von Nvidia-Grafikkarten von 1995 bis 2020 in nur einem Video!

Das Erste, was auffällt, ist dass ab Ende der 90er eine Passivkühlung nicht mehr ausreicht. Die Grafikchips müssen so heiß geworden sein, dass auf der Platine standardmäßig ein eigener Lüfter für den GPU-Chip verbaut wird.

Auch wird der Lüfter selbst ab dem Jahr 2000 immer größer.

Ab 2007 verschwindet die Platine komplett unter Abdeckungen, meist aus simplem Plastik. Außer dem PCI(E)-Steckverbinder sieht man absolut nichts mehr von den Chips, Widerständen und Kondensatoren. Schade für Hardware-Fans. Selbst durch den Lüfter selbst sieht man meist nichts mehr.

Ich selbst besitze noch eine 7950GT AGP. Damals die stärkste AGP-Grafikkarte von Nvidia. Sie ist verbaut und läuft auch heute noch 1-2 Mal im Jahr in einem alten Desktop-PC (eigentlich mein allerletzter Desktop-PC) aus den Nuller-Jahren. Gebrauchte Exemplare gehen bei Ebay gerne für mehrere hundert Euro weg. Warum ist mir nicht bekannt.

Wer hochwertige Gadgets möchte, der kauft bei Samsung. Wer schon mal einen Sony Bravia-TV auseinandergebaut hat oder ein iPhone, hier sind Teile von Samsung verbaut. Chips, Displays, Inverter – you name it.

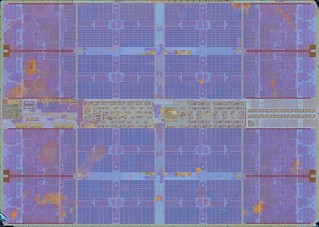

Doch auch als Innovatoren können die Südkoreaner sehr gut, ihr neustes vielversprechendes Hardware-Bauteil: ein KI-RAM.

Intern nennen sie es FIMDRAM, im Detail schaut der Die (Halbleiter-Waferstückchen) dann so aus:

Praktisch haben sie wohl „einfach“ programmierbare Recheneinheiten (Programmable Computing Units (PCU)) zwischen die Speicherbänke verbaut. Die können zwar aktuell lediglich 16-bitige Fließkommazahlen verarbeiten und verfügen nur über einfache Instruktionen (Daten verschieben; Multiplikation; Addition). Dennoch clocken diese mit 300MHz – was einer Leistung von 1,2 TFLOPS entsprechen soll. Das ist enorm: zum Vergleich, das gesamte PS4-System (keine Pro-Version) bringt 1,84 TFLOPS Leistung…

Samsungs neuartiger RAM im Detail (PPTs): https://m.gsmarena.com/samsung_creates_ram_with_integrated_ai_processing_hardware-news-47794.php.

Hardwareseitig könnte man effizientere KI-CPUs wohl aktuell nicht bauen. Die Latenzen sind hier sehr gering, ferner verbrauchen die Chips 71% weniger Energie. Ein Wermutstropfen bleibt aber noch: nicht nur wird das Design erst diese Woche bei der International Solid-State Circuits Virtual Conference von den Südkoreanern der Weltöffentlichkeit präsentiert. Die Validierung von Experten wird noch mindestens bis Juli dauern. Mit etwas Glück erscheinen diese speziellen neuen KI-RAM-Riegel dann wohl Ende dieses Jahr/Anfang 2022 in Hardware, die man als 0815-Konsument kaufen und programmieren können wird.

Ein Wendepunkt in der Programmierung künstlicher Intelligenz? Könnte sein. Ich persönlich traue es Samsung durchaus zu.

In „Cyberpunk 2077“ gibt es eine kleine Nebenmission, wo man die Urne von R.J. Griffin vom Friedhof zurückholen muss. Der Friedhof nennt sich Columbarium, man kommt mit Fahrzeugen hier nicht rein. Er liegt etwas außerhalb, ist ziemlich futuristisch und ähnelt einem kleinen Labyrinth.

Die labyrinthische Anordnung hat meine Spielfigur durch Zufall direkt ins Zentrum geführt, schaut mal, wer hier seine ewige virtuelle Ruhe gefunden hat:

Das ist das Grab von Cyberpunk-Legende Syd Mead! Komplett mit Hologramm und dem Epitaph „Erschaffer von Welten“. Passender könnte man es in drei Worten nicht zusammenfassen, wie ich finde.

Selbst virtuelle Legenden sind hier verewigt, direkt daneben:

Roy Batty, Antagonist von Harrison Ford im Cyberpunk-Klassiker „Blade Runner“ aus 1982! Sein Epitaph: „All diese Momente werden in der Zeit verloren gehen, wie Tränen im Regen“. Wer den Film kennt, weiß genau, wann und wo diese Zeile fiel, auch das Hologramm hier, die weiße Taube, ist ein Hinweis darauf.

Die Welt von Night City ist dermaßen detailliert und groß, es gibt Unmengen solcher Easter Eggs, die die Entwickler hier zum Entdecken liegen gelassen haben – nicht nur auf diesem Friedhof. Diese zwei hier lagen mir am Herzen zu zeigen zum einen, weil es reiner Zufall war, dass ich das Zentrum des Columbariums mir angelesen hatte. Zum anderen, weil ich es bemerkenswert fand, dass den Entwicklern solche Protagonisten des Genres doch sehr am Herzen gelegen haben müssen. Nach einer Ca$hkuh, die um jeden Preis gemolken werden muss, sieht mir das hier nicht aus.

Noch mehr Screenshots gibt es in der Galerie unseres Schwesterblogs zockerseele.com, 100 Stunden Spielzeit bisher, satte 778 davon: https://zockerseele.com/photos/index.php?/category/60.

Obwohl uns technisch die VR (Virtuelle Realität) bereits seit den 1980er Jahren begleitet, fristet die Technik bis heute ein Schattendasein. Dabei sind die Anwendungen damit sehr vielversprechend und die Immersion unschlagbar, selbst die Weltraumagentur NASA setzte zu Trainingszwecken sehr früh darauf.

Einzig, es fehlt bis heute, 40 Jahre nach der Premiere, nach wie vor „die Killer-Applikation“ dafür, die dieser Technologie zum Durchbruch verhilft.

Macht nichts, zumindest solange es solche Projekte wie „Radiance“ gibt:

Eigens erstellte MP4-Preview mit SimpleScreenRecorder und Firefox 84.0.2

Was „Radiance“ macht ist ein idealistisches Ziel und hat sehr viel damit zu tun, wie wir Internettechnologien allgemein in den 90ern betrachteten, lange vor der brutalen und sinnlosen Zerstörung durch „Smartphones“ und „soziale Medien“: es ist ein Kunst- und Forschungsprojekt und sammelt Künstler inklusive deren Werke, die „das Sichtbarmachen und die Zugänglichkeit der virtuellen Realität im Sinne schnellerer Adaption“ vorantreiben wollen (im englischsprachigen Original: „Its mission is to present artists working with VR from all over the world to create visibility and accessibility for VR art and for faster adoption of virtual technologies“).

Insofern verwundert es nicht, dass die aktuelle Datenbank gerade mal 165 Künstler aus nur 37 Ländern zurückliefert. Dennoch: es ist ein guter Anfang und ebenso ein Terrain mit noch viel (Star-)Potenzial.

Heute kosten VR-Geräte lediglich ein paar Hundert Euro, im Vergleich zu vielen Tausend vor 20 oder 30 Jahren. Durch Interoperabilität mit herkömmlichen PCs, z.B. durch universelle USB-Anschlüsse, ist das Aufnehmen und Weiterverbreiten in heutigen Zeiten ein Kinderspiel. Als Umgebungen bieten sich in Lockdown-Zeiten sogar die eigenen Räumlichkeiten an.

Insofern können wir wörtlich nehmen, was auf der Seite steht: „Radiance ist eine großartige und einzigartige Möglichkeit VR-Kunst und Museen zusammenzubringen“. Mir gefällt’s!

Was wir hier sehen ist ein tragbarer Oxford Nanopore-DNS-Sequenzierer in Aktion mit einer Software namens UNCALLED, angeschlossen über einen USB-Port eines Laptops:

Das Revolutionäre auf diesem Foto ist nicht mal das portable Gerät, das ist als Gizmo alleine schon ziemlich modern und cool.

Sondern die UNCALLED-Software, ein OpenSource-Kunststück: ermöglicht sie nämlich die Bestimmung von DNS, also dem Quellcode von Leben, in Rekordzeit – sie wird verkürzt auf 3 Tage statt 15, manchmal reicht sogar schon ein einziger Tag. [via]

Funktioniert so: man braucht ein DNS-Sample, beispielsweise Blut oder ein bisschen Speichel. Dieses wird in Milliarden, manchmal Billionen kleinere Teile aufgeteilt, sogenannte fragmentierte Moleküle (schätze das sind die „Nanopores“, es gibt keinen deutschsprachigen Wikipedia-Artikel dafür…). Über eine Pipette (siehe Bild) fügt man anschließend die Lösung dem Nanopore-USB-Sequenzierer zu. Dieses Gerät kostet nur wenige Tausend Euro. Ein Sequenzierer nimmt nun diese Moleküle, das können schon einmal 512 oder mehr sein, und liest diese komplett ein, eins nach dem anderen. Dieser Vorgang war bisher sehr zeitaufwendig und wenig clever oder effizient.

Hier kommt nun UNCALLED ins Spiel: es prüft vorab und sehr schnell ob ein bestimmtes Molekül interessant für eine weitere Untersuchung ist. Wenn ja, wird es komplett ausgelesen wie bisher. Wenn nicht, stoppt die Software und ignoriert das Molekül, es wird ejected.

Die Software kann man sich als eine Art Tuner für die Nanopore-Hardware vorstellen: sie holt einfach Effizienz und Schnelligkeit aus dem vorhandenen Gerät raus. Etwas, was Hacker generell sehr oft machen, wenn sie an Software-Code arbeiten – früher waren Hardwareverfügbarkeit und -leistung noch sehr begrenzt, man musste sich Gedanken machen wie man mit Code das Beste aus dieser herausholt. Videospiele auf Konsolen zu entwickeln mag man hier als gutes Beispiel herannehmen – oft ist die Hardware bereits viele Jahre alt, bis ein Studio einen Blockbuster-Titel entwickelt hat und veröffentlicht.

Ein praktisches Beispiel für die oben erwähnte Software gibt es zum Abschluss: in einem 3-Tages-Testlauf zur Untersuchung spezifischer Krebs-Gene wurden gleich viele relevante Ergebnisse zurückgeliefert wie durch fünf gleichzeitig laufende Untersuchungen. Die Forscher betonen, 3 Tage war beliebig gewählt – es könnte in einem abgeschlossen sein.

In der Praxis wird durch diese Methodik es bereits in naher Zukunft einfacher unbekanntes Erbgut zu untersuchen. Ein Beispiel: den Niederlanden war es erst möglich am 27. Februar den ersten COVID-19-Fall zu untersuchen, da war das gefährliche Virus bereits fast zwei volle Monate überall in der Welt. Fertig analysiert war es hingegen erst am 29. Februar. Ohne die Details zu kennen ist jedoch keine zuverlässige Testung möglich. Was das erfolgreiche Erkennen von SARS-CoV-2 bei Patienten in Holland bis in den März 2020 verschob. Verlorene und wertvolle Zeit, die in dem Falle sogar Menschenleben wert war.

Fast vergessen, heute ist _der_ Tag des Jahres:

Gameplay-Trailer, Altersprüfung erforderlich

Offizieller Tag der Veröffentlichung des Open-World-Epos „Cyberpunk 2077“! Aus der Feder eines europäischen(!) Entwicklerstudios, CD Projekt (u.a. „The Witcher“)!

Ein Videospiel, das mehr Textzeilen enthält als die Trilogie „Herr der Ringe“ plus „Der Hobbit“ sollte als Cyberpunk-Definition dann auch ziemlich komplett sein; wenn die Atmosphäre und Grafik das nicht nebenbei schon regeln. 🙂

Happy Gaming! Und ward für Monate nicht mehr gesehen…

Apple hat dieser Tage neue „Macbooks“ präsentiert. Äußerlich hat sich nicht viel getan, außer einer neuen Taste für Emojis (oh, yeah!11). Aber wie immer zählen ja innere Werte: und da werkelt nun der hauseigene(!) M1, Apples allererster in 5nm gefertigter ARM-SoC. Eat this, Intel!11

Ich wollte nun wissen, wie meine AMD-Laptop-CPU (Ryzen 7 4800HS, Weltpremiere 16. März 2020) im Vergleich zum M1 (Weltpremiere 17. November 2020) abschneidet. Da bot sich geekbench5 an, weil: keine Ahnung!? o.O Doch immerhin hatte ich hier bereits Ergebnisse vom Juli vorliegen. Und das „Tryout“-Programm gibt es für Linux auch kostenlos.

Meine besten Ergebnisse damals:

Single-Core: 1269

Multi-Core: 8030

Die Ergebnisse des M1 aktuell:

Single-Core: 1718

Multi-Core: 7534

Gar nicht mal so schlecht für eine Handy-CPU, ihr Eierköpfe aus Cupertino!

*…klaut die Stimme von Marsimoto, der sie von Quasimoto geklaut hat, am Ende ist es auch einfach nur eingeatmetes Helium, weil den Schallwellen gefällt das, und legt dann mal los…*

Keiner kümmert sich um GPUs/

Wie geht es deiner GPU/

Frag‘ dich: was macht Klicki-Bunti-Grafik/

Es ist deine GPU, sonst nix/

STRG+Escape, die GPU taucht da nicht auf/

wieso denkt der doofe Coder, dass ich GPU nicht brauch/

CPU, RAM, mein Benutzername, Tabellenansicht/

wieso sehe ich die Prozentzahl meiner GPU nicht/

meine GPU macht mir Grafik, das ist wichtig/

meinem Pinguin fehlt ohne GPU sein Gesicht/

CPU ist das Gehirn, GPU schiebt die Optik/

Pink und Rosa – GPU, sonst nix/

Keiner kümmert sich um GPUs/

Wie geht es deiner GPU/

Frag‘ dich: was macht Klicki-Bunti-Grafik/

Es ist deine GPU, sonst nix/

Windows, Linux, Unix – alles braucht hier Grafik/

wieso sehe ich nach Reboot GPU-Temperatur nicht/

Was heißt „off“, wieso hier Reload mit rechter Maustaste/

ohne GPU nützt mir Temperatur-Widget nix/

Treiber-Treiber, immer Treiber, offen oder proprietär/

Hauptsache „Diablo“ läuft, denn was nützt hier „Solitär“/

Laptop, PC, Smartphone oder Tablet/

ohne GPU kein einziger Pixel hier, nix fett/

Keiner kümmert sich um GPUs/

Wie geht es deiner GPU/

Frag‘ dich: was macht Klicki-Bunti-Grafik/

Es ist deine GPU, sonst nix/

Helfer-Tool hier, Helfer-Tool da/

der Aufwand für jede GPU – immerda/

das Erste, was ich an neuer Hardware einrichte/

ist GPU, weil der Rest läuft bereits aus der Kiste/

„out of the box“, IT, wie sie immer sein soll/

wieso funktioniert GPU nicht, was hat sie euch getan/

liegt es vielleicht an AMD oder NVIDIA/

oder Apple, oder ARM, vielleicht auch C&A/

Keiner kümmert sich um GPUs/

Wie geht es deiner GPU/

Frag‘ dich: was macht Klicki-Bunti-Grafik/

Es ist deine GPU, sonst nix/

Meinen Stromanbieter, den freut’s/

denn heute mine ich auf GPU die Kryptocoins/

Warnschild rot, die GPU schon über 90 Grad/

warum ist Geld verdienen hier so hart/

die GPU, ja sie macht die Träume wahr/

Traumfabrik in Plastik, wir sind so smart/

und jetzt auch die KI für ein paar Hunderter/

übermorgen fliegt mich GPU zum Mars, sonnenklar/

Keiner kümmert sich um GPUs/

Wie geht es deiner GPU/

Frag‘ dich: was macht Klicki-Bunti-Grafik/

Es ist deine GPU, sonst nix/

ich schalte das Teil ab, GPU muss sich schlafen legen/

sie lief zwei Wochen durch und muss nun Updates regeln/

hoffentlich ist nach Reboot meine GPU noch da/

bei shutdown -r now denke ich über Heirat nach/

doch was ist das, ist es ein Fussel oder doch ein Haar/

wie Schuppen von den Augen wird mir dann plötzlich klar/

Mist, schon wieder zwei Zentimeter Schicht drauf/

ich muss das Ding erstmal jetzt abstauben/

Keiner kümmert sich um GPUs/

Wie geht es deiner GPU/

Frag‘ dich: was macht Klicki-Bunti-Grafik/

Es ist deine GPU, sonst nix/

Aus einem mir unerfindlichen Grund war ich bis heute geplagt mit AMD-CPU-Capping. Unter Vollast und/oder bei CPU-Temperaturen von 70C+ ging die Frequenz unter Linux einfach runter auf 399MHz. Und blieb dort. Bis zu einem Reboot.

Serious!?

Ja, ernsthaft. Und das Problem hat mich nun 80+ Tage beschäftigt. Oder eben zu selten gekümmert.

Oben: AMD Zen2 CPU: Epyc 7702 – 64-Kerne, 128 Threads, 200W

Stellt sich heraus, ich konnte wohl ein wichtiges Modul bzw. einen ASUS-Kernel-Patch nicht nutzen:

modprobe -v asus-nb-wmi

insmod /lib/modules/5.8.11-1-linux/kernel/drivers/input/serio/i8042.ko.xz

modprobe: ERROR: could not insert ‘asus_nb_wmi’: No such device

Bei mir gab es unter /sys/devices/platform/ einfach keinen Ordner asus-nb-wmi. Und der hätte ab Kernel 5.6.x wohl genau dort sein sollen. Da kann ich modproben, bis ich schwarz werde.

Was tun? Wir sind mit Internet nie alleine, zum Glück auch nicht mit Problemen, so fand ich die selbe Issue vom selben Hardware-Hersteller für ein anderes Modell, https://lab.retarded.farm/zappel/asus-rog-zephyrus-g14/-/issues/9. Man solle einfach i8042.nopnp als Kernelparameter dem GRUB hinzufügen und rebooten. Was ich tat.

Das erste Erfolgsgefühl hatte ich dann beim erneuten Modproben: keinerlei Fehlermeldung. Okay, sehr cool! Natürlich wollte ich danach wissen, ob der Ordner nun da ist: und auch der asus-nb-wmi war nun vorhanden (logisch, aber egal), inklusive Inhalte. Nice!

Wirklich etwas von der Kiste gefordert hatte ich da noch nicht, also wieder den BOINC-Client gestartet – meines Wissens „der ultimative Stresstest“ für jede CPU/GPU. Hier hatte ich auch immer wieder die Erfahrung gemacht, dass die CPU einknickt. Und tatsächlich: jetzt ist 18:00 und seit dem Mittag läuft meine CPU, eine AMD Ryzen 7 4800HS, unter Vollast mit erwartbarer dynamischer Frequenz und auch mit Temperaturen Ü70C (aktuell locker 90C, offiziell verträgt er wohl 105C).

W00t!

Nun, egal. Selbst Schuld, bleeding edge hardware gekauft zu haben… ¯\_(ツ)_/¯

2012/2013 war Secure Boot ein megaheißes Thema. So dermaßen heiß, dass ich sogar in meinem Feedreader zweistellig zählen konnte, siehe hier.

2020 ist dieses Rotzthema immer noch nicht tot.

Wie ist das möglich?

Gestern ein Update für das mitgelieferte Windows 10 auf einem Laptop gemacht, das berüchtigte Update 2004 vom Mai. Ich weiß nicht wieso, wohl aus Laune heraus oder weil ich einfach ein System wollte, wo ich nicht dauernd darauf hingewiesen werden möchte, dass es nicht 100% aktuell ist. Ich hätte es lassen sollen, denn ich verlor meinen GRUB.

Bootet anschließend Linux, bekam ich das hier heraus:

Welcome to Grub!

error: unknown filesystem.

Entering rescue mode…

grub rescue>

Jop, das war’s dann. Kein Linux will mehr booten. Und das mit ausgeschaltetem Secure Boot, ausgeschaltetem Fastboot _und_ dem manuell ausgewählten EFI-Eintrag im mitgelieferten BIOS-Interface.

Mit ls geht dann das Debugging los. Irgendwas mit (hd1,gptX) spuckt das System dann aus. Bei mir waren das 10+ Einträge. Jeden durchgehen, mit englischsprachigem Tastaturlayout, kurz vor Mitternacht, wo hängt mein verschollenes root herum?

Als es dann gefunden war, erst einmal /home gefunden, geil! Nix bootet. Glücklich war ich dann dennoch, denn irgendwie ist mein Linux ja noch da.

Da es auf einem Haussystem eigentlich nur zwei ext-Systeme geben kann wegen / und /home (oder welches Linux-Dateisystem auch immer man verwendet, z.B. reiser, etc.), hatte ich mit dem zweiten dann Glück. Mit folgenden Codezeilen brachte ich das System wieder in einen grafischen Bootzustand:

grub rescue > root=(hd1,gpt2)

grub rescue > prefix=(hd1,gpt2)/boot/grub

grub rescue > insmod normal

grub rescue > normal

Der soll dann zwar nur temporär sein, aber mir reicht das. Windows nutze ich vielleicht einmal im Schaltjahr. Dann kracht es aber richtig.

Ahhhh! Ahahahaha! Ihr Redmonder Zoophilie-Junkies mal wieder! Hatte euch schon fast komplett vergessen!

[Update I, 16.10.20]

Das mit der temporären Lösung ist einem ja irgendwann doch zu blöde, weshalb ich mir kürzlich wieder die permanente zurückerobert habe. Hier hilft es, wenn man sich zuerst mal ausgeben lässt, welche Partitionen man benutzt und wie diese heißen: lsblk -o PATH,PTTYPE,PARTTYPE,FSTYPE,PARTTYPENAME. Heutzutage wird das eher in Richtung nvmeXYZ gehen, bei älteren PCs ohne SSDs dann wahrscheinlich sda. Dann noch ein sudo update-grub, was bekannt sein sollte, sowie ein sudo grub-install /dev/sda bzw. ein sudo grub-install /dev/nvmeXYZ danach und dann „Macht’s gut, Redmond!“.

Heute gesehen bei heise.de, ein „Highend-Notebook“ mit „300Hz“ vom Gemüse-Discounter unseres Vertrauens:

Ich musste heftig suchen, in welchem PC-Jahr wir hier wirklich angekommen sind.

Der Z3 von Zuse hatte 4 bis 5 Hz, irgendwann um 1941. Der ENIAC vier Jahre später, 1945, schon wuchtige 5kHz. Also irgendwo dazwischen.

Nur wurden leider keine weiteren Computer „dazwischen“ gebaut. Vielleicht fehlen hier auch Einträge in der westlichen Literatur. Die Technik war in jedem Fall noch zu neu und füllte Hallen, alleine die Z3 wog über eine Tonne.

Mit der Headline habe ich noch ein weiteres riesiges Problem neben der Unvollständigkeit (falls das überhaupt jemandem auffiel): ich gehe hier von der Taktfrequenz eines Prozessors aus und halte das für „normal“. Im Text aber geht es um das Display.

Sind Displays heute wichtiger als CPUs!? Sind CPU-Infos nicht mehr relevant für Technikmagazine?? Und: wer kauft eigentlich PCs bei ALDI!? Hakt’s?

Weihnachten 2017: Kernel-Entwickler arbeiten durch. Neujahr 2018 ebenso. Der Grund: eklatante Hardwarefehler in Computerprozessoren, dem Gehirn unserer PCs. Die Wissenschaftler taufen diese „Meltdown“ und „Spectre“, „Kernschmelze“ und „Schreckgespenst“.

Sommer 2020. Inzwischen sind wir in Monat #32 nach Bekanntwerden dieser Hardwarelücken. Was der aktuelle Stand?

Folgender:

SUMMARY: CVE-2017-5753, CVE-2017-5715, CVE-2017-5754, CVE-2018-3640, CVE-2018-3639, CVE-2018-3615, CVE-2018-3620, CVE-2018-3646, CVE-2018-12126, CVE-2018-12130, CVE-2018-12127, CVE-2019-11091, CVE-2019-11135, CVE-2018-12207

Oben: Zusammenfassung aktueller CPU-Lücken des Tools spectre-meltdown-checker, Stand August 2020

Aus drei Lücken (CVE-2017-5753, CVE-2017-5715, CVE-2017-5754) wurden 14. In Worten: Vierzehn.

Selbst AMD scheint auch 2020 nicht in der Lage zu sein Prozessoren zu bauen, die alle Fehler ausschließen können.

Unterziehe ich meinen neuesten AMD-Prozessor, den 4800HS, einem Test mit dem kostenlosen OpenSource-Tool spectre-meltdown-checker, wird klar, dass besonders ein Bug hardwaretechnisch bisher unmöglich zu beseitigen scheint.

Es ist jener mit den Kennungen CVE-2017-5753 aka ‚Spectre Variant 1, bounds check bypass‘, CVE-2017-5715 aka ‚Spectre Variant 2, branch target injection‘ und CVE-2018-3639 aka ‚Variant 4, speculative store bypass‘, bekannt als „Spectre“, das „Schreckgespenst“.

Ohne die pausenlose Arbeit zum Jahreswechsel 2017/2018 der weltweiten Entwickler-Community, wären selbst AMD-CPUs des Jahres 2020 hier verwundbar. Die gelisteten drei Varianten von Spectre sind ledliglich softwareseitig gepatcht und damit seit über 2,5 Jahren auf keinem aktuelleren Stand als damals.

Mir ist das zu lange. Als Entwickler, wie als Anwender.

Von 14 Hardwarefehlern sind 11 aus der Welt und drei nach wie vor vorhanden. Willkommen in der neuen Realität der 78,57%-PC-Hardware für 100% hardverdientes Geld! Was ein Scheißdreck.

In einer digitalen Welt voll mit kostenlos erhältlichen Datenbanksystemen setzen nur noch IT-Steinzeitmenschen auf reine Tabellenkalkulationen.

Sei’s drum, denn: wer braucht heute noch ein Gehirn!? Richtig!?

Luckysheet möchte selbst kommerziellen Tabellenkalkulationsprogrammen Konkurrenz machen und man muss zugeben, zumindest geschwindigkeitstechnisch und optisch macht es absolut etwas her:

Für eilige Ex-Excel-Junkies lässt sich die Demo auch gleich direkt ausprobieren: https://mengshukeji.github.io/LuckysheetDemo/.

Wer etwas mehr Zeit erübrigen kann, der braucht nur Node.js in Version 6 oder höher und kann das Programm lokal auf dem PC mit nur wenigen Zeilen installieren:

npm install

npm install gulp -g

Luckysheet wird von einer kleinen chinesischen Community entwickelt und basiert auf einer MIT-OpenSource-Lizenz. Vielleicht der einzige Wermutstropfen, doch was ist heutzutage nicht aus China? Richtig!?

Whoa! KDE macht offenbar in Ultrabooks:

Direkt der Slimbook-Website entnommen

Und die Dinger sehen auch noch hardwaretechnisch supersexy aus! Passend zur Desktopumgebung! 🙂

Mit 899€ auch zu einem sehr humanen Preis, wie ich finde: dafür erhält man ein 14“-HD-IPS-LED-Display mit leistungsstarkem AMD Ryzen 4800H-Prozessor (8 Kerne, 16 Threads, integrierte Radeon-Grafikkarte mit 1,43 T(!)FLOPS), der erst im Januar auf der CES öffentlich vorgestellt wurde (hier nochmal der Bericht). Eine bisschen mickrige 250GB-SSD, sowie 8GB RAM ebenso.

Wer will, kann über den Onlineshop das Setup jedoch noch nach Belieben (oder was der eigene Geldbeutel hergibt) aufstocken. Im Kurzbesuch konnte ich bis zu 64GB RAM und eine 2TB Samsung-SSD ohne Probleme finden, siehe: https://slimbook.es/en/store/slimbook-kde/kde-slimbook-14-comprar.

Das Geilste aber ist natürlich: KDE Neon vorinstalliert!

Die auf Debian bzw. Ubuntu LTS basierende Linux-Distribution gilt als bleeding edge und liefert immer das Neueste und Feinste von KDE frei Haus. Und das noch gar nicht lange: sie ist erst vier Jahre alt, wurde 2016 ins Leben gerufen. Aktuell ist sie mit Platz 11 locker in den TOP20 von distrowatch.com zu finden. Sehr populär also.

Wem 14“ zu klein sind, kein Problem: für nur 30€ mehr erhält man das 15“-Modell.

Fazit: hardwaretechnisch und von Betriebssystemseite erste Sahne und wenn die Verarbeitung nur halb so geil ist, wie sie aussieht, für mich ein Anwärter auf das Gadget des Jahres!

Schon extremst geil und wirklich heftigst eye candy plus cyberpunk:

eDEX-UI ist ein Terminalemulator, wie man ihn von PC-Interfaces aus Scifi-Filmen wie „Tron“ und „Alien“ kennt. Er läuft auf allen gängigen Plattformen, Linux bevorzugt, aber auch Mac oder sogar Windows mit wenigen Einschränkungen.

Das Programm aus der Zukunft ist frei hier erhältlich: https://github.com/GitSquared/edex-ui.

Nach der Installation erwartet einen ein Echtzeitmonitor für CPU, RAM, Swap und laufende Prozesse, sowie das Netzwerk. Für Touchscreens liefert er eine entsprechende Tastatur mit, die sich bei Nichtbedarf auch ausblenden lässt. In jedem Interface ist ein Verzeichnis-Browser eingebaut. Und: natürlich enthält er immer auch die entsprechende Konsole zum Arbeiten oder Experimentieren.

Das Customising kann man selbst übernehmen, braucht dafür allerdings das Wiki. Das sind schon erweiterte Konfigurationen, die man hier durchführen muss, nicht jeder kennt sich beispielsweise mit CSS-Injections aus.

Wer möchte, kann sich auch zum Konsolen-Skin entsprechende Sounds einblenden lassen.

Oben zu sehen ist der Skin neofetch mit eDEX-UI 2.2 und dem Standard-„Tron“-Thema. Ein Stückchen weiter unten das Thema „interstellar“ mit den geöffneten Grafikeinstellungen der Applikation.

Fettestes Projekt, absolute Empfehlung! Viel Spaß beim Ausprobieren!