Archiv für die Kategorie „Künstliche Intelligenz“

Man kann von Tesla halten was man will: US-amerikanische Marke; Verarbeitung nicht so gut wie bei deutschen oder japanischen Modellen; Akku brennt; der Gründer ist ein (Cov-)Idiot; Markennamen von einem bedeutenden europäischen Erfinder geklaut; etc. pp. You name it.

Aber eines kann man ihnen nicht vorwerfen: der Wille zur Innovation.

Bei Tesla träumt man Innovationen nicht nur oder zeichnet diese. Sie werden in Realität gesetzt. Und dabei haben sie anderen Firmen auf dem Planeten manches voraus. So z.B. ein fahrbares und nutzbares E-Automobil. Und ein zukunftsfähiges Konzept insgesamt. Ja, wahrscheinlich DAS Zukunftskonzept der Mobilität überhaupt für die nächsten Jahrhunderte. Und das „schon jetzt“.

Deshalb lohnt es sich genau jetzt in Tesla-Aktien zu investieren: durch den Split ging der Preis pro Aktie nämlich fast über Nacht von über 2.200$ runter auf aktuell 360€. Wer also ein paar Hunderter übrig hat, das sollten einige Menschen sein seit März, auch unter meinen Leserinnen und Lesern, der sollte sich (ein Depot eröffnen und) Aktien dieser Firma kaufen. Es ist sehr wahrscheinlich, dass die 1.000€ wieder schnell geknackt sein werden. Dann hätte man alleine durch eine Beteiligung fast das Dreifache wieder drin. Ende ist hier übrigens nach oben offen.

Man kann das Geld schnell mitnehmen oder halten. Ich würde halten. Einfach aus „Prinzip Zukunft“. Und es gibt da noch etwas, was ich bemerkenswert fand, die Meldung ist aber schon ein paar Monate her.

Wie wir alle wissen sind oder waren die Japaner mal das technologisch am weitesten fortgeschrittene Völkchen der Erde. So stark und so mächtig und sehr weit fortgeschritten, sie galten als „Schwan“ und flogen in Gesamtasien voraus, während andere Länder wie Südkorea, sogar Taiwan und China, hinterher wackeln mussten. Irgendwann in den 80ern war das so. Es mag sich mittlerweile gewandelt haben, ich bin auch der Meinung, insgesamt haben wir „alles schon erfunden“, also da wird kaum noch was Neues kommen für die Menschheit. Und das wechselt sich da unten nun munter ab, wer in der Parabel voraus fliegt. Ich tippe ja aktuell auf Südkorea, China braucht noch ein paar Jahre, vielleicht Jahrzehnte. Wobei man Taiwan mit dem Chipfertiger TSMC hier auch nicht vergessen darf.

Ich schweife ein bisschen ab, denn was ich eigentlich erzählen will kann man auch ohne dieses Wissen und die Vogelzug-Parabel faszinierend finden.

Die Japaner haben nämlich vor wenigen Monaten den Tesla Model 3 komplett zerlegt, die Ergebnisse wurden im Februar der Weltöffentlichkeit präsentiert. Denn was machst du als Hacker erst einmal, wenn du neue Technik verstehen willst oder schauen möchtest, ob die Technik wirklich neu ist? Na klar, du baust sie auseinander!

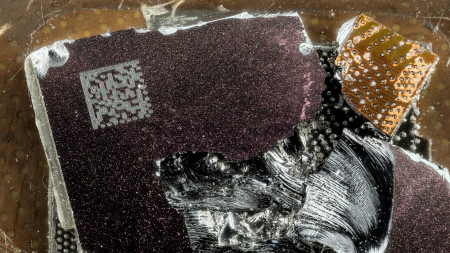

Das Wichtigste und das Unbekannteste, das sie fanden, waren zwei individuell designte KI-Chips, von Tesla komplett selbst entwickelt(!), mit entsprechend inhouse-entwickelter Software:

Oben: der Computer des „Model 3“ – ein KI-Chip regelt das autonome Fahren, der andere das gesamte Infotainment-System

Im Kern fanden die Japaner heraus, „ja gut, das Hardware-Ensemble ist eben dafür gut, dass dieses Auto sich selbst steuern kann und die massive Infotainment-Anlage“. Und das stimmte dann auch. Doch was noch viel bedrückender war aus der Sicht der japanischen Ingenieure:

Die Hardware, die oben zu sehen ist, ist 6 Jahre ihrer Zeit voraus!

Tesla ist damit nicht nur Konkurrenten zeitlich enteilt, Tesla ist mit dieser Hardware einer kompletten Industrie enteilt.

„But technological hurdles are not the reason for the delay, according to the Japanese engineer who said „we cannot do it.““

Einer Industrie, die in Europa alleine 3,65 Millionen Menschen beschäftigt – bei Tesla arbeiten aktuell nur 48.000 (Stand 2019)…

Das ist „Alien-Sh*t“, was wir hier sehen. Solche Technik dürfte es aktuell gar nicht geben.

2019 nicht.

Dieses Jahr nicht.

Nächstes Jahr nicht.

2022 nicht.

2023 nicht.

2024 leider auch nicht.

Maximal „irgendwann 2025“, sagen Industrie-Insider. Denn auch wenn der Bericht Ende Februar publik wurde, auseinandergenommen wurde der Tesla wohl irgendwann Ende 2019.

Ganz ehrlich: WAS haben die da gebaut!? und WIE!? Ich bin kein reiner Ingenieur, aber ein kleiner CPU-Head. Vor solch einer Leistung habe ich irre Respekt. Und leider auch Angst.

Und sehen wir es realistisch, selbst wenn sie mit Autos als Konzept komplett sich zerlegen würden, sie hätten immer noch diese Chips, also konkrete Hardware, sowie maßgeschneiderte Software dazu im Angebot. Mir würden spontan mindestens ein Dutzend Anwendungsfälle dazu einfallen, „I, Robot“ wäre Kindergeburtstag dagegen.

Der hier und seine KollegInnen lauschen pro Tag bis zu 19(!) mal „zufällig“ in Gespräche rein:

Meldungen über zuhörende „smart speaker“ gab es in den letzten Jahren so einige, genauere Untersuchungen oder gar wissenschaftliche Studien dazu eher weniger.

Mittlerweile hat sich das geändert und auch die Untersuchungen laufen sogar noch weiter, siehe: https://moniotrlab.ccis.neu.edu/smart-speakers-study/, Universität Boston NE. [via]

Kam heraus: im Schnitt lauschen „smarte Lautsprecher“ wie Alexa, Google Home & Co. satte 19-mal „zufällig“ pro Tag in die Gespräche rein. o.O

Für die Versuche wurden alle Geräte in eine kleine Box geschlossen und satte 125 Stunden mit Streaming-TV-Audio vollgepumpt. Gemessen wurde dann, wann die Devices aktiv werden, im Techsprech „aufwachen“. Das kam bis zu 19-mal innerhalb eines 24-Stunden-Zyklus vor. Am schlimmsten am Lauschen waren die Geräte von Apple und Microsoft in den Tests. Für den letztgenannten Hersteller und Amazon gab es auch die längste „zufällige“ Aufnahme, satte 43 Sekunden am Stück.

Spannend werden die zukünftigen Untersuchungen der Inhalte in die jeweiligen Hersteller-Clouds: hier will man zum einen wissen, welche das genau sind. Und zum anderen, ob diese vorurteilsbehaftet sind, also Unterschiede aufweisen bezüglich Geschlecht, Ethnie oder Akzent.

Ferner ist bisher nicht bekannt, ob die „Smart Speaker“ aus ihren Fehlern lernen, also über irgendeine Form von künstlicher Intelligenz verfügen. Wobei man sich bei machine learning, was hier Anwendung finden würde, auch bis heute streitet, ob man hier überhaupt KI am Werk sieht. Auch hier werden die Ergebnisse mit Spannung erwartet.

Talking about „smart“, eh!?

Es gibt Todesfälle von Künstlern, die will man nicht (wahr) haben.

Einfach, weil es absolute Ausnahmetalente ihres Fachs waren.

Oder weil sie einen selbst geprägt haben wie kaum weitere.

Für mich war Syd Mead beides.

Ein Genie, der „meine“ Cyberpunk-Welten so visualisieren konnte, wie ich sie am liebsten hatte: realistisch, düster, farbenfroh & kraftvoll.

Schnappschuss von heute, 3.2.20, der offiziellen Website sydmead.com.

Syd Mead verstarb bereits am 30. Dezember 2019 im Alter von 86 Jahren. Seine letzten Worte sollen gewesen sein: „Ich bin hier fertig. Sie kommen und holen mich zurück.“

Syd, wherever you went, farewell! You’ll surely be missed! Thanks for your patience in creating those worlds. And also for your courage in publishing those. I don’t think your place will be replaced easily. Requiescat In Pace, dear old cyberpunk friend!

Empfohlene Links:

http://sydmead.com/ – offizielle Website

„The Movie Art of Syd Mead: Visual Futurist“ (Englisch) – Gebundenes Buch, 28,99€, amazon.de

Meldung des Todes von Syd Maed – über dezeen.com, 02.01.20

„In Memory of Syd Mead: The Grandfather of Concept Design“ – via artstation.com

„The Art of Syd Mead“, via iamag.co

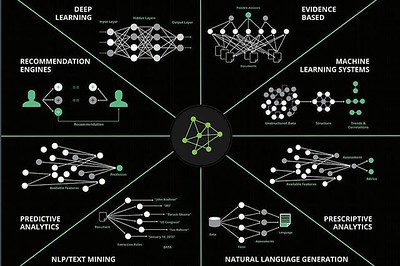

(Oben: Forschungsbereiche der künstlichen Intelligenz, CC0 Paula Piccard)

Den Spezifikationen nach hat man bei der KI-Text-Software GPT-2 alles richtig gemacht:

* 1,5 Milliarden Parameter

* Datensatz von 8 Millionen Webseiten als Grundlage

* einfach gestecktes Ziel: Vorhersage des nächsten Worts in einem 40GB-großen Internet-Text

Entstanden ist so „das Modell einer unbeaufsichtigten Sprache, das allgemeinverständliche Textpassagen mit einer guten Performanz und einem rudimentären Leseverständnis, sowie Maschinenübersetzung, Fragestellung und Zusammenfassung“ (Quelle: https://openai.com/blog/better-language-models/) in sich vereint.

Als wissenschaftlicher Mitarbeiter des Planeten Erde ein „Hut ab!“ von mir und Respekt, dass es im Jahr 2019 solch eine Software gibt! Das war eine News im Februar.

Daraus entstanden ist ein regelrechter „Shitstorm“. Denn paranoide Zeitgenossen und Skeptiker witterten darin „ein bereits einsetzbares Programm zur Verbreitung von Fake News, Spam und Desinformation“ (via).

Mittlerweile haben sich die Gemüter wohl beruhigt. Und OpenAI, ein gerade mal vier Jährchen junges Startup aus San Francisco, war die Sache dann zu blöd, die haben die Vollversion der Software letzte Woche kurzerhand öffentlich gemacht.

Von nun an sollten wir alle in der Lage sein, theoretisch, z.B. durch die Eingabe einer beliebigen Überschrift, uns einen entsprechend sinnvollen Text generieren zu lassen. Oder umgekehrt. Und noch viel mehr.

Um zu verstehen, wie das System funktioniert, muss man der englischen Sprache mächtig sein und kann dann mal live hier ausprobieren, worum es geht:

https://talktotransformer.com/.

Einziger Wermutstropfen: die Dropdown ist bereits vorausgefüllt. Trotzdem: nettes Web-Gimmick mit Potenzial!

„The Verge“ hat in einem entsprechenden Artikel natürlich allerlei Nachteile entdeckt: die Verwendung von Namen durchgängig im Text sei nicht kohärent; das System bleibe in einem Nachrichtenartikel nicht beim Thema; solche Sachen. Doch ganz ehrlich: das machen Menschen auch und irgendwo kamen ja auch die Millionen Texte her. Das kann durchaus auch erlernt sein, bleibt aber natürlich Spekulation.

„The Verge“ war auch eines von vielen US-Onlinemedien, denen gar nicht so wirklich wichtig war, was hier genau Revolutionäres passiert. Viele Passagen im Artikel dort widmen sich einer laufenden US-Debatte, ob KI-Forscher Schaden anrichten oder nicht und ob denen das bewusst ist. Ich will da auch nicht weiter darauf eingehen, weil da sind auch wieder so hässliche Themen dabei. Kurzes Fazit: in ~95% der Fälle wissen die OpenAI-Mitarbeiter wohl selbst, ob ein Text ein GPT-2-erstellter ist.

Für mich hingegen ist eigentlich nur wichtig: wann geht denn jetzt Eliza Cassan endlich auf Sendung in meiner Glotze!?

Im Alter von 75 Jahren ist der niederländische Schauspieler, und eine _der_ „Blade Runner“-Kultfiguren, Rutger Hauer, diese Woche verstorben.

[via]

Wer mich persönlich kennt, der weiß um meine starken Prägungen als Cyperpunk durch den Kultfilm aus meinem Geburtsjahr 1982, sowie durch das Videospiel 1997. Vieles von dem, was dieses filmische Spektakel erst zu einem Kultfilm gemacht hat, wäre ohne Rutger Hauer gar nicht möglich gewesen.

Oben: Rutger Hauer 2007 bei einem Workshop in Rotterdam

Ein Beispiel ist der Monolog, den die Filmfigur und Replikant Roy Batty zum Schluss hält. Den hat Hauer nämlich einfach selbst umgeschrieben und in dieser Perfektion der Figur in den Mund gelegt:

„Ich habe Dinge gesehen, die ihr Menschen niemals glauben würdet. Gigantische Schiffe, die brannten, draußen vor der Schulter des Orion. Ich sah C-Beams, glitzernd im Dunkeln nahe dem Tannhäuser Tor. All diese Momente werden verloren sein in der Zeit, so wie Tränen im Regen. Zeit … zu sterben…“

Zeitlose filmische Momente, die einen legendären von einem gewöhnlichen Film unterscheiden.

Mit seinem Tod verliert nicht nur Hollywood sondern auch das europäische Kino einen wahren Charakter, den es so kein zweites Mal mehr geben wird.

Ich verneige mich, natürlich virtuell, wie es sich für einen echten Cyberpunk gehört, und verabschiede mich mit den folgenden Worten:

Requiescat In Pace, Rutger Hauer (1944-2019)!

„Das Licht, das doppelt so hell brennt, brennt eben nur halb so lang, und du hast für kurze Zeit unglaublich hell gebrannt, Roy.“

(Oben: Image from page 269 of „A treatise on the diseases of the eye“ (1883), CC0, via)

Von (a)sozialen Medien sind die Nutzer es mittlerweile gewohnt, dass dort eingestellte Bilder & Photos zu Marketingzwecken ausgeschlachtet und missbraucht werden. In die selbe Kerbe schlägt auch, was IBM mit selbigen über die Foto-Community flickr.com machte, um seine KI (künstliche Intelligenz) zu trainieren:

„IBM hat fast eine Million Fotos von Flickr verwendet, um eine Gesichtserkennung zu trainieren. Die betroffenen Nutzer hatten dem jedoch nie explizit zugestimmt.“

[via]

Die Vergangenheit, so scheint es, lässt auch „Big Blue“ nicht in Ruhe. Das ist tatsächlich creepy wie zu nationalsozialistischen Hochzeiten.

Mal schauen, ob die knapp 30 Milliarden Euro teure Übernahme des FOSS-Produzenten „Red Hat Linux“ letztes Jahr hier helfen kann. Die Hoffnung stirbt ja bekanntlich zuletzt. Schlimmer geht ja nimmer. Oder? Oder!??

Was DER Untergang werden wird für alle korrupten AnwältInnen, ImmobilienmaklerInnen, RichterInnen, etc., verschiebt sich updatetechnisch immer weiter nach hinten:

Zwar lässt sich das was sich von dem Hackerkollektiv um das russische IT-Genie Vitalik Buterin losgetretene Projekt wurde nicht mehr rückgängig machen, doch alleine hier Updates fahren zu können kostet ungemein Kraft, Zeit & wahrscheinlich auch Geld.

Anders lässt sich wohl die wochenlange Verzögerung hier, leider, nicht erklären.

Der aktuellen Status des durchgeführten Updates lässt sich hier abrufen:

Was sich schon auf den 27. Februar unnötig verschob, ist nun weiter zurück auf den 28. datiert worden. Nicht gut.

Wie hart es sein muss, Ethereum technologisch Gefallen zu tun, sah die IT-Welt bereits Ende 2016, als das Startup DAO grandios scheiterte (oder sollte man besser sagen: scheiternd gemacht wurde!?).

In jedem Falle.

Das Update wird ja weiter durchgeführt. Also kann es sich „nur“ um Wochen (oder Monate) handeln, bis die Smart-Contract-Plattform final geupdatet wurde.

So isch dem IT!

Das komplizierteste von Menschenhand gemachte Berufsfeld. Period.

P.S.: Constantinople ist kein „Fork“ von Ethereum, wie es permanent von inkompetenten Massenmedien im Internet behauptet wird, sondern lediglich ein Update(!).

Die DFG-VK legt sich gerne mit der Frankfurter Videospielschmiede „Crytek“ an.

Aus aktuellem Anlass, zu lesen im „ZivilCourage“-Heft 6/2018, gebe ich daher gerne das entsprechende, aufbereitete YouTube-Video weiter:

Die Analyse des Gegenschlags der DFG-VK läuft noch, das Video ist bereits aus 2017.

Wie man im oben erwähnten Heft nachlesen konnte war die Aktion sehr effizient, kostete nur 1.500€ und war auch an Kreativität kaum zu überbieten.

Man würde sich wünschen mehr solcher Aktionen zu sehen. Vielleicht nicht unbedingt gegen Videospielentwickler aus deutschen Landen, leider gibt es bei uns nicht sehr viele dieses Kalibers…

Willkommen in 2019, einem weiteren Jahr geistiger Gehirnbehinderung! <3

Auf elektronischem Wege, zumindest.

Obwohl Winter ist wird in der deutchen Nachbarschaft gesägt, gehämmert, Bäume gefällt & Flüssigkristallerzeugnisse geleckt und massiert.

Ich weiß ja nicht, was hier los ist, doch der „technisch weit entwickelte Deutsche“ verträgt auch im ersten Jahr nach dem dümmsten Sommer aller Zeiten leider keine Weiterentwicklung -.- Willkommen im „Digitalneuland!“ TOTAL FTW!

Naja, machen wir uns nichts draus.

Es gibt Androiden, kaputte CPUs, vom Himmel fallende Satelliten zum Ausschlachten und Plattenspieler von Vestax zuhauf.

Frohes Neues Jahr 2019 wünscht gizmeo.eu! Auf unsere liebe Gehirnglotze! ^^

Computer lassen sich nicht verarschen. Kunden lassen sich verarschen.

Die wohl erfolgreichste CPU-Serie aller Zeiten ist die „(Core) i“-Serie von Intel, basierend auf der sogenannten „Nehalem“-CPU-Mikroarchitektur, die die bekannten „Core“-CPUs irgendwann 2010 ablöste.

Ab „i“ passierte etwas ganz Merkwürdiges: Intel versuchte PCs zu verarschen und verkaufte Prozessoren mit nur zwei Kernen, die aber dem Betriebssystem hintenrum vorgaukelten, diese haben vier. Dieses Konzept nannte man im Marketing-Sprech „Hyperthreading“ und es war ein gigantischer kommerzieller Erfolg.

(Defekte Intel-CPU, CC0 Fritzchens Fritz via Flickr)

IT-Experten ist so ein Blödsinn nie zu verkaufen gewesen: wieso sollte ich eine CPU als Quad-Core ansehen, wenn real nur zwei Cores verbaut sind? Was schlägt die Realität hier, Fakten oder Marketing? Die Antwort kann sich jeder selbst geben.

CPU-Design, sowie Herstellung und Verkauf ist ein gigantisches Geschäft. Allerwelts-Ware, die in Massen hergestellt wird, die man sich nicht mehr vorstellen kann und die Unmengen an Ressourcen verschwendet, menschliche wie natürliche. Tatsächlich hat es diese harte Industrie geschafft Prozessoren zu entwickeln, die heute nicht mehr schon nach zwei, sondern erst nach sieben Jahren (oder noch mehr, wenn man Linux nutzt) im Schnitt ausgetauscht werden müssen, weil sich Software so rasant weiterentwickelt, dass keine Hardware länger mithalten kann. Eigentlich ist das ganz gut so. Doch diese Entwicklung hatte einen verdammt hohen Preis.

Die US-amerikanische Mentalität schlägt sich auch auf CPU-Design nieder. Ohne irrsinnig viele US-amerikanische Dollars wird sich kein Hersteller auf dem weltweiten CPU-Markt durchsetzen können. Das hat zu einem gefährlichen Oligopol im CPU-Bereich geführt, wo mittlerweile lediglich drei Hersteller ihre Kämpfe austragen: Intel, AMD und ARM. Selbst „Big Blue“, also IBM, einst eine CPU-Koryphäe und Vorreiter brachial guter und mächtiger CPU-Konzepte, mischt auf diesem Markt nicht mehr mit. Fragt euch mal wieso.

Dieser Markt ist scheiße wahnsinnig, er bringt die düstersten IT-Blüten hervor, es geht überhaupt nicht mehr um Fortschritt oder möglichst viele Konzepte in dem Bereich. Es geht nur noch darum, wie man dem „dummen Konsumenten“ möglichst im Monatstakt eine neuere Version der CPU, die sie/er bereits hat, andrehen kann. Man geht über Leichen dafür, im In- und Ausland. Man spart stolz an der Sicherheit, das wichtigste Kriterium, für nur noch ein Hauptaugenmerk: Speed. Speed. Und nochmal Speed. Koste es was es wolle.

Genau hier kommt „Hyperthreading“ ins Spiel. Die allergrößte und schäbigste Verarsche, seit es CPUs gibt.

Ich spare mir hier wie „Hyperthreading“ genau funktioniert, der Wikipedia-Eintrag ist oben auch bereits verlinkt, doch dieses Konzept, diese gequirlte Werbescheiße aus dem Hause Intel, hat direkt in die CPU-Apokalypse geführt, die vorerst im Januar in „Meltdown“ und „Spectre“ gipfelte.

„Hyperthreading“ ist das Eingeständnis und die Kapitulation gleichermaßen, sich einen Dreck um den wirklichen Fortschritt von Computer-Prozessoren zu scheren getreu nach dem Motto: „wir können zwar derzeit keine Quadcores oder Octacores bauen, weil alles viel zu teuer und würde viel zu lange dauern, wir bauen lieber einen Wrapper(!) und lügen dem Konsumenten ins Gesicht, merkt keine Sau!“

Und bei Intel im sonnigen Santa Clara regnete es ab diesem Zeitpunkt Dollars vom Himmel.

Von einem technischen Standpunkt aus gesehen ist das unter aller Sau.

Es ist shady, durch und durch. Und dürfte von keinem CPU-Hersteller propagiert werden, der seriös in diesem Zukunftsfeld aktiv ist.

Intel hat aber genau das gemacht. Und sie wollten einfach. Nicht. Stoppen.

Mit „Hyperthreading“ startete ein komplett neues Paradigma, es war mehr als eine Idee, und dieses Paradigma bricht CPU-Käufern seit Januar weltweit Genicke und bereitet Betriebssystemherstellern Kopfzerbrechen: OoOE. Out-of-Order-Execution.

Mit OoOE war es endgültig vorbei mit der wahrheitsgemäßen Abarbeitung von Programm-Code.

Die Spekulation wurde hoffähig und verkaufbar gemacht: die CPU „spekuliert“, welche Anweisung als Nächstes kommt, sie ist sich nicht mehr 100% sicher. Man pfeift auf die Sicherheit und holt ein paar Prozentpunkte mehr Speed. Alles wie gehabt. Es war klar, dass dieser grandiose Marketing-Schachzug, der kein technischer war, nur aus einem Hause so konsequent durchgepeitscht werden konnte.

Und das bei dem wichtigsten Hardware-Bauteil unserer Zeit: dem Gehirn der Maschine.

Bei all der panischen (und dennoch gerechtfertigten) Berichterstattung zu „Meltdown“ und „Spectre“ kommt mir immer eine Frage zu kurz: wie ändern wir das jetzt? Wie macht man diesen kapitalen Fehler rückgängig und vertraut doch wieder dem Von-Neumann-Zyklus, kehrt zurück zur klassischen IOE? Die Antwort ist auch leider hier sehr unbefriedigend: wahrscheinlich gar nicht mehr. Weil es schlicht mehr geht.

Für alle, die dennoch ebenso diese Frage interessiert und umtreibt, dem sei folgende Web-Diskussion empfohlen, die seit vor schon fünf Monaten zumeist sachlich geführt wurde: https://news.ycombinator.com/item?id=16070465. Die Ausdauer und der Informationsgehalt verdienen großes Lob, leider ist das zumindest was ich fand textlich und online im letzten halben Jahr, dann auch schon alles gewesen. Und es wurde auch schon lange gar nicht mehr aktualisiert.

Ich persönlich denke, CPUs sind „fertig designt“ und das schon seit Jahrzehnten(!). Echte Quadcores und Octacores und WeißIchsWieVieleCPUsAufEinemDie wären sowieso gekommen. Was Intel hier gemacht hat ist schon wieder so typisch für Intel. Man kann sie zu Recht hassen und verabscheuen dafür. Das bringen wirklich nur die hin. Das ist Wahnsinn. Und eine Lüge gewesen von Beginn an.

Diesen Gehirnschmalz, diese Expertise im Bereich des Verkaufs hätten sie lieber in die wirkliche Entwicklung, den wirklichen technischen Fortschritt von CPUs gesteckt. Doch um so etwas ging es Intel nie.

Intel ist mal wieder so eines der perfektesten Beispiele für unsere Zeit: „was kümmert mich die Substanz, ich will die optisch geilste Bitch auf dem Fotzenmarkt und werde diese mit Dollars zuscheißen, bis sie erstickt, die drecksgeile Sau!“ Gerne könnt ihr mir hier jetzt bitte seitenweise versuchen zu erklären, was das mit Computern zu tun haben soll.

BNW.

Es fühlt sich an wie vor 100 Jahren, doch es war vor „erst“ elf: damals geisterte ein fürchterlicher Marketing-Kackrotz durch den Cyberspace, der sich „Web 2.0“ schimpfte. Unter diesem Schlüsselwort (würde heute „trendig“ #hashtag heißen) sammelten die weltweiten Granden der Inkompetenz & Inkontinenz jene Web-Phänomene, mit denen sie nicht gerechnet hatten in den 90ern des vorherigen Jahrhunderts. Dazu konnten aber schon CSS-Hacks gehören, Webseiten auf Flash(!)-Basis, manchmal auch MySpace/Facebook(!) oder sogar Blogs.

Im Kern war alles Schwachsinn.

Den Begriff gab es eine ganze Weile, sogar „Web 3.0“ kam irgendwann, doch richtig Fahrt aufnehmen konnte das nicht mehr.

Jetzt, mit der Blockchain, passiert aber etwas „Merkwürdiges“, was zwar seit dem NSA-Skandal 2014 vielleicht vorhersehbar war, jedoch nicht 2009 zum Beispiel, als Bitcoin an den Start ging: das Internet steht nämlich technologisch vor der Ablösung.

Die Zeiten sind endgültig vorbei, seit Jahren schon, wo wir munter „frei“ über http Webseiten in die Welt setzen konnten. Ohne https läuft nichts mehr. Es setzt sich, langsam, wie das eben so ist mit tiefgehenden Veränderungsprozessen, durch, dass wir einander bei elektronischen Medien nicht mehr trauen können, nicht mehr trauen sollten. Nicht nur in Bezug auf das Übertragungsprotokoll aus den 90ern.

Hier kommt jetzt die Blockchain-Technologie ins Spiel, deren Credo von Anfang an lautete: „traue Niemandem!“ („Trust. No. One.“)

Man kann diese als Zahlungsmitteltechnologie einsetzen, wie bei Bitcoin geschehen. Man kann sie aber auch wie z.B. bei Ethereum oder NEO als „Betriebssystem“ einsetzen, um Apps (hießen früher mal „Programme“) darauf aufzubauen, die die Menschheit so noch nicht gesehen hat. Und alles, was man darauf kommuniziert, festlegt, abwickelt, etc., wird verschlüsselt und nie mehr änderbar in einer Blockchain abgelegt.

Als junges Beispiel nehme ich hier mal schnell Japan, die bald wirklich verschlüsselt chatten dürfen: https://the-blockchain-journal.com/2018/04/04/line-japans-largest-chat-platform-is-working-with-blockchain/. Ist ja jetzt nur ein Echtleben-Anwendungsbeispiel.

Die Zeiten für Facebook, WhatsApp, Instagram, Twitter; Vergangenheit! End-lich! Danke, Blockchain! <3 Was halt noch fehlt ist die Interkonnektivität zwischen den verschiedenen Blockchain-Systemen. Aus der Historie des Internet könnte, müsste ja faktisch, eine Art, Achtung, Neologismus, Interblockchain, entstehen.

Bis es so weit ist lassen wir das US-Heimatschutzministerium, Apple und Mark Zuckerberg eben Nackt-Selfies von Minderjährigen in ihren unsicheren Clouds speichern und unsere Bank- und Kommunikationsdaten mitsniffen. Schließlich hat sich darauf die Gesellschaft längst geeinigt, sie wird schon nicht daneben liegen.

Nick Bostrom.

Philosophische Fakultät Oxford.

„Technology Review“, 04/2018.

Mindestens eine der folgenden Hypothesen muss zu 100% wahr sein:

1) „Eine reife Zivilisation muss nur einen winzigen Bruchteil ihrer Computer-Ressourcen einsetzen, um viele Billionen menschliche Gehirne zu simulieren.“

2) „Alle Zivilisationen auf unserem derzeitigen technischen Stand der Entwicklung sterben aus, bevor sie technologisch ausgereift sind.“

3) „Technologisch reife Zivilisationen haben kein Interesse an Ahnensimulationen.“

You decide.

Nur eine letzte Frage stellt sich mir hier: wie lauten die Cheat-Codes!?

Wer 2016 schon schrecklich fand, der bekam 2017 ein Lehrstück über sehr dunkle Stunden der Menschheit. Wenn es außerirdisches Leben gibt, wovon ich in unserem Universum nicht ausgehe, muss es denken, wir waren nie ekliger, dümmer, skrupelloser & verwirrter.

Da waren beispielsweise apokalyptische Geschichten über künstliche Intelligenz von Leuten, die zwar groß waren im Paranoia-Verbreiten, aber kaum Ahnung von der Materie hatten. Es passte perfekt in die Zeit und war eines der Leitthemen des Jahres aus technologischer Sicht.

Ich komme so ein bisschen aus der Schiene und programmiere selbst hobbymäßig damit und kann euch bestätigen, es gibt hier rein gar nichts, das man fürchten muss. PCs sind keine Gehirne, nie gewesen und werden es nie sein. Wer ein bisschen tiefer stochern möchte, der/dem sei wie immer die Tiefe & Schärfe von href.ninja empfohlen.

Dass KI auch positiv sein kann und es eigentlich auch ist, sah man jüngst bei der Entdeckung des Sonnensystems um Kepler 90i: die NASA fand hier zusammen mit Google ein fremdes Planetensystem, das ebenso viele Planeten besitzt wie unseres. Wie geil (und zufällig) ist das bitte!?

Es ist zu finden im Sternbild Draco und 2.500 Lichtjahre von der Erde entfernt. Der untersuchte Planet, Kepler 90i, ist zwar der kleinste der acht entdeckten, aber immer noch 30% größer als unsere Erde. Die Temperatur dort beträgt 420 Grad Celsius.

Der NASA brachte der Start des Weltraumteleskops Kepler 2009 zu wenig, denn wie bei Big Data üblich ist die US-Weltraumbehörde erstickt im gesammelten Datenwust. Um diesen zu bewältigen wandten sie sich dort an die Experten aus diesem Bereich, Google. Die stellten ein Team, das mit Hilfe eines vorher trainierten neuronalen Netzwerks gelernt hatte, wie ein Signal eines weit entfernten Planeten auszusehen hatte. [via] Nur 670 Sterne und deren vorbeidriftende Planeten wurden dafür untersucht. Doch immerhin: das Ergebnis war eine populäre Nachrichtenmeldung, es gibt von uns ein Zwillings-Sonnensystem irgendwo! Nice one!

Mit dieser positiven Grundstimmung entlasse ich euch, liebe Leserinnen & Leser dieses kleinen feinen Online-Technik-Magazin-Gedönsens in die Festtage. Erholt euch gut und schaltet mal ab. Und nicht vergessen: es gibt ein Leben außerhalb von Maschinen!

„None but ourselves can free our minds“

2017 war für Kryptowährungen wohl das verrückteste Jahr. Alleine die älteste Währung, Bitcoin, verteuerte sich innerhalb von nur einem Jahr um das Zehnfache: im Oktober 2016 konnte man eine digitale Münze noch für 500 Euro ergattern.

Steigt der Bitcoin, steigen auch alle anderen Kryptowährungen, die auf dem SHA-256-Algorithmus aufbauen, die sogenannten Altcoins. Auch für die war es ein sehr erfolgreiches Jahr. Vielleicht wird man in 20 Jahren auf 2017 zurückblicken und sagen, Kryptos sind damals erwachsen geworden.

Was ich in diesem Beitrag zeigen will ist, welche Kryptowährungen man bereits heute zu den wertvollsten zählen kann. Dabei wird alleine der Wert eines einzigen Tokens betrachtet. Für eine erste Auflistung möchte ich die Kryptowährungen zeigen, die den Wert von 100€ erreicht oder bereits um ein Vielfaches überstiegen haben. Here we go:

—

1. Bitcoin, 4844€

„Die Mutter aller Kryptowährungen“ taugt im Jahr 2017 kaum noch als Zahlungsmittel. Wer beispielsweise im August Bitcoin im Wert von 1€ transferieren wollte, zahlte dafür bereits 2€ Transaktionsgebühr. Das macht Bitcoin als reines alternatives Zahlungsmittel heute unattraktiv.

Als „digitales Gold“ lässt sich die Währung allerdings nach wie vor betrachten. Durch Brexit und Trump-Wahnsinn wird der Wert weiter steigen. Im Gespräch sind locker fünfstellige Beträge. Ein Ende nicht absehbar. Das macht die Währung, neben ihrem attraktiven Charakter als Geldanlage, aber weiterhin zu einer Waffe gegen die Wirtschaft allgemein. Da können Mega-Banken wie J.P. Morgan Chase noch so Stimmung dagegen machen. Der wahre Feind von Bitcoin wurde schon von Beginn an tief in die DNS der Kryptowährung eingraviert. Das lässt sich, zum Glück, weder ändern noch rückgängig machen.

Ferner sind digitale Bitcoin-Münzen nach wie vor mit speziellen Minern, ASIC-Maschinen, weiterhin selbst produzierbar. Das ist zwar nicht wirtschaftlich und verbraucht viel zu viel Strom (Bsp.: eine 1,1TH-Maschine mit einem 590-Watt-Netzteil kostet pro Monat 119€ Stromkosten bei einem Preis von 0,28€/KWh. Wertverlust/Monat alleine durch Stromkosten: 84€), doch es ist ein cooles und attraktives Hobby und macht auch Spaß. Ferner stützt jeder kleine Miner das Bitcoin-Netzwerk allgemein.

2. Ethereum, 261€

Ethereum gehört mit zur „Champions League“ der Kryptowährungen. Das von Vitalik Buterin gestartete Projekt bietet mit Solidity eine eigene Programmiersprache. Außerdem ist Ethereum im Gegensatz zu Bitcoin turing-complete; allerdings ist weit und breit kein PC zu sehen, der nur auf Ethereum basiert. Das wäre hier nämlich möglich. Und auch wahrscheinlich _die_ Killer-Applikation.

Der Code wird derzeit weiterentwickelt und ein neuer Haupt-Release wartet auch. Mit smart contracts glänzt das System mit einer Art programmierbarem Vertrag als App, die fälschungssicher und ohne Mittelsmann-Schicht funktioniert. Doch auch hier gab es bisher keinen „Killer-Smart-Contract“. Das vielversprechende Projekt The DAO scheiterte letztes Jahr im Oktober komplett, daraus entstand das kontroverse Ethereum Classic. In der Krypto-Szene wird diese Währung wie Bitcoin Cash auch als dreistes Plagiat und Betrug gewertet.

3. Dash, 248€

Dash, auch „Digital Cash“, wird als Anwärter auf den Thron der Kryptos gesehen, die es als erste schafft eine DAO, also eine Dezentrale Autonome Organisation erfolgreich aufrecht zu erhalten. Die Anzahl Apps ist derzeit überschaubar und wenig attraktiv, was hier lockt ist zum einen das selbstständige Betreiben einer „Masternode“ (die jedoch teuer ist), wodurch man massive Stimmrechte erhält. Und zum anderen verfügt Dash über ein IO-System, das es schafft Monat für Monat sein Budget selbstständig(!) zu steigern, wodurch neue Projekte und neue Entwickler finanziert werden können. So etwas gab es meines Wissens noch nicht.

4. Zcash, 196€

Um Zcash rankt sich die eine oder andere Verschwörungstheorie. Im Kern ist es einfach eine Kopie von Bitcoin, selbst die Anzahl von 21 Millionen Tokens ist die selbe. Niemand weiß genau, zu was es gut sein soll. Es gibt Gerüchte, es sei von gewissen Regierungen gesponsert. Was niemanden in der Szene wirklich wundern würde.

5. Byteball Bytes, 177€

Ganz ehrlich: keine Ahnung. Auf Wikipedia in englischer Sprache keinerlei Einträge. Byteball Bytes will ein „smartes Bezahlsystem“ sein. Leider ist das nicht wirklich innovativ. Um die Popularität zu steigern werden immer mal wieder Events organisiert, zuletzt im August, wo Tokens für die verschenkt werden, die Bitcoin-Adressen bereitstellen. Das könnte auch mal nach hinten losgehen für Bitcoin-Fans. Ich persönlich kann mir nicht erklären, wieso der Wert hier so hoch angesetzt ist, zumal man die Währung _nicht_ minen kann. Der Community-Gedanke existiert hier also überhaupt nicht. Vielleicht ist der Mangel ein Phänomen hier: insgesamt sind nicht einmal 600.000 Tokens im Umlauf. Viele finden schon alleine diese Vorstellung attraktiv.

6. BitConnect, 172€

Den Abschluss der Liste macht BitConnect, ein seit Februar 2016 existiertendes „High-yield Investment Program“. Diese Programme sind organisierte Ponzi-Schemes und ergo: schlicht Betrug. Ich würde jedem davon abraten hier zu investieren. Insgesamt gibt es 28 Millionen Einheiten, 7,2 Millionen befinden sich aktuell im Umlauf. BitConnect ist ein sehr gutes Beispiel, dass wir in Bezug auf Kryptowährungen bis auf ein paar Ausnahmen auch noch sehr am Anfang stehen: hätten Leute Ahnung, oder einfach Erfahrung, wäre der Wert nicht so hoch und das Interesse gleich Null. Man soll es aber minen können, also immerhin dachte man bei der Entwicklung doch an eine Community. Wo es genau herkommt, Regierung oder Individuum, weiß selbst die Wikipedia nicht.

—

Dahinter warten vielversprechende Währungen und neue Technologien, etwa Monero (derzeit 76€), Litecoin (derzeit bei 51€) oder der nagelneue China-Krypto Neo (25€). Die drei möchte ich listen, da ich diese als besonders sicher und potenziell attraktiv ansehe. Wie immer helfen so subjektive Eindrücke meist nichts, wenn man selbst investieren will: die intensiven Recherchen wird euch niemand abnehmen können…

Man darf gespannt sein, wo die Reise hingeht. 2018 will ich erneut so eine Liste machen. Und nach meinem heutigen Wissensstand dürften Bitcoin und Ethereum die einzigen sicheren Vertreter sein. Für die anderen, ganz ehrlich, das klingt alles irgendwie cool und neu und so; doch bei etwas genauerer Betrachtung sind die einfach nur Unsinn.

Im Kern, die Menschen versuchen gerade gemeinsam eines der Hauptprobleme der Menschheit zu lösen. Und: es wurde ein nagelneues Medium zum Speichern und Austausch von Werten statt Informationen geschaffen, die Blockchain. Das ist schon aller Ehren wert, was hier passiert. Ob das Experiment gelingt? Es steht in den Sternen. Wie das bei Experimenten eben immer ist.

Quellen:

* Werte von Coinmarketcap.com, Stand 20.10.17

* Icons von Cryptocompare.com

Gestatten, Sophia:

Quelle: UN Photo/Manuel Elias

Sophia ist eine Androidin entwickelt von Hanson Robotics, 18 Monate jung, die jüngst bei einer Rede im UN-Hauptquartier in New York zum Thema „The Future of Everything – Sustainable Development in the Age of Rapid Technological Change“ – zu dt.: „Die Zukunft von allem – Nachhaltige Entwicklung im Zeitalter des rapiden technologischen Wandels“ teilnehmen durfte. [via]

Sophia wurde laut ihrem Schöpfer David Hanson so entwickelt, dass ihr Design dem Knüpfen von Beziehungen dient. Das mache sie laut Hersteller zu einem social robot. Anwendungsbereiche von Sophia sollen dann Bildung, Fabrikarbeit(?), Rettungsaktionen sein. Das ist schon sehr nah an dem, was uns seit den 80ern in Filmen wie „Blade Runner“ erzählt wird.

Die Realität denke ich, wird anders aussehen.

Porno war schon immer der treibende Motor, der neuartigen Technologien zum Durchbruch verholfen hat. Prominente Beispiele sind VHS und das Internet. Ein Schöpfer, der nichts Gutes für seine Kreationen will, wäre kein menschlicher Schöpfer. Leider ist die Gier oft der Motor aller menschlicher Handlungen. Das weiß sicher auch ein Mr. Hanson. Nur leider kann man das auf einem UN-Symposium schwer mitteilen. Daher habt ihr das exklusiv von mir jetzt. Pris grüßt uns schön aus dem Jahr 2017…

[S.O.P.H.I.A. - Sub-Optimal Philantropic Half-Intelligent Android]