Archiv für die Kategorie „CPUs“

Er ist zurück, wahlweise diesmal sogar in fancy colours:

Der Computer, mit dem ich mit 4 Jahren IT erlernte.

Ein ikonisches Gerät der 80er Jahre.

Eines der hässlichsten Stücke Hardware aller Zeiten.

Und dennoch: wie geil ist das denn bitte!?

Ich hätte mit so etwas niemals gerechnet. Und ich denke damit stehe ich nicht alleine. Was man allerdings auch nicht unterschätzen darf: es gibt eine riesige Modding-Szene, die selbst heute noch stolz und sehr beachtenswert für die Originalhardware programmiert. Und auch darüberhinaus dürften sich interessierte Abnehmer finden, wenn sie mindestens 250€ locker machen können.

Doch was wird dieses Mal anders sein?

Nun, unter der Haube arbeitet ein Xilinx Artix-7 von AMD. Er bringt 128MB Arbeitspeicher mit und arbeitet mit Field Programmable Gate Arrays (FPGA) mit niedriger Latenz; das sind „programmierbare Schaltstrukturen“. Der Cloud dabei: keine Software-Emulation nötig. Auch alte Hardware und Kassetten soll man nutzen können, man geht von 99% Kompatibilität aus. Einzige Voraussetzung: die jahrzehntealte Hardware muss natürlich auch heute noch funktionieren, was nicht einfach werden dürfte.

Was auch noch wichtig ist: die Firma gibt es eigentlich nicht mehr. Es handelt sich hierbei um das Projekt des YouTubers Christian Simpson, der sich kürzlich für einen niedrigen siebenstelligen Betrag die Rechte an der Marke gesichert hat. Seine Vision scheint bei den alten Hasen der C64-Programmierung gut angekommen zu sein, denn mittlerweile hat er sich die auch gleich mit ins Boot geholt. Man arbeitet also an einer gemeinsamen Umsetzung, gab aber auch zu bedenken, dass man aktuell keine Vorstellung hat, ob die Rechnung am Ende aufgeht. Den Mut und v.a. die Schnelligkeit hatten sie hier in jedem Fall, kann gerne so weitergehen. Ich bin gespannt.

Vorbestellungen und weitere Infos zu dem neuen alten Brotkasten kann man hier machen: https://commodore.net/.

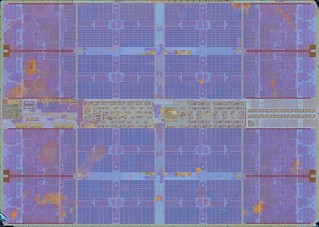

Schon krass:

Weiß leider nicht, welcher iPhone-Prozessor hier genau angeschaut wird – wenn es wer weiß, bitte ab in die Comments!

Ist eigentlich unvorstellbar, welchen Detailgrad hier die Prozessorherstellung in nur wenigen Jahrzehnten erreicht hat. Der Traum aller CPU-Nerds – man kann verstehen warum.

2024 war für Intel-Hasser das wahrscheinlich beste Jahr ever. Da es sich rapide dem Ende zuneigt, wollte ich ein paar sehr geile Schlaglichter daher absolut nicht unerwähnt lassen:

Intel fliegt nach 25 Jahren aus dem Dow-Jones-Index

So viel Nettominus gab es bei Intel noch nie: 16,6 Milliarden US-Dollar

Intel sagt plötzlich: „Stolz stehen wir auf der Seite von AMD“. Es geht um die Konkurrenz von ARM, auf einmal ist AMD ein Kumpel…

Warum ist Intels Geschäft eigentlich so kompliziert?

Intel is the latest Fortune 500 giant to test the ‘4 wrong CEOs’ rule – „no company can survive four consecutive wrong CEOs“ 😀

Intel suspends dividend, cuts $10B in costs: CEO reacts

Desktop-Prozessoren: So wenig Verkäufe wie seit 1993 nicht mehr

Intel verbucht den höchsten Quartalsverlust der Firmengeschichte

Im Kern stellte sich das so dar, dass schlechte Chefs und das Verschlafen des KI-Hypes zu einer Gemengelage geführt haben, die den Chiphersteller ins Verderben stürzten. Und das war auch kein Phänomen aus 2024 allein, die letzten zwei Links oben sind aus 2023. In keinem Jahr vorher allerdings habe ich mehr Links zu Intel bei href.ninja gesammelt als dieses Jahr. Einzige Ausnahme: 2018. Als die Welt endlich offen sehen konnte durch Meltdown und Spectre wer die mangelhaftesten CPUs der Welt baut. Und durch Marketing („Hyperthreading“) auch Käufer offen betrügt.

Mich wundert das alles daher nicht, karma strikes, und das sieht man sehr schön auch wieder hier. Was mich nur gewundert hat persönlich, warum das so lange gedauert hat. Gut, ich sammle Texte und Links zu dem Zeug bereits seit vielen Jahren. Aber schiefgehen? Bei Intel!? Mit aktuell fast 125.000 Mitarbeitern? Das hatte ich mir vielleicht mal in meinen 20ern naiv gewünscht, doch zum Wahrwerden waren die mir mittlerweile einfach „too big too fail“. Ich hatte die Möglichkeit mittlerweile ausgeschlossen, das ist einfach viel zu lange her alles.

Wie geht es weiter? Sie werden Hilfe brauchen. Auch nach Deutschland kommt keine Fabrik mehr. Aber mit Hilfe meine ich eigentlich „göttliche Hilfe“. Weil was anderes bringt hier nichts mehr, wenn du 2-3 Jahre KI-Evolution verschläfst, bist du, wenn die Technologie sich so fröhlich schnell weiterentwickelt, irgendwann weg vom Fenster. Qualitativ wird das kein Problem sein. Aber vom Image her? Wisst ihr was: mir egal! 😀

My laptop CPU became an artist over night:

What we see here is actual unique artwork my CPU created over a timeframe of approx. 12 minutes. The only thing I input to was the text string a cyberpunk cityscape and let Stable Diffusion do the rest. It’s beautiful and detailed. I actually love it!

Stable Diffusion is a sophisticated, brand new deep learning model by Stability.ai. It’s already on par with the earlier released, proprietary AI image generators DALL-E 2 or Imagen. With a powerful difference: you can actually create AI images yourself for free on your local machine. Usually done by your GPU, or like in my case above, your CPU, if capable.

I put four hours of work into it yesterday to setup my machine and create more artwork. My CPU came up with more beautiful cyberpunk cityscape examples with the following text string, a cyberpunk cityscape in neonlights at night, see the gallery here:

- a cyberpunk cityscape in neonlights at night

- a cyberpunk cityscape in neonlights at night

- a cyberpunk cityscape in neonlights at night

- a cyberpunk cityscape in neonlights at night

- a cyberpunk cityscape in neonlights at night

I’m lucky to own a powerful notebook CPU from 2020 with a graphics processor built in. I don’t know if this made a difference or not, the results surely are true for what I anticipated and surpassed my expectations.

But how can you join the CPU AI image generation yourself?

I had time to write it down yesterday and am happy to share it here for free for anyone who might be interested to do this with her/his Linux machine.

Step 0: Create a working directory in your /home

Step 1: Install Python

sudo apt-get update*

yes | sudo apt-get install python3.8*

*could be the installation of Python 3.8 is different to the one mentioned above. In this case just use your package manager of your Linux distribution to get the program installed on your machine.

Step 2: Install Miniconda

wget https://repo.anaconda.com/miniconda/Miniconda3-py38_4.12.0-Linux-x86_64.sh

bash Miniconda3-py38_4.12.0-Linux-x86_64.sh

Step 3: Clone the Stable Diffusion Repository

git clone https://github.com/CompVis/stable-diffusion.git

cd stable-diffusion/

Hint: Repo above only works for graphics cards >= 7GB (V)RAM! Thus…

Step 4: Download the ZIP, extract, copy and paste the contents following optimised version of Stable Diffusion in the folder above:

https://github.com/basujindal/stable-diffusion

Step 5: Create Conda Environment

conda env create -f environment.yaml

conda activate ldm

Step 6: Download Stable Diffusion Weights

curl https://www.googleapis.com/storage/v1/b/aai-blog-files/o/sd-v1-4.ckpt?alt=media > sd-v1-4.ckpt

Step 7: Content blocker deactivation (needed in case your output images are green or black only)

* find and open file pipeline_stable_diffusion.py

* below image = image.cpu().permute(0, 2, 3, 1).numpy() replace anything with this and save the file:

# run safety checker

#safety_cheker_input = self.feature_extractor(self.numpy_to_pil(image), return_tensors=“pt“).to(self.device)

#image, has_nsfw_concept = self.safety_checker(images=image, clip_input=safety_cheker_input.pixel_values)if output_type == „pil“:

image = self.numpy_to_pil(image)#return {„sample“: image, „nsfw_content_detected“: has_nsfw_concept}

return {„sample“: image, „nsfw_content_detected“: False}

Step 8: Generate AI images with the CPU

python optimizedSD/optimized_txt2img.py –device cpu –precision full –prompt „a cyberpunk cityscape“ –H 512 –W 512 –n_iter 1 –n_samples 1 –ddim_steps 50

That’s it! By default you find your created images in the outputs folder. You can enter your deserved text string in „“ and let your machine do the rest. Feel free to share some of your works in the comments if this tutorial helped you.

P.S.: I also had the chance to create GPU images yesterday with this method. The only difference is by removing the part –device cpu from the command line code you find in step eight. It will be much faster but to me the option to let your CPU create actual artwork was very much appreciated and may not be well known for future AI generation images through Stable Diffusion. I had some very nice results. Will share more of my work in future entries here on gizmeo.eu so stay tuned!

Das komplizierteste Gadget des Planeten läuft wieder – nach dreieinhalb Jahren Pause für verschiedene Wartungen und Upgrades: der LHC vom CERN, Europas größter Teilchenbeschleuniger.

Ende April kam die Erfolgsmeldung, wenn auch noch mit „kleiner“ Geschwindigkeit der Protonen von jeweils 450 GeV. Es wird noch Wochen dauern, bis die angestrebten 13 TeV wieder erreicht werden können.

Doch was genau erhofft man sich denn noch zu finden?

* Higgs-Boson: CHECK!

* Multiversum ist nichtig durch die genaue Massebestimmung des Higgs-Boson: auch CHECK!

Arg viel mehr revolutionärer kann es eigentlich nicht mehr werden, oder?

Wahrscheinlich nicht, zumindest für das Standardmodell der Physik. Doch die Daten sind erst zu 10% gesammelt. Hier liegt wahrscheinlich der eigentliche Schlüssel, ob es noch große Geheimnisse geben wird. Überhaupt die Daten: Auswertung und Optimierung hier dürfte Jahre dauern. Jedenfalls bin ich froh, dass diese „Riesenmaschine“ wieder läuft! War sie doch neben einem wissenschaftlichen Superinstrument auch ein schönes Zeichen der wissenschaftlichen weltweiten Zusammenarbeit, viele Nationen und Entwicklungen von dort unter eine erfolgreiche Haube gebracht. In der aktuellen Welt wie ein wertvolles Relikt aus einer anderen Zeit.

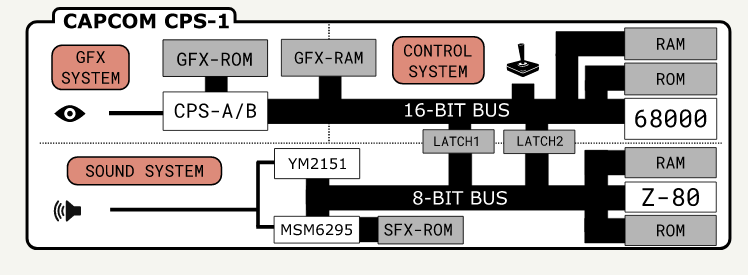

Fabian Sanglard hat eine Textserie zu „Street Fighter II“ gemacht.

Er widmet sich dort der Hardware zum Spiel, genauer, den diversen internen Hardwarekomponenten, die die Arcademaschinen zusammengehalten haben.

Man muss wissen die Arcademaschinen der späten 80er waren komplexe, dumme Geräte. Es gab nur wenige Innovatoren auf dem weltweiten Markt, einer ist Capcom, die Entwickler des oben erwähnten Kult-Brawlers. Der andere war SNK, sagt vielleicht dem einen oder der anderen was.

Ein Teil des Spiels, was es hinterher zum Kult werden ließ, war natürlich der Sound darin. Es geht doch nichts über ein lautes, mieses, mit einem blauen Feuerball herbeigezaubertes Ha-dou-ken!

Möglich machte das der CPS-1:

Die Dokumentation hierzu soll sehr gut sein, sagt Florian. Zumindest wer Mame kennt und C++ lesen kann. Werden weltweit leider nur wenige Millionen sein.

Anyway, den Artikel zum Soundsystem aus Street Fighter II findet man hier: https://fabiensanglard.net/sf2_sound_system/index.html.

Lohnt sich schon allein wegen den vielen eingebundenen Soundbeispielen. 🙂

Software.

Hardware.

Made in USA.

Nothing they create is Excellent.

Most of it is Good.

Sometimes even Very Good.

In any case, good is best.

Never try to be excellent. You will fail.

Never stop reaching for the stars.

Never stop being you.

Consume.

Adapt.

Create.

Feel good.

It sounds simple.

It’s incredibly difficult.

Just like life.

Just create. And never stop.

Never.

You’re good.

Im Webland passiert aktuell sehr viel, man könnte meinen, die Pandemie sei bereits vorbei. Das ist echt gut, denn dadurch fällt es seit wenigen Wochen wieder etwas leichter v.a. technische Themen zu finden und diese auch hier voranzubringen!

Eines davon sei heute vorgestellt: Projekt Morpheus.

Von den Ingenieuren, die einst die Architektur des Internets entwickelten, der DARPA, kommt ein vielversprechender neuer Prozessor, der garstigen Angriffsvektoren wie Meltdown und Spectre den Garaus machen soll.

Das schafft dieser dadurch, indem er einfach dauernd und zufällig die CPU-Architektur ändert.

Das macht er nicht in Minuten. Auch nicht in Sekunden. Sondern in Millisekunden.

Der Bericht: https://theconversation.com/shape-shifting-computer-chip-thwarts-an-army-of-hackers-159990.

Erst letzten Sommer sollen 525 IT-Sicherheitsexperten über drei Monate hinweg versucht haben diese CPU zu hacken – wohl vergeblich. Daraufhin gab es von der DARPA selbst auch erst im Januar offizielle Ergebnisse in einem Paper.

Es gibt dazu oftmals kritische Stimmen in meinem Hinterkopf, wenn die DARPA etwas macht, so auch hier: „wenn sich dauernd, innerhalb von Millisekunden meine CPU-Architektur ändert, wie soll ich bitte dafür etwas programmieren, geschweige denn dauerhaft laufen lassen!?“ Doch auch hier scheint es bereits eine Antwort zu geben:

„…this happens at the microarchitecture level, software running on the processor is unaffected“

Glaube ich dennoch erst, wenn ich es sehe.

Und auch diese neuartige „Gestaltwandler-CPU“ kostet hardwareseitig was, nämlich 10% Einbußen der Prozessorperformance. Das kann uns heute bei n Kernen pro CPU allerdings IMHO herzlich egal sein.

Wer hochwertige Gadgets möchte, der kauft bei Samsung. Wer schon mal einen Sony Bravia-TV auseinandergebaut hat oder ein iPhone, hier sind Teile von Samsung verbaut. Chips, Displays, Inverter – you name it.

Doch auch als Innovatoren können die Südkoreaner sehr gut, ihr neustes vielversprechendes Hardware-Bauteil: ein KI-RAM.

Intern nennen sie es FIMDRAM, im Detail schaut der Die (Halbleiter-Waferstückchen) dann so aus:

Praktisch haben sie wohl „einfach“ programmierbare Recheneinheiten (Programmable Computing Units (PCU)) zwischen die Speicherbänke verbaut. Die können zwar aktuell lediglich 16-bitige Fließkommazahlen verarbeiten und verfügen nur über einfache Instruktionen (Daten verschieben; Multiplikation; Addition). Dennoch clocken diese mit 300MHz – was einer Leistung von 1,2 TFLOPS entsprechen soll. Das ist enorm: zum Vergleich, das gesamte PS4-System (keine Pro-Version) bringt 1,84 TFLOPS Leistung…

Samsungs neuartiger RAM im Detail (PPTs): https://m.gsmarena.com/samsung_creates_ram_with_integrated_ai_processing_hardware-news-47794.php.

Hardwareseitig könnte man effizientere KI-CPUs wohl aktuell nicht bauen. Die Latenzen sind hier sehr gering, ferner verbrauchen die Chips 71% weniger Energie. Ein Wermutstropfen bleibt aber noch: nicht nur wird das Design erst diese Woche bei der International Solid-State Circuits Virtual Conference von den Südkoreanern der Weltöffentlichkeit präsentiert. Die Validierung von Experten wird noch mindestens bis Juli dauern. Mit etwas Glück erscheinen diese speziellen neuen KI-RAM-Riegel dann wohl Ende dieses Jahr/Anfang 2022 in Hardware, die man als 0815-Konsument kaufen und programmieren können wird.

Ein Wendepunkt in der Programmierung künstlicher Intelligenz? Könnte sein. Ich persönlich traue es Samsung durchaus zu.

Apple hat dieser Tage neue „Macbooks“ präsentiert. Äußerlich hat sich nicht viel getan, außer einer neuen Taste für Emojis (oh, yeah!11). Aber wie immer zählen ja innere Werte: und da werkelt nun der hauseigene(!) M1, Apples allererster in 5nm gefertigter ARM-SoC. Eat this, Intel!11

Ich wollte nun wissen, wie meine AMD-Laptop-CPU (Ryzen 7 4800HS, Weltpremiere 16. März 2020) im Vergleich zum M1 (Weltpremiere 17. November 2020) abschneidet. Da bot sich geekbench5 an, weil: keine Ahnung!? o.O Doch immerhin hatte ich hier bereits Ergebnisse vom Juli vorliegen. Und das „Tryout“-Programm gibt es für Linux auch kostenlos.

Meine besten Ergebnisse damals:

Single-Core: 1269

Multi-Core: 8030

Die Ergebnisse des M1 aktuell:

Single-Core: 1718

Multi-Core: 7534

Gar nicht mal so schlecht für eine Handy-CPU, ihr Eierköpfe aus Cupertino!

Mit einer ähnlich hohen wissenschaftlichen Relevanz wie 1996 mit dem Schachcomputer „Deep Blue“ gegen Schachweltmeister Garri Kasparow, so hat exakt 20 Jahre später ein Computerprogramm, „AlphaGo“, den südkoreanischen Großmeister des asiatischen Strategiespiels Go, Lee Sedol, geschlagen.

Eine Dokumentation in Spielfilmlänge (ca. 90 Minuten), die mittlerweile frei und kostenlos im Internet erhältlich ist, kann man sich hier anschauen:

Eigentlich galt Go bis zu diesem Zeitpunkt als von einer KI (künstlichen Intelligenz) „unknackbar“, hat es nicht nur mehr Felder pro Brett (19×19, statt 8×8), sondern lässt in Theorie mehr Züge zu, „als es Atome im Universum gibt“. Ferner ist es durch reines Herumprobieren, dem sogenannten Brute Forcing, auch nicht im Voraus berechenbar.

Es stellte sich heraus, für die Künstliche Intelligenz mussten nicht nur neue Algorithmen her (in diesem Fall der Monte-Carlo, da er mit Zufällen arbeiten kann), sondern gleich ein komplett neues neuronales Netz, das tiefe neuronale Netzwerk. Nach 9 Jahren Forschung wollte die Firma DeepMind dann genauer wissen, was die Eigenentwicklung wirklich drauf hatte: Sedol verlor vier von fünf Spielen.

Der Film ist nichts für Philanthropen, bietet allerdings neben interessanten Einsichten in menschliche Psychen auch viel Wissenswertes zum Thema Informatik und künstliche Intelligenz allgemein. Man darf gespannt sein, wo man hier 2036 angekommen sein wird; wer/welche Firma das Programm stellt; und welches Spiel die Menschheit noch für immer verloren geben muss (siehe auch: Der Alpha-Go-Schock und die Folgen, 22.12.16).

Aus einem mir unerfindlichen Grund war ich bis heute geplagt mit AMD-CPU-Capping. Unter Vollast und/oder bei CPU-Temperaturen von 70C+ ging die Frequenz unter Linux einfach runter auf 399MHz. Und blieb dort. Bis zu einem Reboot.

Serious!?

Ja, ernsthaft. Und das Problem hat mich nun 80+ Tage beschäftigt. Oder eben zu selten gekümmert.

Oben: AMD Zen2 CPU: Epyc 7702 – 64-Kerne, 128 Threads, 200W

Stellt sich heraus, ich konnte wohl ein wichtiges Modul bzw. einen ASUS-Kernel-Patch nicht nutzen:

modprobe -v asus-nb-wmi

insmod /lib/modules/5.8.11-1-linux/kernel/drivers/input/serio/i8042.ko.xz

modprobe: ERROR: could not insert ‘asus_nb_wmi’: No such device

Bei mir gab es unter /sys/devices/platform/ einfach keinen Ordner asus-nb-wmi. Und der hätte ab Kernel 5.6.x wohl genau dort sein sollen. Da kann ich modproben, bis ich schwarz werde.

Was tun? Wir sind mit Internet nie alleine, zum Glück auch nicht mit Problemen, so fand ich die selbe Issue vom selben Hardware-Hersteller für ein anderes Modell, https://lab.retarded.farm/zappel/asus-rog-zephyrus-g14/-/issues/9. Man solle einfach i8042.nopnp als Kernelparameter dem GRUB hinzufügen und rebooten. Was ich tat.

Das erste Erfolgsgefühl hatte ich dann beim erneuten Modproben: keinerlei Fehlermeldung. Okay, sehr cool! Natürlich wollte ich danach wissen, ob der Ordner nun da ist: und auch der asus-nb-wmi war nun vorhanden (logisch, aber egal), inklusive Inhalte. Nice!

Wirklich etwas von der Kiste gefordert hatte ich da noch nicht, also wieder den BOINC-Client gestartet – meines Wissens „der ultimative Stresstest“ für jede CPU/GPU. Hier hatte ich auch immer wieder die Erfahrung gemacht, dass die CPU einknickt. Und tatsächlich: jetzt ist 18:00 und seit dem Mittag läuft meine CPU, eine AMD Ryzen 7 4800HS, unter Vollast mit erwartbarer dynamischer Frequenz und auch mit Temperaturen Ü70C (aktuell locker 90C, offiziell verträgt er wohl 105C).

W00t!

Nun, egal. Selbst Schuld, bleeding edge hardware gekauft zu haben… ¯\_(ツ)_/¯

Man kann von Tesla halten was man will: US-amerikanische Marke; Verarbeitung nicht so gut wie bei deutschen oder japanischen Modellen; Akku brennt; der Gründer ist ein (Cov-)Idiot; Markennamen von einem bedeutenden europäischen Erfinder geklaut; etc. pp. You name it.

Aber eines kann man ihnen nicht vorwerfen: der Wille zur Innovation.

Bei Tesla träumt man Innovationen nicht nur oder zeichnet diese. Sie werden in Realität gesetzt. Und dabei haben sie anderen Firmen auf dem Planeten manches voraus. So z.B. ein fahrbares und nutzbares E-Automobil. Und ein zukunftsfähiges Konzept insgesamt. Ja, wahrscheinlich DAS Zukunftskonzept der Mobilität überhaupt für die nächsten Jahrhunderte. Und das „schon jetzt“.

Deshalb lohnt es sich genau jetzt in Tesla-Aktien zu investieren: durch den Split ging der Preis pro Aktie nämlich fast über Nacht von über 2.200$ runter auf aktuell 360€. Wer also ein paar Hunderter übrig hat, das sollten einige Menschen sein seit März, auch unter meinen Leserinnen und Lesern, der sollte sich (ein Depot eröffnen und) Aktien dieser Firma kaufen. Es ist sehr wahrscheinlich, dass die 1.000€ wieder schnell geknackt sein werden. Dann hätte man alleine durch eine Beteiligung fast das Dreifache wieder drin. Ende ist hier übrigens nach oben offen.

Man kann das Geld schnell mitnehmen oder halten. Ich würde halten. Einfach aus „Prinzip Zukunft“. Und es gibt da noch etwas, was ich bemerkenswert fand, die Meldung ist aber schon ein paar Monate her.

Wie wir alle wissen sind oder waren die Japaner mal das technologisch am weitesten fortgeschrittene Völkchen der Erde. So stark und so mächtig und sehr weit fortgeschritten, sie galten als „Schwan“ und flogen in Gesamtasien voraus, während andere Länder wie Südkorea, sogar Taiwan und China, hinterher wackeln mussten. Irgendwann in den 80ern war das so. Es mag sich mittlerweile gewandelt haben, ich bin auch der Meinung, insgesamt haben wir „alles schon erfunden“, also da wird kaum noch was Neues kommen für die Menschheit. Und das wechselt sich da unten nun munter ab, wer in der Parabel voraus fliegt. Ich tippe ja aktuell auf Südkorea, China braucht noch ein paar Jahre, vielleicht Jahrzehnte. Wobei man Taiwan mit dem Chipfertiger TSMC hier auch nicht vergessen darf.

Ich schweife ein bisschen ab, denn was ich eigentlich erzählen will kann man auch ohne dieses Wissen und die Vogelzug-Parabel faszinierend finden.

Die Japaner haben nämlich vor wenigen Monaten den Tesla Model 3 komplett zerlegt, die Ergebnisse wurden im Februar der Weltöffentlichkeit präsentiert. Denn was machst du als Hacker erst einmal, wenn du neue Technik verstehen willst oder schauen möchtest, ob die Technik wirklich neu ist? Na klar, du baust sie auseinander!

Das Wichtigste und das Unbekannteste, das sie fanden, waren zwei individuell designte KI-Chips, von Tesla komplett selbst entwickelt(!), mit entsprechend inhouse-entwickelter Software:

Oben: der Computer des „Model 3“ – ein KI-Chip regelt das autonome Fahren, der andere das gesamte Infotainment-System

Im Kern fanden die Japaner heraus, „ja gut, das Hardware-Ensemble ist eben dafür gut, dass dieses Auto sich selbst steuern kann und die massive Infotainment-Anlage“. Und das stimmte dann auch. Doch was noch viel bedrückender war aus der Sicht der japanischen Ingenieure:

Die Hardware, die oben zu sehen ist, ist 6 Jahre ihrer Zeit voraus!

Tesla ist damit nicht nur Konkurrenten zeitlich enteilt, Tesla ist mit dieser Hardware einer kompletten Industrie enteilt.

„But technological hurdles are not the reason for the delay, according to the Japanese engineer who said „we cannot do it.““

Einer Industrie, die in Europa alleine 3,65 Millionen Menschen beschäftigt – bei Tesla arbeiten aktuell nur 48.000 (Stand 2019)…

Das ist „Alien-Sh*t“, was wir hier sehen. Solche Technik dürfte es aktuell gar nicht geben.

2019 nicht.

Dieses Jahr nicht.

Nächstes Jahr nicht.

2022 nicht.

2023 nicht.

2024 leider auch nicht.

Maximal „irgendwann 2025“, sagen Industrie-Insider. Denn auch wenn der Bericht Ende Februar publik wurde, auseinandergenommen wurde der Tesla wohl irgendwann Ende 2019.

Ganz ehrlich: WAS haben die da gebaut!? und WIE!? Ich bin kein reiner Ingenieur, aber ein kleiner CPU-Head. Vor solch einer Leistung habe ich irre Respekt. Und leider auch Angst.

Und sehen wir es realistisch, selbst wenn sie mit Autos als Konzept komplett sich zerlegen würden, sie hätten immer noch diese Chips, also konkrete Hardware, sowie maßgeschneiderte Software dazu im Angebot. Mir würden spontan mindestens ein Dutzend Anwendungsfälle dazu einfallen, „I, Robot“ wäre Kindergeburtstag dagegen.

Heute gesehen bei heise.de, ein „Highend-Notebook“ mit „300Hz“ vom Gemüse-Discounter unseres Vertrauens:

Ich musste heftig suchen, in welchem PC-Jahr wir hier wirklich angekommen sind.

Der Z3 von Zuse hatte 4 bis 5 Hz, irgendwann um 1941. Der ENIAC vier Jahre später, 1945, schon wuchtige 5kHz. Also irgendwo dazwischen.

Nur wurden leider keine weiteren Computer „dazwischen“ gebaut. Vielleicht fehlen hier auch Einträge in der westlichen Literatur. Die Technik war in jedem Fall noch zu neu und füllte Hallen, alleine die Z3 wog über eine Tonne.

Mit der Headline habe ich noch ein weiteres riesiges Problem neben der Unvollständigkeit (falls das überhaupt jemandem auffiel): ich gehe hier von der Taktfrequenz eines Prozessors aus und halte das für „normal“. Im Text aber geht es um das Display.

Sind Displays heute wichtiger als CPUs!? Sind CPU-Infos nicht mehr relevant für Technikmagazine?? Und: wer kauft eigentlich PCs bei ALDI!? Hakt’s?

…mit Hardware von Qualcomm!

Der wichtigste Chip in einem Smartphone oder Tablet nennt sich SoC, System on (a) Chip. In der Bezeichnung steckt eigentlich bereits alles drin, was man darüber wissen muss: die CPU, Grafikeinheit, GPS, sowie allerlei Kladeradatsch, um mobile Kommunikation möglich zu machen, sowie vieles andere mehr (z.B. für Multimedia wie Filme und Musik) werden in einem einzigen Chip vereinigt. Ingenieurstechnisch ist das eine Spitzenleistung und aller Ehren wert. Sicherheitsaspekttechnisch die reinste Katastrophe.

Ein Beispiel für den schematischen Aufbau eines Snapdragon-SoC, technisch Highend und aus dem Hause Qualcomm, liefert die folgende Grafik:

Man beachte die rot markierten Elemente mit dem Zusatz DSP (Digital Signal Processor). Forscher von Check Point wollen für diese untergeordneten Chips nicht ein Sicherheitsleck, nicht zwei, sondern sage und schreibe 400 Stück entdeckt haben:

https://blog.checkpoint.com/2020/08/06/achilles-small-chip-big-peril/. via

Was Meltdown für Intel und Spectre für AMD, könnte Achilles, so haben die Forscher die Sammlung an Schwachstellen hier getauft, nun für Qualcomm werden: der absolute Supergau.

Betroffen sind die besten Geräte der namhaftesten Hersteller des Planeten: Google, Samsung, LG, Xiaomi, OnePlus – alle dabei und viele mehr. Potenziell bis zu 40% der aktuell drei Millarden Smartphonenutzer weltweit.

Auch die CVEs wurden bereits in die Datenbank aufgenommen, aktuell lauten diese CVE-2020-11201, CVE-2020-11202, CVE-2020-11206, CVE-2020-11207, CVE-2020-11208 und CVE-2020-11209.

Checkpoint hat keinerlei Details zu praktischen Anwendungen veröffentlicht und auch den Hersteller Qualcomm mustergültig informiert. Reagiert dieser nicht, will man mit den Ergebnissen zu den 400 Angriffsvektoren in drei Monaten an die Öffentlichkeit gehen. Spätestens dann sollte man sich wieder ein Dumbphone als Alternative zugelegt haben, so munkelt man.