Archiv für die Kategorie „Linux“

Als IT-Spezialist und F/OSS-Unterstützer werde ich in Diskussionen oft danach gefragt, was es an Alternativen zu proprietären Programmen gibt. Meist geht das sehr schnell, gelegentlich kann das aber auch ausarten.

Von daher begrüße derlei Grafiken sehr, veranschaulichen sie doch auf einen Blick Alternativen zu proprietären IT-Werkzeugen, in diesem Fall der Firma Adobe:

Die Grafik hier stammt von quze.co, einer E-Learning-Plattform. Sie stammt aus der „Windy City“ Chicago und wurde 2018 gegründet.

Solche Leistungen sind immer zu würdigen, jedoch nie einfach zu erstellen. Das weiß ich aus leidiger Erfahrung. Ich bin froh sie teilen zu können und sollte ich es nicht zwischendurch vergessen, reicht mir nun ein Link zu meinem eigenen Beitrag. 😀

Wer hochwertige Gadgets möchte, der kauft bei Samsung. Wer schon mal einen Sony Bravia-TV auseinandergebaut hat oder ein iPhone, hier sind Teile von Samsung verbaut. Chips, Displays, Inverter – you name it.

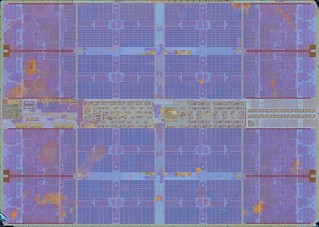

Doch auch als Innovatoren können die Südkoreaner sehr gut, ihr neustes vielversprechendes Hardware-Bauteil: ein KI-RAM.

Intern nennen sie es FIMDRAM, im Detail schaut der Die (Halbleiter-Waferstückchen) dann so aus:

Praktisch haben sie wohl „einfach“ programmierbare Recheneinheiten (Programmable Computing Units (PCU)) zwischen die Speicherbänke verbaut. Die können zwar aktuell lediglich 16-bitige Fließkommazahlen verarbeiten und verfügen nur über einfache Instruktionen (Daten verschieben; Multiplikation; Addition). Dennoch clocken diese mit 300MHz – was einer Leistung von 1,2 TFLOPS entsprechen soll. Das ist enorm: zum Vergleich, das gesamte PS4-System (keine Pro-Version) bringt 1,84 TFLOPS Leistung…

Samsungs neuartiger RAM im Detail (PPTs): https://m.gsmarena.com/samsung_creates_ram_with_integrated_ai_processing_hardware-news-47794.php.

Hardwareseitig könnte man effizientere KI-CPUs wohl aktuell nicht bauen. Die Latenzen sind hier sehr gering, ferner verbrauchen die Chips 71% weniger Energie. Ein Wermutstropfen bleibt aber noch: nicht nur wird das Design erst diese Woche bei der International Solid-State Circuits Virtual Conference von den Südkoreanern der Weltöffentlichkeit präsentiert. Die Validierung von Experten wird noch mindestens bis Juli dauern. Mit etwas Glück erscheinen diese speziellen neuen KI-RAM-Riegel dann wohl Ende dieses Jahr/Anfang 2022 in Hardware, die man als 0815-Konsument kaufen und programmieren können wird.

Ein Wendepunkt in der Programmierung künstlicher Intelligenz? Könnte sein. Ich persönlich traue es Samsung durchaus zu.

Apple hat dieser Tage neue „Macbooks“ präsentiert. Äußerlich hat sich nicht viel getan, außer einer neuen Taste für Emojis (oh, yeah!11). Aber wie immer zählen ja innere Werte: und da werkelt nun der hauseigene(!) M1, Apples allererster in 5nm gefertigter ARM-SoC. Eat this, Intel!11

Ich wollte nun wissen, wie meine AMD-Laptop-CPU (Ryzen 7 4800HS, Weltpremiere 16. März 2020) im Vergleich zum M1 (Weltpremiere 17. November 2020) abschneidet. Da bot sich geekbench5 an, weil: keine Ahnung!? o.O Doch immerhin hatte ich hier bereits Ergebnisse vom Juli vorliegen. Und das „Tryout“-Programm gibt es für Linux auch kostenlos.

Meine besten Ergebnisse damals:

Single-Core: 1269

Multi-Core: 8030

Die Ergebnisse des M1 aktuell:

Single-Core: 1718

Multi-Core: 7534

Gar nicht mal so schlecht für eine Handy-CPU, ihr Eierköpfe aus Cupertino!

*…klaut die Stimme von Marsimoto, der sie von Quasimoto geklaut hat, am Ende ist es auch einfach nur eingeatmetes Helium, weil den Schallwellen gefällt das, und legt dann mal los…*

Keiner kümmert sich um GPUs/

Wie geht es deiner GPU/

Frag‘ dich: was macht Klicki-Bunti-Grafik/

Es ist deine GPU, sonst nix/

STRG+Escape, die GPU taucht da nicht auf/

wieso denkt der doofe Coder, dass ich GPU nicht brauch/

CPU, RAM, mein Benutzername, Tabellenansicht/

wieso sehe ich die Prozentzahl meiner GPU nicht/

meine GPU macht mir Grafik, das ist wichtig/

meinem Pinguin fehlt ohne GPU sein Gesicht/

CPU ist das Gehirn, GPU schiebt die Optik/

Pink und Rosa – GPU, sonst nix/

Keiner kümmert sich um GPUs/

Wie geht es deiner GPU/

Frag‘ dich: was macht Klicki-Bunti-Grafik/

Es ist deine GPU, sonst nix/

Windows, Linux, Unix – alles braucht hier Grafik/

wieso sehe ich nach Reboot GPU-Temperatur nicht/

Was heißt „off“, wieso hier Reload mit rechter Maustaste/

ohne GPU nützt mir Temperatur-Widget nix/

Treiber-Treiber, immer Treiber, offen oder proprietär/

Hauptsache „Diablo“ läuft, denn was nützt hier „Solitär“/

Laptop, PC, Smartphone oder Tablet/

ohne GPU kein einziger Pixel hier, nix fett/

Keiner kümmert sich um GPUs/

Wie geht es deiner GPU/

Frag‘ dich: was macht Klicki-Bunti-Grafik/

Es ist deine GPU, sonst nix/

Helfer-Tool hier, Helfer-Tool da/

der Aufwand für jede GPU – immerda/

das Erste, was ich an neuer Hardware einrichte/

ist GPU, weil der Rest läuft bereits aus der Kiste/

„out of the box“, IT, wie sie immer sein soll/

wieso funktioniert GPU nicht, was hat sie euch getan/

liegt es vielleicht an AMD oder NVIDIA/

oder Apple, oder ARM, vielleicht auch C&A/

Keiner kümmert sich um GPUs/

Wie geht es deiner GPU/

Frag‘ dich: was macht Klicki-Bunti-Grafik/

Es ist deine GPU, sonst nix/

Meinen Stromanbieter, den freut’s/

denn heute mine ich auf GPU die Kryptocoins/

Warnschild rot, die GPU schon über 90 Grad/

warum ist Geld verdienen hier so hart/

die GPU, ja sie macht die Träume wahr/

Traumfabrik in Plastik, wir sind so smart/

und jetzt auch die KI für ein paar Hunderter/

übermorgen fliegt mich GPU zum Mars, sonnenklar/

Keiner kümmert sich um GPUs/

Wie geht es deiner GPU/

Frag‘ dich: was macht Klicki-Bunti-Grafik/

Es ist deine GPU, sonst nix/

ich schalte das Teil ab, GPU muss sich schlafen legen/

sie lief zwei Wochen durch und muss nun Updates regeln/

hoffentlich ist nach Reboot meine GPU noch da/

bei shutdown -r now denke ich über Heirat nach/

doch was ist das, ist es ein Fussel oder doch ein Haar/

wie Schuppen von den Augen wird mir dann plötzlich klar/

Mist, schon wieder zwei Zentimeter Schicht drauf/

ich muss das Ding erstmal jetzt abstauben/

Keiner kümmert sich um GPUs/

Wie geht es deiner GPU/

Frag‘ dich: was macht Klicki-Bunti-Grafik/

Es ist deine GPU, sonst nix/

Aus einem mir unerfindlichen Grund war ich bis heute geplagt mit AMD-CPU-Capping. Unter Vollast und/oder bei CPU-Temperaturen von 70C+ ging die Frequenz unter Linux einfach runter auf 399MHz. Und blieb dort. Bis zu einem Reboot.

Serious!?

Ja, ernsthaft. Und das Problem hat mich nun 80+ Tage beschäftigt. Oder eben zu selten gekümmert.

Oben: AMD Zen2 CPU: Epyc 7702 – 64-Kerne, 128 Threads, 200W

Stellt sich heraus, ich konnte wohl ein wichtiges Modul bzw. einen ASUS-Kernel-Patch nicht nutzen:

modprobe -v asus-nb-wmi

insmod /lib/modules/5.8.11-1-linux/kernel/drivers/input/serio/i8042.ko.xz

modprobe: ERROR: could not insert ‘asus_nb_wmi’: No such device

Bei mir gab es unter /sys/devices/platform/ einfach keinen Ordner asus-nb-wmi. Und der hätte ab Kernel 5.6.x wohl genau dort sein sollen. Da kann ich modproben, bis ich schwarz werde.

Was tun? Wir sind mit Internet nie alleine, zum Glück auch nicht mit Problemen, so fand ich die selbe Issue vom selben Hardware-Hersteller für ein anderes Modell, https://lab.retarded.farm/zappel/asus-rog-zephyrus-g14/-/issues/9. Man solle einfach i8042.nopnp als Kernelparameter dem GRUB hinzufügen und rebooten. Was ich tat.

Das erste Erfolgsgefühl hatte ich dann beim erneuten Modproben: keinerlei Fehlermeldung. Okay, sehr cool! Natürlich wollte ich danach wissen, ob der Ordner nun da ist: und auch der asus-nb-wmi war nun vorhanden (logisch, aber egal), inklusive Inhalte. Nice!

Wirklich etwas von der Kiste gefordert hatte ich da noch nicht, also wieder den BOINC-Client gestartet – meines Wissens „der ultimative Stresstest“ für jede CPU/GPU. Hier hatte ich auch immer wieder die Erfahrung gemacht, dass die CPU einknickt. Und tatsächlich: jetzt ist 18:00 und seit dem Mittag läuft meine CPU, eine AMD Ryzen 7 4800HS, unter Vollast mit erwartbarer dynamischer Frequenz und auch mit Temperaturen Ü70C (aktuell locker 90C, offiziell verträgt er wohl 105C).

W00t!

Nun, egal. Selbst Schuld, bleeding edge hardware gekauft zu haben… ¯\_(ツ)_/¯

2012/2013 war Secure Boot ein megaheißes Thema. So dermaßen heiß, dass ich sogar in meinem Feedreader zweistellig zählen konnte, siehe hier.

2020 ist dieses Rotzthema immer noch nicht tot.

Wie ist das möglich?

Gestern ein Update für das mitgelieferte Windows 10 auf einem Laptop gemacht, das berüchtigte Update 2004 vom Mai. Ich weiß nicht wieso, wohl aus Laune heraus oder weil ich einfach ein System wollte, wo ich nicht dauernd darauf hingewiesen werden möchte, dass es nicht 100% aktuell ist. Ich hätte es lassen sollen, denn ich verlor meinen GRUB.

Bootet anschließend Linux, bekam ich das hier heraus:

Welcome to Grub!

error: unknown filesystem.

Entering rescue mode…

grub rescue>

Jop, das war’s dann. Kein Linux will mehr booten. Und das mit ausgeschaltetem Secure Boot, ausgeschaltetem Fastboot _und_ dem manuell ausgewählten EFI-Eintrag im mitgelieferten BIOS-Interface.

Mit ls geht dann das Debugging los. Irgendwas mit (hd1,gptX) spuckt das System dann aus. Bei mir waren das 10+ Einträge. Jeden durchgehen, mit englischsprachigem Tastaturlayout, kurz vor Mitternacht, wo hängt mein verschollenes root herum?

Als es dann gefunden war, erst einmal /home gefunden, geil! Nix bootet. Glücklich war ich dann dennoch, denn irgendwie ist mein Linux ja noch da.

Da es auf einem Haussystem eigentlich nur zwei ext-Systeme geben kann wegen / und /home (oder welches Linux-Dateisystem auch immer man verwendet, z.B. reiser, etc.), hatte ich mit dem zweiten dann Glück. Mit folgenden Codezeilen brachte ich das System wieder in einen grafischen Bootzustand:

grub rescue > root=(hd1,gpt2)

grub rescue > prefix=(hd1,gpt2)/boot/grub

grub rescue > insmod normal

grub rescue > normal

Der soll dann zwar nur temporär sein, aber mir reicht das. Windows nutze ich vielleicht einmal im Schaltjahr. Dann kracht es aber richtig.

Ahhhh! Ahahahaha! Ihr Redmonder Zoophilie-Junkies mal wieder! Hatte euch schon fast komplett vergessen!

[Update I, 16.10.20]

Das mit der temporären Lösung ist einem ja irgendwann doch zu blöde, weshalb ich mir kürzlich wieder die permanente zurückerobert habe. Hier hilft es, wenn man sich zuerst mal ausgeben lässt, welche Partitionen man benutzt und wie diese heißen: lsblk -o PATH,PTTYPE,PARTTYPE,FSTYPE,PARTTYPENAME. Heutzutage wird das eher in Richtung nvmeXYZ gehen, bei älteren PCs ohne SSDs dann wahrscheinlich sda. Dann noch ein sudo update-grub, was bekannt sein sollte, sowie ein sudo grub-install /dev/sda bzw. ein sudo grub-install /dev/nvmeXYZ danach und dann „Macht’s gut, Redmond!“.

Weltweit soll es über 2,5 Milliarden (Stand Mitte 2019) Nutzer des auf Linux basierenden Android-Betriebssystems geben. Die Kontrolle über dieses Betriebssystem hat eine US-amerikanische Technologiefirma, die aktuell fast 324 Milliarden US-Dollar wert sein soll. Man sollte also meinen, die Veröffentlichung einer neuen Hauptversion dieses Betriebssystems, dem Kernstück auf Milliarden Geräten für Hosentaschen, muss ja faktisch mit großem Tamtam der Weltöffentlichkeit präsentiert werden.

Was macht Google stattdessen?

Spielt Indie und veröffentlicht, auch noch auf der eigenen Blogger-Plattform, lediglich einen ranzigen Blogpost: https://germany.googleblog.com/2020/09/unkompliziert-ubersichtlich-und.html.

W00t!

Nee, ist geil! Ehrlich gemeint! Wie selbstbewusst! Und mutig.

In Coronazeiten solche Meldungen an die Konsumenten des Planeten zu bringen ist schwerer als früher. Selbst der Megakonzern Apple, größter Konkurrent auf Smartphone- und Tablet-Gebiet, musste sich dieses Jahr etwas einfallen lassen, verschickte mysteriösere Nachrichten als sonst, hält noch Events ab _und_ versteckt Easter Eggs in Form Augmentierter-Realität-Goodies. DAS ist genau die selbe Richtung, allerdings um 180 Grad versetzt. Der eigene Charakter bestimmt hier, zu welcher Seite man gehören mag und welche einem besser gefällt. Der Kapitalismus neoliberaler Prägung ist doch etwas Wundervolles!

Jüngst kam auch auch heraus, dass entwicklerintern die Süßigkeiten-Codenames weiterhin verwendet werden: Android 11 heißt dort Red Velvet Cake. Die offizielle Meldung geht eigentlich anders, hier werden seit Version 10 keine süßen Aliase mehr benutzt.

Doch was soll eigentlich nun genau neu sein in Version 11?

Wenn ich das wissen will, lese ich keine News oder Blogposts, ich schaue in die Versionshistorie auf Wikipedia. Dort steht, Neuerungen seien diese hier:

* Temporäre App-Berechtigungen

* Unterstützung von 5G-Mobilfunknetzen

* Chats bekommen einen eigenen Bereich im Benachrichtigungsmenü

* Bluetooth bleibt im Flugmodus aktiviert

* Native Bildschirmaufnahme

* Stummschalten von Benachrichtigungen bei Videoaufnahmen

* Benachrichtigungsverlauf

* Rückgängigmachen von kürzlich gestoppten Apps

* Aktueller Sicherheitspatch-Stand: September 2020

Wirklich viel ist es nicht und wirklich revolutionär Neues kann ich hier nicht entnehmen. Das ist seit Jahren auch nicht mehr zu erwarten in dem Bereich. Wenigstens keine Liste mit „Updates für Emojis“ (oje…).

Mein persönlicher Eindruck ist sowieso: mit jeder neuen Hauptversion macht es Google unabhängigen Entwicklern schwerer 1) eigene ROMs zu bauen und 2) eigene Geräte auf dem neuesten Stand zu halten. Auch fliegen mittlerweile alle Apps, die älter als 1 Jahr sind, automatisch aus dem hauseigenen App-Store, aktualisiert man hier nicht mindestens die Version, auf der diese lauffähig sein sollen.

Die Hochzeit der Smartphones ist vorbei. Dann halt wieder LEGO.

Weihnachten 2017: Kernel-Entwickler arbeiten durch. Neujahr 2018 ebenso. Der Grund: eklatante Hardwarefehler in Computerprozessoren, dem Gehirn unserer PCs. Die Wissenschaftler taufen diese „Meltdown“ und „Spectre“, „Kernschmelze“ und „Schreckgespenst“.

Sommer 2020. Inzwischen sind wir in Monat #32 nach Bekanntwerden dieser Hardwarelücken. Was der aktuelle Stand?

Folgender:

SUMMARY: CVE-2017-5753, CVE-2017-5715, CVE-2017-5754, CVE-2018-3640, CVE-2018-3639, CVE-2018-3615, CVE-2018-3620, CVE-2018-3646, CVE-2018-12126, CVE-2018-12130, CVE-2018-12127, CVE-2019-11091, CVE-2019-11135, CVE-2018-12207

Oben: Zusammenfassung aktueller CPU-Lücken des Tools spectre-meltdown-checker, Stand August 2020

Aus drei Lücken (CVE-2017-5753, CVE-2017-5715, CVE-2017-5754) wurden 14. In Worten: Vierzehn.

Selbst AMD scheint auch 2020 nicht in der Lage zu sein Prozessoren zu bauen, die alle Fehler ausschließen können.

Unterziehe ich meinen neuesten AMD-Prozessor, den 4800HS, einem Test mit dem kostenlosen OpenSource-Tool spectre-meltdown-checker, wird klar, dass besonders ein Bug hardwaretechnisch bisher unmöglich zu beseitigen scheint.

Es ist jener mit den Kennungen CVE-2017-5753 aka ‚Spectre Variant 1, bounds check bypass‘, CVE-2017-5715 aka ‚Spectre Variant 2, branch target injection‘ und CVE-2018-3639 aka ‚Variant 4, speculative store bypass‘, bekannt als „Spectre“, das „Schreckgespenst“.

Ohne die pausenlose Arbeit zum Jahreswechsel 2017/2018 der weltweiten Entwickler-Community, wären selbst AMD-CPUs des Jahres 2020 hier verwundbar. Die gelisteten drei Varianten von Spectre sind ledliglich softwareseitig gepatcht und damit seit über 2,5 Jahren auf keinem aktuelleren Stand als damals.

Mir ist das zu lange. Als Entwickler, wie als Anwender.

Von 14 Hardwarefehlern sind 11 aus der Welt und drei nach wie vor vorhanden. Willkommen in der neuen Realität der 78,57%-PC-Hardware für 100% hardverdientes Geld! Was ein Scheißdreck.

Whoa! KDE macht offenbar in Ultrabooks:

Direkt der Slimbook-Website entnommen

Und die Dinger sehen auch noch hardwaretechnisch supersexy aus! Passend zur Desktopumgebung! 🙂

Mit 899€ auch zu einem sehr humanen Preis, wie ich finde: dafür erhält man ein 14“-HD-IPS-LED-Display mit leistungsstarkem AMD Ryzen 4800H-Prozessor (8 Kerne, 16 Threads, integrierte Radeon-Grafikkarte mit 1,43 T(!)FLOPS), der erst im Januar auf der CES öffentlich vorgestellt wurde (hier nochmal der Bericht). Eine bisschen mickrige 250GB-SSD, sowie 8GB RAM ebenso.

Wer will, kann über den Onlineshop das Setup jedoch noch nach Belieben (oder was der eigene Geldbeutel hergibt) aufstocken. Im Kurzbesuch konnte ich bis zu 64GB RAM und eine 2TB Samsung-SSD ohne Probleme finden, siehe: https://slimbook.es/en/store/slimbook-kde/kde-slimbook-14-comprar.

Das Geilste aber ist natürlich: KDE Neon vorinstalliert!

Die auf Debian bzw. Ubuntu LTS basierende Linux-Distribution gilt als bleeding edge und liefert immer das Neueste und Feinste von KDE frei Haus. Und das noch gar nicht lange: sie ist erst vier Jahre alt, wurde 2016 ins Leben gerufen. Aktuell ist sie mit Platz 11 locker in den TOP20 von distrowatch.com zu finden. Sehr populär also.

Wem 14“ zu klein sind, kein Problem: für nur 30€ mehr erhält man das 15“-Modell.

Fazit: hardwaretechnisch und von Betriebssystemseite erste Sahne und wenn die Verarbeitung nur halb so geil ist, wie sie aussieht, für mich ein Anwärter auf das Gadget des Jahres!

Schon extremst geil und wirklich heftigst eye candy plus cyberpunk:

eDEX-UI ist ein Terminalemulator, wie man ihn von PC-Interfaces aus Scifi-Filmen wie „Tron“ und „Alien“ kennt. Er läuft auf allen gängigen Plattformen, Linux bevorzugt, aber auch Mac oder sogar Windows mit wenigen Einschränkungen.

Das Programm aus der Zukunft ist frei hier erhältlich: https://github.com/GitSquared/edex-ui.

Nach der Installation erwartet einen ein Echtzeitmonitor für CPU, RAM, Swap und laufende Prozesse, sowie das Netzwerk. Für Touchscreens liefert er eine entsprechende Tastatur mit, die sich bei Nichtbedarf auch ausblenden lässt. In jedem Interface ist ein Verzeichnis-Browser eingebaut. Und: natürlich enthält er immer auch die entsprechende Konsole zum Arbeiten oder Experimentieren.

Das Customising kann man selbst übernehmen, braucht dafür allerdings das Wiki. Das sind schon erweiterte Konfigurationen, die man hier durchführen muss, nicht jeder kennt sich beispielsweise mit CSS-Injections aus.

Wer möchte, kann sich auch zum Konsolen-Skin entsprechende Sounds einblenden lassen.

Oben zu sehen ist der Skin neofetch mit eDEX-UI 2.2 und dem Standard-„Tron“-Thema. Ein Stückchen weiter unten das Thema „interstellar“ mit den geöffneten Grafikeinstellungen der Applikation.

Fettestes Projekt, absolute Empfehlung! Viel Spaß beim Ausprobieren!

Erst im Januar hatte AMD auf der CES in Las Vegas der Welt die neue 4000er-Serie seiner leistungsstarken Ryzen-Prozessoren vorgestellt. Unter anderem auch den 4800H(S), der in einem 14-Zoll-Exzellenz-Gaming-Notebook von ASUS präsentiert wurde, die sechs Monate das Exklusivrecht für die Veröffentlichung dieser CPUs halten sollten.

Das passte ganz gut in meine eigenen Hardwareplanungen, hatte ich mir doch seit 2011 keinen Rechner mehr gegönnt. Und die Thematik mit Meltdown und Spectre machte ab 2018 ja alles nur noch viel schlimmer und ätzender. Es war mal wieder allerhöchste Zeit, Intel so richtig in den A**** zu treten!

Die Notebook-Prozessoren von AMD spielen mittlerweile in einer eigenen Liga. Kein Vergleich mehr zu meiner letzten AMD-Hardware aus 2005, damals war der Turion64 „ultramodern“ und 64bit war d-e-r heiße Scheiß, die CPUs aber wie immer von AMD im Notebook viel zu laut und viel zu warm.

Die Hardware, die ich seit letzter Woche nun mein Eigen nennen darf, gilt aktuell als beste Laptop-CPU der Welt, neben dem 4900er-Modell, der Ryzen 7 4800HS.

Wie es der Zufall so wollte bin ich seit 2018 im CPU-Benchmarking-Territorium unterwegs, zumindest in meiner Freizeit. Was lag da also näher, als sich den Prozessor mal mit dem Tool HPL (High Performance Linpack) vorzunehmen, der Benchmark-Suite, mit der auch die TOP500-Liste der Supercomputer seit Jahren gebenchmarkt wird? Eben!

Gesagt, getan, Freitag Abend drei Stunden Arbeit investiert und das Ergebnis meiner Maschine kann sich doch durchaus sehen lassen, wie ich finde:

================================================================================

HPLinpack 2.2 — High-Performance Linpack benchmark — February 24, 2016

Written by A. Petitet and R. Clint Whaley, Innovative Computing Laboratory, UTK

Modified by Piotr Luszczek, Innovative Computing Laboratory, UTK

Modified by Julien Langou, University of Colorado Denver

================================================================================An explanation of the input/output parameters follows:

T/V : Wall time / encoded variant.

N : The order of the coefficient matrix A.

NB : The partitioning blocking factor.

P : The number of process rows.

Q : The number of process columns.

Time : Time in seconds to solve the linear system.

Gflops : Rate of execution for solving the linear system.The following parameter values will be used:

N : 13920

NB : 240

PMAP : Row-major process mapping

P : 1

Q : 2

PFACT : Right

NBMIN : 4

NDIV : 2

RFACT : Right

BCAST : 2ring

DEPTH : 1

SWAP : Spread-roll (long)

L1 : transposed form

U : transposed form

EQUIL : yes

ALIGN : 8 double precision words——————————————————————————–

– The matrix A is randomly generated for each test.

– The following scaled residual check will be computed:

||Ax-b||_oo / ( eps * ( || x ||_oo * || A ||_oo + || b ||_oo ) * N )

– The relative machine precision (eps) is taken to be 1.110223e-16

– Computational tests pass if scaled residuals are less than 16.0================================================================================

T/V N NB P Q Time Gflops

——————————————————————————–

WR12R2R4 13920 240 1 2 7.23 2.486e+02

HPL_pdgesv() start time Fri Jul 10 23:17:19 2020HPL_pdgesv() end time Fri Jul 10 23:17:26 2020

——————————————————————————–

||Ax-b||_oo/(eps*(||A||_oo*||x||_oo+||b||_oo)*N)= 0.0046572 …… PASSED

================================================================================Finished 1 tests with the following results:

1 tests completed and passed residual checks,

0 tests completed and failed residual checks,

0 tests skipped because of illegal input values.

——————————————————————————–End of Tests.

================================================================================

Wie zu erwarten war schneidet das 8-Kerne-AMD-Biest formidabel ab, das Endergebnis des etwas über 7 Sekunden dauernden und alle acht Kerne ausnutzenden Tests ging voll auf den L3-Cache, der hier zwei Mal vorhanden ist und je 4MB beträgt: 248,6 GFLOPS!

I <3 it! Selbst nur im Akkumodus und vom Stromnetz getrennt kam der Prozessor noch auf 210,4 GFLOPS.

Ich kann mir nicht helfen, aber ich habe selten so eine krasse, alleinige CPU-Leistung von einem meiner Heimgeräte gesehen. Gut, die PS3 war auch noch gut dabei, bis heute übrigens, obwohl die Hardware aus 2007/2008 stammt. Der Ryzen 7 4800HS ist also die zweite CPU in meinem Haushalt, die über 200 GFLOPS mit HPL erreicht. Hut ab, AMD, gerne mehr davon!

Solche Benchmarks selbst durchzuführen, v.a. unter Linux, ist eine Kunst, die selbst mich als Berufsinformatiker immer wieder vor Herausforderungen stellt. Man merkt das schon sehr gut bei der Recherche zu dem Thema, wo nie Tools gelistet sind, die außerhalb der Intel-Welt ein Ergbnis in (G)FLOPS liefern. Wie kompliziert das hier war und wie man den Test erfolgreich durchführt, bei noch viel komplizierterer Vorkonfiguration, erläutere ich gerne mal in einem anderen Beitrag. Stay tuned! 😉

Was Unterstützung für Linux betrifft, so ist Canon aus Japan beileibe kein A****loch-Hersteller: für meinen Drucker TR 8550 aus 2017/2018 gibt es wenigstens Treiber für Debian Linux und RPM-basierte wie z.B. Fedora. Wenngleich die seit Ende 2017 auch nie mehr einem Update unterzogen wurden…

Wie Canon in den 80ern Populärkultur wurde: dank „Akira“!

Nur was mit Arch oder auf Arch basierenden Derivaten? Viel Spaß mit der Installation über den Sourcecode!

Nee, das funktioniert nicht. Ehrlich jetzt.

Ich hatte noch ein funktionierendes Setup auf einem anderen Linux-Rechner, aber selbst meine manuell kopierten Dateien (cmdtocanonij2, cmdtocanonij3, rastertocanonij) nach /usr/lib/cups/filter/ brachten das Mistding nicht ans Laufen. Ich bekam beim Druckversuch einer Testseite nur immer wieder die Meldung „Filter failed“.

In einer Onlinerecherche kam irgendwo (ich spare mir Links, keine Zeit, hier auch unnötig), das bedeute „eine Vielzahl von Fehlern“, ich solle debuggen.

Nee, das funktioniert heute nicht. Nicht heute. Und morgen auch nicht. Und auch nicht irgendwann nächstes Jahr.

Phew, was tun?

Wir werden pervers! Aber so richtig! Wir konvertieren das erhältliche *.deb-Paket in eine Arch-Installationsdatei, die pacman dann essen muss! Völlig egal, ob es funktioniert oder nicht danach! Muhahahaha!

Das Tool, das dies erledigt, nennt sich debtap und ist über offizielle Quellen nicht erhältlich, man muss das inoffizielle AUR anzapfen. Doch selbst dann läuft es nicht einfach von selbst, man muss indizieren lassen, aber wie das alles genau geht steht hier, denn den Link share ich gerne weiter: https://ostechnix.com/convert-deb-packages-arch-linux-packages/.

Der Befehl, der die Konvertierung durchführt, lautet schließlich so:

debtap cnijfilter2_5.50-1_amd64.deb

Der hat wahrscheinlich eine halbe Ewigkeit Gültigkeit, denn der Treiber wird von Canon für Pinguinnutzer ja eh nie geupdatet.

Man kann übrigens die Fragen, die sich hier stellen, nach Belieben ausfüllen, das ist nicht wichtig. Heraus kommt eine cnijfilter2-5.50-1-x86_64.pkg.tar.zst, die man nur noch mit sudo pacman -U installieren muss. DONE!

Gestern, nach 22:00, end-lich funktioniert’s!

Gut, bei mir schlug die Installation erst einmal fehl, denn meine manuell kopierten Dateien waren ja noch da, worüber sich pacman beschwert hat. Doch nach dem Löschen dieser war dann eine Installation ohne Fehlermeldung möglich. Danke debtap, danke pacman, danke TCP/IP!

Mit diesem Tutorial wollte ich mehrere Dinge auf einmal zeigen:

1) die erfolgreiche Installation des Druckers TR 8550 von Canon unter Arch Linux bzw. einem der vielen Derivate

2) dass eine manuelle Installation fehl schlägt (verschwendete Lebenszeit!)

3) was das Tool debtap ist und warum wir hier pervers werden müssen

4) warum Versuch manchmal kluch macht

5) get it running or die tryin‘!

Wenn diese Exkursion in die Tiefen der Linux-Druckertreiber-Höllen bei euch auch zum Erfolg geführt hat, klickt doch auf einen der Buttons und spendet bitte! KTHXBYE! <3

Linux-Distributionen für die PlayStation 3 sind sehr rar, was zum einen an der von Wenigen benutzten CPU-Architektur ppc64 liegt; für mich bis heute unverständlich, gehört diese Architektur doch mit zu den modernsten und jüngsten überhaupt. Mit Red Ribbon GNU Linux lag uns bis Mitte 2018 dennoch eine inoffizielle Debian-Distribution vor, die man bis hoch zur Version 8.11 aktuell halten konnte. Danach waren Updates, nicht einmal Sicherheitsupdates, mehr möglich, da ppc von den Debian-Paketquellen-Maintainern nicht unterstützt wurde. Sonst hätte man damit noch locker bis zum 30. Juni diesen Jahres arbeiten können.

Dieser Umstand bzw. diese Not führt mich als PS3-Linux-Entwickler immer mal wieder zu den verschiedensten Ecken des Web, wo ich Fragen stelle und mich umhöre, ob wir nicht doch einen Workaround finden können zwischenzeitlich. Und siehe da: im letzten Monat wurde ich bei reddit fündig, wo jemand kurzerhand eine PS3-Distribution basierend auf Alpine Linux zusammengestellt hat:

https://github.com/fasif/AlpinePPC64.

Alpine Linux kannte ich bis dato gar nicht, Distrowatch liefert mir anschließend allerlei Informationen wie dass es aus Norwegen stammt, regulär oft auf Routern und Telefoniesystemen zum Einsatz kommt, und auch wie das Logo ausschaut:

Das Geilste aber ist der Kernel, mit dem diese PS3-Distribution läuft: hier wurde mein eigener 3.15.10er aus Ende 2018 dafür benutzt! 😀

Alle meine PS3-Kernels werden auf der PS3 selbst gebaut. Die Hardware braucht für das Kompilieren dafür oft mehrere Stunden. Im Zuge des Spectre-Meltdown-Desasters 2018, das so ziemlich alle OoOE-CPUs betraf und dazu zählt nun mal auch der Cell-Prozessor, hat dazu geführt, dass ich auch versucht habe 4er-Kernels zu bauen (siehe hier). Es scheiterte am Ende jedoch immer wieder an zu alten IBM-Patches. Die zu aktualisieren fiel mir schwer, kannte ich nämlich die Syntax nicht und begegnet sind mir solche Patches bis 2018 auch nie. Am Ende fehlten nicht viele (Link zur Übersicht), für etwaige Hilfe und Fehlersuche stellte ich auch *.rej-Dateien zur Verfügung. Allein, mir ist bis heute nicht bekannt, dass die Patches irgendwo aktualisiert zur Verfügung stünden, um einen lauffähigen 4.x.x-Kernel für eine CFW-PS3 zu bauen. Wäre mir das damals gelungen, diese neue PS3-Linux-Distribution weiter oben hätte dann einen aktuelleren Kernel als 3.15.10 gehabt. Immerhin ist mein Kernel aber neuer als der 3.12.6er, der mit Red Ribbon ausgeliefert wird und auch nie einem Update unterzogen wurde in der Lebensspanne der Distribution.

Es ist wie es ist und eigentlich habe ich auch mal wieder Lust mich am Kompilieren eines 5.x.x-Kernel für die PS3 zu versuchen. Allein, mir fehlt nach wie vor die Zeit dazu.

Trotzdem, es ist schön zu sehen, dass geleistete Arbeit für F/OSS auch von anderen verwertet wird, verwertet werden kann. Das ist einer der riesengroßen Vorteile der OpenSource-Bewegung und eine Leistung, auf die wir nicht umsonst sehr stolz sind.

Die PS3 mit ihrer besonderen und wertvollen Architektur aus den Jahren 2007/2008 ist nicht die einzige Hardware, die auf diese Weise weiter am Leben gehalten werden kann und generationenübergreifend für weitere Faszination und spannende Coding-Projekte sorgen wird. Eine nagelneue Linux-Distribution aus dem Nirgendwo ist schon eine Hammermeldung, wie ich finde.

Heute läuft der letzte Tag von versendeten Arbeitspaketen an unsere SETI@home-Clients.

Mein lokaler Client möchte sich deshalb heute persönlich verabschieden, inklusive wohl historischem Zeitstempel:

(Klicken zum Vergrößern, 6MB-Originaldatei)

Mit der Einstellung des Projekts stirbt auch eine gewisse Menschheitshoffnung. Liegt ja leider mit den aktuellen globalen Entwicklungen der letzten 20 Jahre sehr hart im Trend.

Ich bin gespannt, wann und welche Ergebnisse uns das Projekt liefern wird. Sehr wahrscheinlich werden wir direkt über die Projekt-Website informiert werden, https://setiathome.berkeley.edu/. Ich denke jedoch nicht, dass wir hier allzu viel erwarten sollten. Hätte es all die Jahre etwas wirklich Interessantes zu berichten gegeben, es hätte sich schwerlich verheimlichen lassen können.

Danke für die Möglichkeit zu diesem einzigartigen Projekt beitragen zu können und alles Gute! Es war mein erstes und ältestes Distributed Computing-Projekt und zählte fast 18 Jahre.

Im Normalfall bin ich kein großer Liebhaber von Laptops unter einer Displaygröße von 15“, doch für das ASUS ROG Zephyrus G14 kann ich gleich mehrere Ausnahmen auf einmal machen:

Zum einen bin ich CPU-N3rd sondergleichen und auch schon jahrelanger „Fanboy“ der Underdog-CPU-Schmiede AMD. Einen entsprechenden 80×15-Button aus Anno dazumal findet sich noch heute deswegen in meiner Sidebar. Und erst am 23. Dezember, also kurz vor Weihnachten, geisterte die Meldung durch das Web, Veröffentlichungen erster Laptops mit AMDs Ryzen 4xxx-er-Prozessorserie stünden kurz bevor, sowohl von ASUS, als auch HP. Die passenden Links lieferte ein spanischer Onlinehändler und machte diese Gerüchte dann „wahr“. Was fehlten, waren Fotos entsprechender Hardware. Komischerweise sind die Links heute auch nicht mehr erhältlich.

Im Zuge der Konsumentenmesse CES in Las Vegas hat zumindest ASUS das Geheimnis dann gelüftet. Deren subtiles Meisterwerk ist ein Laptop-Powerhouse im 14“-Format, das in zwei Farben ab dem 2. Quartal für ca. 1.299€-1.499€ erhältlich sein soll.

Was zuallererst dabei auffällt ist der ungewöhnliche Laptop-Deckel (siehe oben): es gibt nämlich ein Modell extra für G33ks, das 1.200(!) programmierbare(!) Mini-LEDs auf der Außenhülle mitbringt! Die Möglichkeiten zur Visualisierung scheinen hier unbegrenzt, auf der Messe selbst konnten sich schon diverse Hacker austoben, man findet viele Fotos wenn man in Suchmaschinen die Bildsuche anwirft und nach „AniMe Matrix“ sucht – so heißt dieses Feature nämlich offiziell im Sprech des Herstellers aus Taiwan.

Von der Optik wieder weg zum eigentlichen Novum: das leistungsfähige Maschinengehirn wird ein AMD Ryzen 4800H sein. Nicht nur die Typbezeichnung wurde inzwischen konkretisiert, diese SoC („SystemOnAChip“) bringt diesmal acht Zen2-Kerne mit. Höchste Taktung wird bei schönen 4,2GHz liegen. Pro Kern. Gepaart mit der zuletzt Anfang 2018 in die Schlagzeilen geratenen „Hyperthreading“-Technologie (Meltdown und Spectre und Konsorten, wir erinnern uns), stehen dem Betriebssystem hier also satte 16 Threads zur Verfügung. Und das bei nur 45W Leistungsaufnahme, möglichgemacht durch eine 7nm-Herstellungstechnologie, u.a. Weitere Daten zur CPU findet man direkt bei AMD oder z.B. Notebookcheck.

Ich selbst wäre hier bereits bedient gewesen.

Auch mache ich mir nichts aus den mitgelieferten Grafikeinheiten dieser SoCs.

Doch eine weitere Eigenart dieses Modells ist, dass man in einem G15 z.B. nicht finden wird: die Nvidia GeForce RTX 2060 Max-Q.

Jep, richtig gelesen: ASUS ist einer der wenigen Hersteller weltweit, der Highendgrafikkarten von Nvidia in AMD-Laptops verbaut (leider). Ich war schon immer großer Fan und auch Anwender dieser Kombo, weil Linux halt und Treibergedönsen; wissen schon. Für mich ist solche exotische Hardware daher sehr, sehr, sehr sehr attraktiv…

Diese Leistung wird hier einmalig sein. Selbst der 15“-Bruder wird prozessor- und grafikkartenseitig diesem Gerät hier unterlegen sein, zumindest auf dem Papier. Ob das merklich in der Praxis etwas ausmachen wird, darüber kann man bereits streiten und wird das auch erst herausfinden können, wenn beide Notebooks ausgiebig kurz vor dem 2. Quartal zur Verfügung stehen und getestet werden können.

Wer das G14 noch etwas detaillierter als lebendes Objekt sehen will, dem empfehle ich auch hier die Fotos von Notebookcheck: https://notebookcheck.com/Asus-ROG-Zephyrus-G14-Das-leistungsstaerkste-14-Zoll-Gaming-Notebook-der-Welt.449298.0.html. Die meisten anderen Quellen liefern nämlich lediglich Standardbildmaterial, z.B. von ASUS-Webseiten. Ist jedoch verständlich, schließlich hat nicht jedes Onlinemedium zum Thema Gadgets die Ressourcen mal schnell nach Las Vegas für Gadget-Pr0n zu fliegen. Schade eigentlich.

Ob das Teil seinen Platz in meine h4x0r-Stuben finden wird steht in den Sternen. Für die angebotene Leistung ist der Preis nicht mal „zu hoch“, aber doch ordentlich für einen kommerziell wenig erfolgreichen Indie-Autoren wie mich. Da bräuchte ich schon zigtausende Flattr-Spenden, das wird nicht funktionieren. Zudem ärgert mich irgendwie immer noch die 14“-Zoll-Displaygröße. Ich kann nichts dafür, ich bin fast so groß wie ein Zollstock, das sähe bei mir wie Kinderspielzeug aus!11 Witzig finde ich auch, dass mir diese AniMe Matrix nicht mehr aus dem Kopf geht – was ich damit alles programmieren könnte! Und wie viel Zeit es verschwenden würde!1 Und wie sinnlos es sein würde!11 Und wie unwichtig auf lange Sicht!111 Muhahaha! Ach, wir dummen Männer: sabbern und hecheln und träumen von PC-Hardware statt vom anderen, attraktiven, natürlich perfekten Geschlecht! Zum Glück, phew, war ich in der Vergangenheit so schlau und habe diese Art von Porno zum Beruf gemacht, haha! 😀