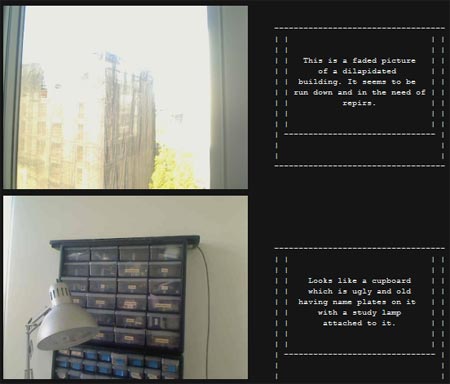

Matt Richardson hat eine ungewöhnliche Kamera entwickelt: Anstatt Bilder gibt sie Begleittexte aus, was auf diesen Bildern zu sehen ist. Das sieht dann so aus:

Solche Inhalte bleiben bei Digitalkameras nämlich immer auf der Strecke, wenngleich viele Daten wie z.B. Kameratyp, Ort, Datum, etc. gespeichert werden.

Mit diesen Metadaten in Textform kann man viel mehr machen:

„Imagine if descriptive metadata about each photo could be appended to the image on the fly—information about who is in each photo, what they’re doing, and their environment could become incredibly useful in being able to search, filter, and cross-reference our photo collections.“

Der Kern dieser Technologie, die Richardson Descriptive Camera nennt, basiert auf der Amazon-API des „Mechanical Turk“, wo man online nach Leuten sucht, die spezielle Aufträge komplettieren.

Den gesamten Arbeitsablauf, sowie viele weitere Details finden sich dort:

http://mattrichardson.com/Descriptive-Camera/.

Zu finden ist dort auch ein zehnminütiges Video, in dem das System präsentiert wird.

Leider ist das alles noch Zukunftsmusik mit dem Archivieren und Filtern und dergleichen, da bisher noch nicht sehr viele Daten zur Verfügung stehen. Spannend wird auch, ob sich das auf andere Sprachen aufsetzen lässt. Anyway: Wenn Photos sprechen lernen, dann kann man das schon als Innovation bezeichnen.